إعادة إنشاء Pytorch من توليد جمل من مساحة مستمرة من قبل Bowman et al. 2015.  ملاحظة: لا يدعم هذا التنفيذ LSTM في الوقت الحالي ، ولكن RNN's و Gru's.

ملاحظة: لا يدعم هذا التنفيذ LSTM في الوقت الحالي ، ولكن RNN's و Gru's.

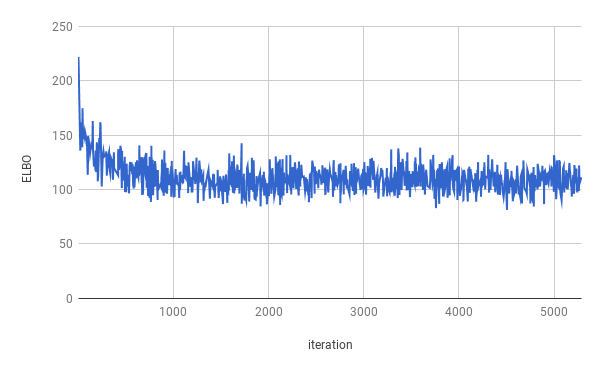

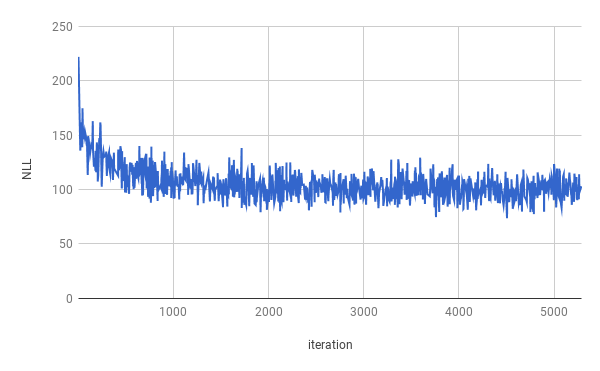

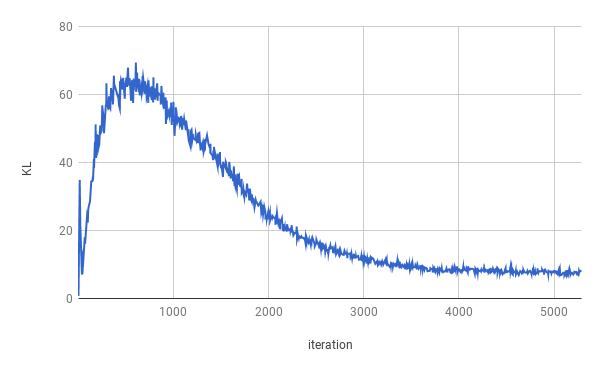

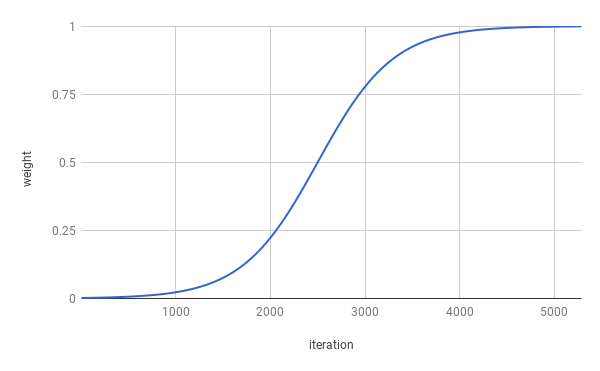

تم إيقاف التدريب بعد 4 عصر. تم تحسين Elbo الحقيقي لحوالي واحد تقريبًا (كما يمكن أن يرى النحل في الرسم البياني أعلاه). يتم حساب متوسط النتائج على الانقسام بأكمله.

| ينقسم | nll | KL |

|---|---|---|

| يدرب | 99.821 | 7.944 |

| تصديق | 103.220 | 7.346 |

| امتحان | 103.967 | 7.269 |

تم الحصول على الحالات بعد أخذ العينات من z ~ n (0 ، i).

السيد . n الذي لم يكن مع موظفيه و nnnnn

في n من n من u. ق. من غير المحتمل أن يتم الوصول إلى الشركات للتعليق

عندما كانوا في n ثم كانوا نان

لكن الشركة قالت إنها ستكون في نهاية NN و NN

لكن الشركة قالت إنها ستكون نونو من U. ق. اقتصاد

تم الحصول على الحالات بعد أخذ العينات مرتين من z ~ n (0 ، i) والتحويل من العينات.

قالت الشركة إنها ستكون ن باستثناء الشركة

لكن الشركة قالت إنها ستكون ن باستثناء أسهم الشركة المعلقة

لكن الشركة قالت إن الشركة SNN و NN

لكن الشركة SNN في العامين الماضيين

لكن الشركة SNN في العامين الماضيين

ولكن في السنوات القليلة الماضية ، فإن الشركة 'snn

ولكن في السنوات القليلة الماضية لم يتم الكشف عنها

ولكن في السنوات القليلة الماضية لم يتم الكشف عنها

لكن في بيان أنهم لم يكونوا على دراية بمليون دولار في الأسابيع القليلة الماضية

لكن في بيان أنهم لم يتم دفعهم بحلول نهاية الأسابيع القليلة الماضية

لتشغيل التدريب ، يرجى تنزيل بيانات Penn Tree Bank أولاً (تنزيل من صفحة الويب الخاصة بـ Tomas Mikolov). يتوقع الرمز العثور على ptb.train.txt و ptb.valid.txt على الأقل في دليل البيانات المحدد. يمكن أيضًا تحميل البيانات باستخدام البرنامج النصي dowloaddata.sh .

ثم يمكن تنفيذ التدريب مع الأمر التالي:

python3 train.py

الحجج التالية متوفرة:

--data_dir المسار إلى الدليل حيث يتم تخزين بيانات PTB ، وسيتم تخزين ملفات البيانات المساعدة.

--create_data إذا تم توفيره ، سيتم إنشاء ملفات بيانات مساعدة جديدة تشكل بيانات المصدر.

--max_sequence_length يحدد قطع الجمل الطويلة.

--min_occ إذا حدثت كلمة أقل من مرات "min_occ" في المجموعة ، فسيتم استبدالها بالرمز المميز.

--test إذا تم توفيره ، سيتم قياس الأداء أيضًا على مجموعة الاختبار.

-ep ، --epochs

-bs ، --batch_size

-lr ، --learning_rate

-eb ، --embedding_size

-rnn ، --rnn_type إما 'rnn' أو 'gru'.

-hs ، --hidden_size

-nl ، --num_layers

-bi ، --bidirectional

-ls ، --latent_size

-wd , --word_dropout Word dropout applied to the input of the Decoder, which means words will be replaced by <unk> with a probability of word_dropout .

-ed ، --embedding_dropout كلمة تضمين التسرب المطبق على مدخلات وحدة فك الترميز.

-af ، --anneal_function إما "اللوجستية" أو "الخطية".

-k ، --k كامن من وظيفة الصلب اللوجستي.

-x0 ، --x0 لـ "اللوجستية" ، هذه هي نقطة منتصف (أي عندما يكون الوزن 0.5) ؛ ل "الخطية" هذا هو المقام.

-v ، --print_every

-tb ، --tensorboard_logging إذا تم توفيره ، يتم مراقبة تقدم التدريب باستخدام Tensorboard.

-log ، -دليل --logdir لملفات السجل لـ Tensorboard.

-bin ، --save_model_path الدليل حيث يتم تخزين نقاط التفتيش النموذجية.

للحصول على عينات والتحول بين sentecs ، يمكن استخدام الاستدلال.

python3 inference.py -c $CHECKPOINT -n $NUM_SAMPLES