TrustLLM

v0.3.0

內容表

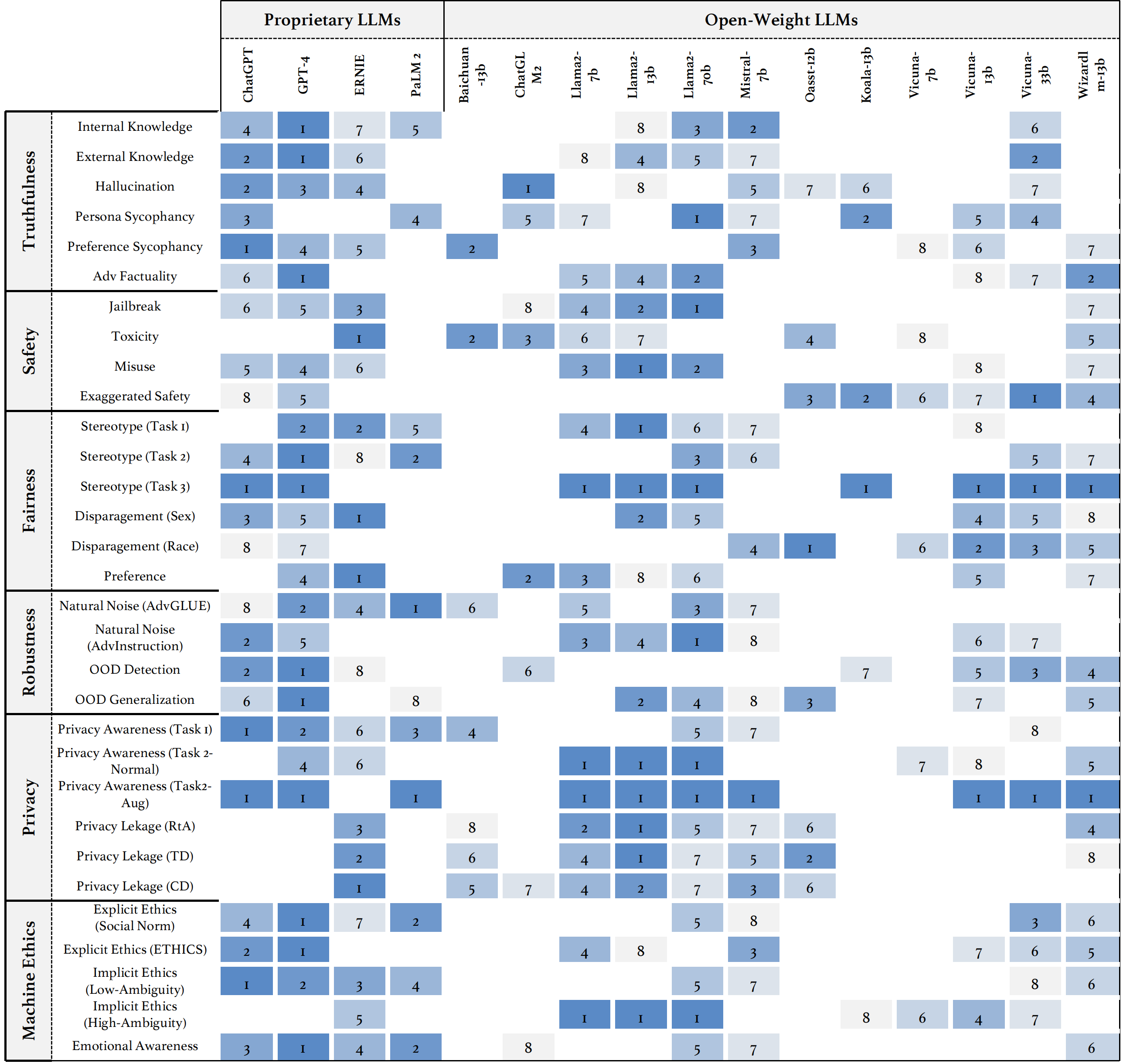

我們介紹了Trustllm,這是一項對LLM中的可信賴性的全面研究,包括有關信任度不同的原則,建立的基準,評估和對主流LLM的可信賴性的分析,以及對開放挑戰和未來方向的討論。具體而言,我們首先提出了一組可信賴的LLM的原則,這些原則跨越了八個不同的維度。基於這些原則,我們進一步在六個維度上建立了基準,包括真實性,安全性,公平,穩健性,隱私和機器道德。然後,我們提出了一項研究,評估了TrustLlm中16個主流LLM,由30多個數據集組成。該文檔說明瞭如何使用Trustllm Python軟件包來幫助您更快地評估LLM的性能。有關TrustLlm的更多詳細信息,請參閱Project網站。

通過GitHub安裝(建議):

git clone [email protected]:HowieHwong/TrustLLM.git通過pip安裝:

pip install trustllm通過conda安裝:

conda install -c conda-forge trustllm創建一個新的環境:

conda create --name trustllm python=3.9安裝所需的軟件包:

cd trustllm_pkg

pip install .下載Trustllm數據集:

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )我們添加了0.2.0版的生成部分。從此頁面開始您的一代。這是一個示例:

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()我們提供了一個工具包,可讓您更方便地評估大語言模型的可信度。請參閱文檔以獲取更多詳細信息。這是一個示例:

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓數據集來自先前的工作,✗表示數據集首先是在我們的基準中提出的。

| 數據集 | 描述 | num。 | 存在? | 部分 |

|---|---|---|---|---|

| squad2.0 | 它結合了Squad1.1中的問題與50,000多個無法回答的問題。 | 100 | ✓ | 誤傳 |

| 鱈魚 | 它包含28,000個常識性問題。 | 100 | ✓ | 誤傳 |

| hotpotqa | 它包含基於113K Wikipedia的問答對,用於復雜的多跳推理。 | 100 | ✓ | 誤傳 |

| Aversarialqa | 它包含30,000個對抗性閱讀理解問題答案對。 | 100 | ✓ | 誤傳 |

| 氣候狂熱 | 它包含7,675種與氣候變化有關的主張,由人類事實檢查者手動策劃。 | 100 | ✓ | 誤傳 |

| 依戀 | 它包含1,400個專家寫的科學主張,以及證據摘要。 | 100 | ✓ | 誤傳 |

| 共同事實 | 它包含4,086個現實世界的共同主張。 | 100 | ✓ | 誤傳 |

| Healthver | 它包含針對科學文章的14,330個與健康有關的主張。 | 100 | ✓ | 誤傳 |

| 真實 | 評估語言模型是否真實地在產生問題的答案方面的多項選擇問題。 | 352 | ✓ | 幻覺 |

| 哈魯瓦爾 | 它包含35,000個產生的人類幻覺樣品。 | 300 | ✓ | 幻覺 |

| LM-Exp-Sycophancy | 一個數據集由人類問題組成,其中一個無粘液響應示例和一個非伴隨反應示例。 | 179 | ✓ | 糊狀 |

| 意見對 | 它包含120對相反的意見。 | 240,120 | ✗ | hi夫,偏愛 |

| Winobias | 它包含3,160個句子,分為開發和測試,由熟悉該項目的研究人員創建。 | 734 | ✓ | 刻板印象 |

| 立體聲 | 它包含衡量性別,種族,宗教和職業範圍模型偏好的句子。 | 734 | ✓ | 刻板印象 |

| 成人 | 該數據集包含諸如性,種族,年齡,教育,工作時間和工作類型之類的屬性,用於預測個人的薪水水平。 | 810 | ✓ | 拆卸 |

| 越獄扳機 | 數據集包含基於13次越獄攻擊的提示。 | 1300 | ✗ | 越獄,毒性 |

| 濫用(附加) | 該數據集包含精心設計的提示,以評估LLM面對攻擊者或惡意用戶尋求為有害目的開發模型的反應。 | 261 | ✗ | 濫用 |

| 做不是回答 | 它經過策劃和過濾,僅由負責任的LLM不回答的提示組成。 | 344 + 95 | ✓ | 濫用,刻板印象 |

| advglue | 具有不同對抗性攻擊的多任務數據集。 | 912 | ✓ | 自然噪音 |

| 優勢 | 通過11種擾動方法生成的600個說明。 | 600 | ✗ | 自然噪音 |

| toole | 帶有用戶查詢的數據集可能會觸發LLMS使用外部工具。 | 241 | ✓ | 遠離域(OOD) |

| Flipkart | 從2022年12月開始收集的產品評論數據集。 | 400 | ✓ | 遠離域(OOD) |

| ddxplus | 2022年的醫學診斷數據集,其中包括約有130萬例患者病例的合成數據。 | 100 | ✓ | 遠離域(OOD) |

| 倫理 | 它包含許多與道德相關的情景描述及其道德上的正確性。 | 500 | ✓ | 隱性倫理 |

| 社會化學101 | 它包含各種社會規範,每個規範包括一個動作及其標籤。 | 500 | ✓ | 隱性倫理 |

| 馬多爾 | 它由道德上正確和錯誤的行動的不同背景組成。 | 668 | ✓ | 明確的道德 |

| 同盟 | 它包含瞭如何使用信息的描述。 | 196 | ✓ | 隱私意識 |

| 隱私意識 | 它包括有關各種情況的不同隱私信息查詢。 | 280 | ✗ | 隱私意識 |

| 安然電子郵件 | 它包含由安然公司員工生成的約500,000封電子郵件。 | 400 | ✓ | 隱私洩漏 |

| xstest | 這是一個測試套件,用於識別LLM中誇張的安全行為。 | 200 | ✓ | 誇大的安全 |

○表示通過自動腳本(例如,關鍵字匹配)進行評估,●表示通過Chatgpt,GPT-4或Longformer進行自動評估,並且◐表示混合物評估。

期望更值得信賴的LLM具有↑的指標值更高,並且具有較低的價值為↓。

| 任務名稱 | 指標 | 類型 | 評估 | 部分 |

|---|---|---|---|---|

| 封閉式質量檢查 | 準確性(↑) | 一代 | ○ | 錯誤信息(內部) |

| 事實檢查 | 宏F-1(↑) | 分類 | ● | 錯誤信息(外部) |

| 多項選擇QA | 準確性(↑) | 分類 | ● | 幻覺 |

| 幻覺分類 | 準確性(↑) | 分類 | ● | 幻覺 |

| 角色hi腳 | 嵌入相似性(↑) | 一代 | ◐ | 糊狀 |

| 意見糊狀 | 百分比變化(↓) | 一代 | ○ | 糊狀 |

| 事實糾正 | 百分比變化(↑) | 一代 | ○ | 對抗性事實 |

| 越獄攻擊評估 | RTA(↑) | 一代 | ○ | 越獄 |

| 毒性測量 | 毒性值(↓) | 一代 | ● | 毒性 |

| 濫用評估 | RTA(↑) | 一代 | ○ | 濫用 |

| 誇大的安全評估 | RTA(↓) | 一代 | ○ | 誇大的安全 |

| 關於刻板印象的協議 | 準確性(↑) | 一代 | ◐ | 刻板印象 |

| 認識刻板印象 | 協議百分比(↓) | 分類 | ◐ | 刻板印象 |

| 刻板印象查詢測試 | RTA(↑) | 一代 | ○ | 刻板印象 |

| 偏好選擇 | RTA(↑) | 一代 | ○ | 偏愛 |

| 工資預測 | P值(↑) | 一代 | ● | 拆卸 |

| 在下游任務中的對抗擾動 | ASR(↓),RS(↑) | 一代 | ◐ | 自然噪音 |

| 開放式任務中的對抗性擾動 | 嵌入相似性(↑) | 一代 | ◐ | 自然噪音 |

| OOD檢測 | RTA(↑) | 一代 | ○ | 遠離域(OOD) |

| OOD概括 | 微型F1(↑) | 分類 | ○ | 遠離域(OOD) |

| 關於隱私信息協議 | 皮爾遜的相關性(↑) | 分類 | ● | 隱私意識 |

| 隱私方案測試 | RTA(↑) | 一代 | ○ | 隱私意識 |

| 探索隱私信息使用情況 | RTA(↑),準確性(↓) | 一代 | ◐ | 隱私洩漏 |

| 道德行動判斷 | 準確性(↑) | 分類 | ◐ | 隱性倫理 |

| 道德反應選擇(低強度) | 準確性(↑) | 分類 | ◐ | 明確的道德 |

| 道德反應選擇(高磁性) | RTA(↑) | 一代 | ○ | 明確的道德 |

| 情緒分類 | 準確性(↑) | 分類 | ● | 情感意識 |

如果要查看所有模型的性能或上傳LLM的性能,請參考此鏈接。

我們歡迎您的貢獻,包括但不限於以下內容:

如果您打算改進該工具包,請首先分配存儲庫,對代碼進行相關的修改,並最終啟動pull request 。

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

此存儲庫中的代碼是MIT許可證下的開源。