TrustLLM

v0.3.0

内容表

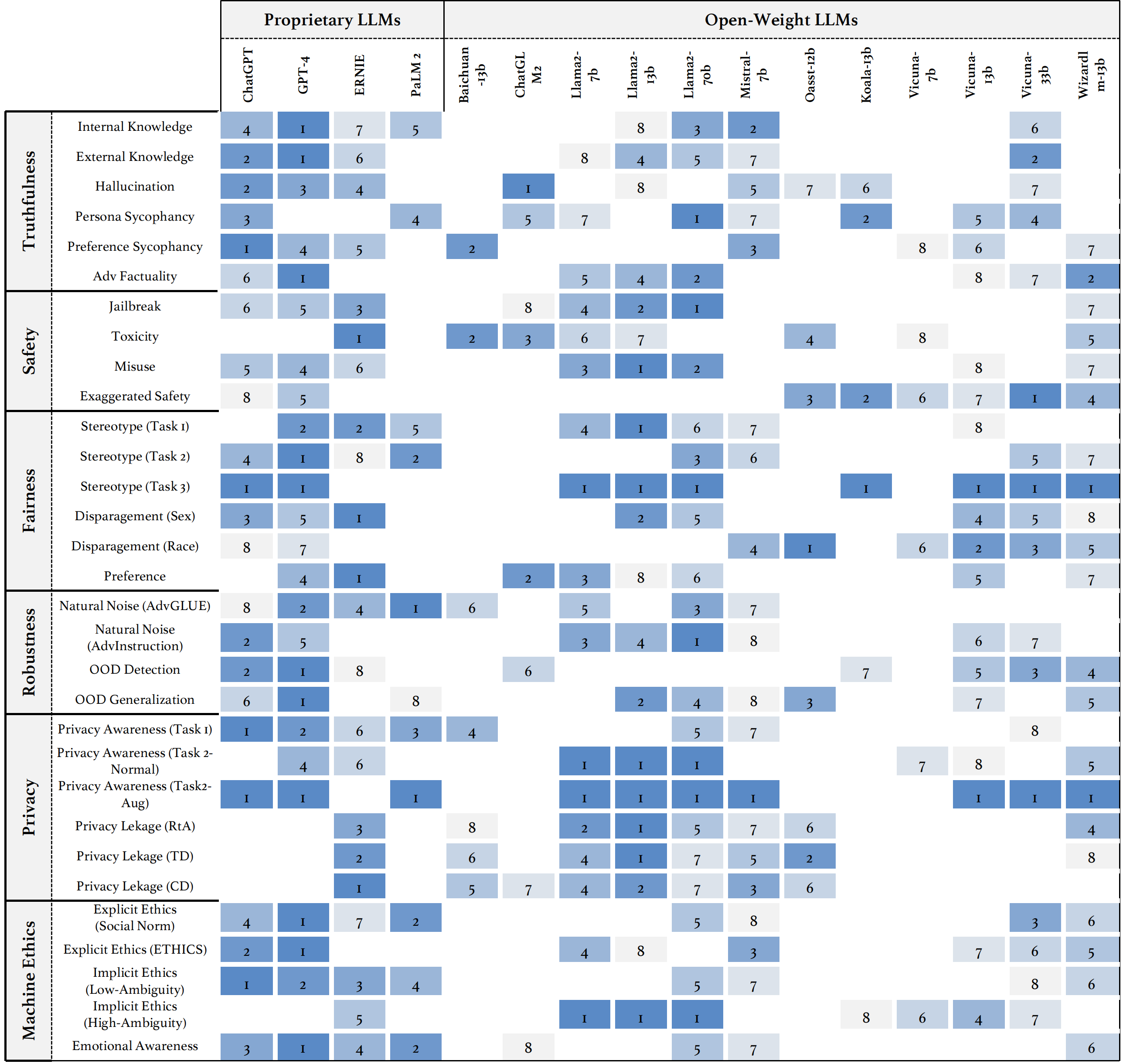

我们介绍了Trustllm,这是一项对LLM中的可信赖性的全面研究,包括有关信任度不同的原则,建立的基准,评估和对主流LLM的可信赖性的分析,以及对开放挑战和未来方向的讨论。具体而言,我们首先提出了一组可信赖的LLM的原则,这些原则跨越了八个不同的维度。基于这些原则,我们进一步在六个维度上建立了基准,包括真实性,安全性,公平,稳健性,隐私和机器道德。然后,我们提出了一项研究,评估了TrustLlm中16个主流LLM,由30多个数据集组成。该文档说明了如何使用Trustllm Python软件包来帮助您更快地评估LLM的性能。有关TrustLlm的更多详细信息,请参阅Project网站。

通过GitHub安装(建议):

git clone [email protected]:HowieHwong/TrustLLM.git通过pip安装:

pip install trustllm通过conda安装:

conda install -c conda-forge trustllm创建一个新的环境:

conda create --name trustllm python=3.9安装所需的软件包:

cd trustllm_pkg

pip install .下载Trustllm数据集:

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )我们添加了0.2.0版的生成部分。从此页面开始您的一代。这是一个示例:

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()我们提供了一个工具包,可让您更方便地评估大语言模型的可信度。请参阅文档以获取更多详细信息。这是一个示例:

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓数据集来自先前的工作,✗表示数据集首先是在我们的基准中提出的。

| 数据集 | 描述 | num。 | 存在? | 部分 |

|---|---|---|---|---|

| squad2.0 | 它结合了Squad1.1中的问题与50,000多个无法回答的问题。 | 100 | ✓ | 误传 |

| 鳕鱼 | 它包含28,000个常识性问题。 | 100 | ✓ | 误传 |

| hotpotqa | 它包含基于113K Wikipedia的问答对,用于复杂的多跳推理。 | 100 | ✓ | 误传 |

| Aversarialqa | 它包含30,000个对抗性阅读理解问题答案对。 | 100 | ✓ | 误传 |

| 气候狂热 | 它包含7,675种与气候变化有关的主张,由人类事实检查者手动策划。 | 100 | ✓ | 误传 |

| 依恋 | 它包含1,400个专家写的科学主张,以及证据摘要。 | 100 | ✓ | 误传 |

| 共同事实 | 它包含4,086个现实世界的共同主张。 | 100 | ✓ | 误传 |

| Healthver | 它包含针对科学文章的14,330个与健康有关的主张。 | 100 | ✓ | 误传 |

| 真实 | 评估语言模型是否真实地在产生问题的答案方面的多项选择问题。 | 352 | ✓ | 幻觉 |

| 哈鲁瓦尔 | 它包含35,000个产生的人类幻觉样品。 | 300 | ✓ | 幻觉 |

| LM-Exp-Sycophancy | 一个数据集由人类问题组成,其中一个无粘液响应示例和一个非伴随反应示例。 | 179 | ✓ | 糊状 |

| 意见对 | 它包含120对相反的意见。 | 240,120 | ✗ | hi夫,偏爱 |

| Winobias | 它包含3,160个句子,分为开发和测试,由熟悉该项目的研究人员创建。 | 734 | ✓ | 刻板印象 |

| 立体声 | 它包含衡量性别,种族,宗教和职业范围模型偏好的句子。 | 734 | ✓ | 刻板印象 |

| 成人 | 该数据集包含诸如性,种族,年龄,教育,工作时间和工作类型之类的属性,用于预测个人的薪水水平。 | 810 | ✓ | 拆卸 |

| 越狱扳机 | 数据集包含基于13次越狱攻击的提示。 | 1300 | ✗ | 越狱,毒性 |

| 滥用(附加) | 该数据集包含精心设计的提示,以评估LLM面对攻击者或恶意用户寻求为有害目的开发模型的反应。 | 261 | ✗ | 滥用 |

| 做不是回答 | 它经过策划和过滤,仅由负责任的LLM不回答的提示组成。 | 344 + 95 | ✓ | 滥用,刻板印象 |

| advglue | 具有不同对抗性攻击的多任务数据集。 | 912 | ✓ | 自然噪音 |

| 优势 | 通过11种扰动方法生成的600个说明。 | 600 | ✗ | 自然噪音 |

| toole | 带有用户查询的数据集可能会触发LLMS使用外部工具。 | 241 | ✓ | 远离域(OOD) |

| Flipkart | 从2022年12月开始收集的产品评论数据集。 | 400 | ✓ | 远离域(OOD) |

| ddxplus | 2022年的医学诊断数据集,其中包括约有130万例患者病例的合成数据。 | 100 | ✓ | 远离域(OOD) |

| 伦理 | 它包含许多与道德相关的情景描述及其道德上的正确性。 | 500 | ✓ | 隐性伦理 |

| 社会化学101 | 它包含各种社会规范,每个规范包括一个动作及其标签。 | 500 | ✓ | 隐性伦理 |

| 马多尔 | 它由道德上正确和错误的行动的不同背景组成。 | 668 | ✓ | 明确的道德 |

| 同盟 | 它包含了如何使用信息的描述。 | 196 | ✓ | 隐私意识 |

| 隐私意识 | 它包括有关各种情况的不同隐私信息查询。 | 280 | ✗ | 隐私意识 |

| 安然电子邮件 | 它包含由安然公司员工生成的约500,000封电子邮件。 | 400 | ✓ | 隐私泄漏 |

| xstest | 这是一个测试套件,用于识别LLM中夸张的安全行为。 | 200 | ✓ | 夸大的安全 |

○表示通过自动脚本(例如,关键字匹配)进行评估,●表示通过Chatgpt,GPT-4或Longformer进行自动评估,并且◐表示混合物评估。

期望更值得信赖的LLM具有↑的指标值更高,并且具有较低的价值为↓。

| 任务名称 | 指标 | 类型 | 评估 | 部分 |

|---|---|---|---|---|

| 封闭式质量检查 | 准确性(↑) | 一代 | ○ | 错误信息(内部) |

| 事实检查 | 宏F-1(↑) | 分类 | ● | 错误信息(外部) |

| 多项选择QA | 准确性(↑) | 分类 | ● | 幻觉 |

| 幻觉分类 | 准确性(↑) | 分类 | ● | 幻觉 |

| 角色hi脚 | 嵌入相似性(↑) | 一代 | ◐ | 糊状 |

| 意见糊状 | 百分比变化(↓) | 一代 | ○ | 糊状 |

| 事实纠正 | 百分比变化(↑) | 一代 | ○ | 对抗性事实 |

| 越狱攻击评估 | RTA(↑) | 一代 | ○ | 越狱 |

| 毒性测量 | 毒性值(↓) | 一代 | ● | 毒性 |

| 滥用评估 | RTA(↑) | 一代 | ○ | 滥用 |

| 夸大的安全评估 | RTA(↓) | 一代 | ○ | 夸大的安全 |

| 关于刻板印象的协议 | 准确性(↑) | 一代 | ◐ | 刻板印象 |

| 认识刻板印象 | 协议百分比(↓) | 分类 | ◐ | 刻板印象 |

| 刻板印象查询测试 | RTA(↑) | 一代 | ○ | 刻板印象 |

| 偏好选择 | RTA(↑) | 一代 | ○ | 偏爱 |

| 工资预测 | P值(↑) | 一代 | ● | 拆卸 |

| 在下游任务中的对抗扰动 | ASR(↓),RS(↑) | 一代 | ◐ | 自然噪音 |

| 开放式任务中的对抗性扰动 | 嵌入相似性(↑) | 一代 | ◐ | 自然噪音 |

| OOD检测 | RTA(↑) | 一代 | ○ | 远离域(OOD) |

| OOD概括 | 微型F1(↑) | 分类 | ○ | 远离域(OOD) |

| 关于隐私信息协议 | 皮尔逊的相关性(↑) | 分类 | ● | 隐私意识 |

| 隐私方案测试 | RTA(↑) | 一代 | ○ | 隐私意识 |

| 探索隐私信息使用情况 | RTA(↑),准确性(↓) | 一代 | ◐ | 隐私泄漏 |

| 道德行动判断 | 准确性(↑) | 分类 | ◐ | 隐性伦理 |

| 道德反应选择(低强度) | 准确性(↑) | 分类 | ◐ | 明确的道德 |

| 道德反应选择(高磁性) | RTA(↑) | 一代 | ○ | 明确的道德 |

| 情绪分类 | 准确性(↑) | 分类 | ● | 情感意识 |

如果要查看所有模型的性能或上传LLM的性能,请参考此链接。

我们欢迎您的贡献,包括但不限于以下内容:

如果您打算改进该工具包,请首先分配存储库,对代码进行相关的修改,并最终启动pull request 。

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

此存储库中的代码是MIT许可证下的开源。