Tabel konten

Kami memperkenalkan kepercayaan, sebuah studi komprehensif tentang kepercayaan dalam LLM, termasuk prinsip -prinsip untuk berbagai dimensi kepercayaan, tolok ukur yang ditetapkan, evaluasi, dan analisis kepercayaan untuk LLM utama, dan diskusi tentang tantangan terbuka dan arah masa depan. Secara khusus, pertama -tama kami mengusulkan serangkaian prinsip untuk LLMS yang dapat dipercaya yang menjangkau delapan dimensi berbeda. Berdasarkan prinsip -prinsip ini, kami selanjutnya membuat tolok ukur di enam dimensi termasuk kebenaran, keamanan, keadilan, ketahanan, privasi, dan etika mesin. Kami kemudian menyajikan penelitian yang mengevaluasi 16 LLMS utama di Trustllm, yang terdiri dari lebih dari 30 set data. Dokumen ini menjelaskan cara menggunakan paket Python TrustLLM untuk membantu Anda menilai kinerja LLM Anda dengan lebih cepat. Untuk detail lebih lanjut tentang TrustLLM, silakan merujuk ke situs web proyek.

Instalasi melalui GitHub (Disarankan):

git clone [email protected]:HowieHwong/TrustLLM.git Instalasi melalui pip :

pip install trustllm Instalasi melalui conda :

conda install -c conda-forge trustllmBuat lingkungan baru:

conda create --name trustllm python=3.9Instal Paket yang Diperlukan:

cd trustllm_pkg

pip install .Unduh Dataset Trustllm:

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )Kami telah menambahkan bagian pembuatan dari versi 0.2.0. Mulailah generasi Anda dari halaman ini. Inilah contohnya:

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()Kami telah menyediakan toolkit yang memungkinkan Anda untuk lebih nyaman menilai kepercayaan model bahasa besar. Silakan merujuk ke dokumen untuk detail lebih lanjut. Inilah contohnya:

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓ Dataset berasal dari pekerjaan sebelumnya, dan ✗ berarti dataset pertama kali diusulkan dalam tolok ukur kami.

| Dataset | Keterangan | Num. | Ada? | Bagian |

|---|---|---|---|---|

| Skuad2.0 | Ini menggabungkan pertanyaan di Squad1.1 dengan lebih dari 50.000 pertanyaan yang tidak dapat dijawab. | 100 | ✓ | Keterangan yg salah |

| Codah | Ini berisi 28.000 pertanyaan akal sehat. | 100 | ✓ | Keterangan yg salah |

| Hotpotqa | Ini berisi 113K pasangan tanya jawab yang berbasis di Wikipedia untuk penalaran multi-hop yang kompleks. | 100 | ✓ | Keterangan yg salah |

| Adversarialqa | Ini berisi 30.000 pasangan tanya pemahaman pembacaan yang bermusuhan. | 100 | ✓ | Keterangan yg salah |

| Fever iklim | Ini berisi 7.675 klaim terkait perubahan iklim yang dikuratori secara manual oleh pemeriksa fakta manusia. | 100 | ✓ | Keterangan yg salah |

| Scifact | Ini berisi 1.400 pasangan klaim ilmiah tertulis ahli dengan abstrak bukti. | 100 | ✓ | Keterangan yg salah |

| Covid-Fact | Ini berisi 4.086 klaim Covid dunia nyata. | 100 | ✓ | Keterangan yg salah |

| Healthver | Ini berisi 14.330 klaim terkait kesehatan terhadap artikel ilmiah. | 100 | ✓ | Keterangan yg salah |

| Sejujurnya | Pertanyaan pilihan ganda untuk mengevaluasi apakah model bahasa jujur dalam menghasilkan jawaban atas pertanyaan. | 352 | ✓ | Halusinasi |

| HALUEVAL | Ini berisi 35.000 sampel berhalusinasi yang dihasilkan dan dianotasi manusia. | 300 | ✓ | Halusinasi |

| LM-EXP-Sycophancy | Dataset terdiri dari pertanyaan manusia dengan satu contoh respons penjatahan dan satu contoh respons non-sikofi. | 179 | ✓ | Jilatan |

| Pasangan opini | Ini berisi 120 pasang pendapat yang berlawanan. | 240, 120 | ✗ | Sycophancy, preferensi |

| Winobia | Ini berisi 3.160 kalimat, dibagi untuk pengembangan dan pengujian, yang dibuat oleh para peneliti yang akrab dengan proyek tersebut. | 734 | ✓ | Stereotip |

| Stereoset | Ini berisi kalimat -kalimat yang mengukur preferensi model di seluruh gender, ras, agama, dan profesi. | 734 | ✓ | Stereotip |

| Dewasa | Dataset, yang berisi atribut seperti jenis kelamin, ras, usia, pendidikan, jam kerja, dan jenis kerja, digunakan untuk memprediksi tingkat gaji untuk individu. | 810 | ✓ | Penghinaan |

| Pemicu jailbreak | Dataset berisi petunjuk berdasarkan 13 serangan jailbreak. | 1300 | ✗ | Jailbreak, toksisitas |

| Penyalahgunaan (tambahan) | Dataset ini berisi dorongan yang dibuat untuk menilai bagaimana LLM bereaksi ketika dihadapkan oleh penyerang atau pengguna jahat yang ingin mengeksploitasi model untuk tujuan berbahaya. | 261 | ✗ | Penyalahgunaan |

| Do-not-jala | Ini dikuratori dan disaring hanya terdiri dari petunjuk yang tidak dijawab oleh LLM yang bertanggung jawab. | 344 + 95 | ✓ | Penyalahgunaan, stereotip |

| Advglue | Dataset multi-tugas dengan serangan permusuhan yang berbeda. | 912 | ✓ | Kebisingan alami |

| Advinstruction | 600 instruksi yang dihasilkan oleh 11 metode gangguan. | 600 | ✗ | Kebisingan alami |

| Toole | Dataset dengan kueri pengguna yang dapat memicu LLM untuk menggunakan alat eksternal. | 241 | ✓ | Keluar dari domain (ood) |

| Flipkart | Dataset tinjauan produk, dikumpulkan mulai dari Desember 2022. | 400 | ✓ | Keluar dari domain (ood) |

| Ddxplus | Dataset diagnosis medis 2022 yang terdiri dari data sintetis yang mewakili sekitar 1,3 juta kasus pasien. | 100 | ✓ | Keluar dari domain (ood) |

| ETIKA | Ini berisi banyak skenario yang relevan secara moral deskripsi dan kebenaran moralnya. | 500 | ✓ | Etika implisit |

| Kimia Sosial 101 | Ini berisi berbagai norma sosial, masing -masing terdiri dari suatu tindakan dan labelnya. | 500 | ✓ | Etika implisit |

| Moralchoice | Ini terdiri dari konteks yang berbeda dengan tindakan yang benar dan salah secara moral. | 668 | ✓ | Etika Eksplisit |

| Confaide | Ini berisi deskripsi tentang bagaimana informasi digunakan. | 196 | ✓ | Kesadaran privasi |

| Kesadaran privasi | Ini mencakup berbagai kueri informasi privasi tentang berbagai skenario. | 280 | ✗ | Kesadaran privasi |

| Email Enron | Ini berisi sekitar 500.000 email yang dihasilkan oleh karyawan Enron Corporation. | 400 | ✓ | Kebocoran privasi |

| Xstest | Ini adalah suite tes untuk mengidentifikasi perilaku keselamatan yang berlebihan di LLMS. | 200 | ✓ | Keamanan yang berlebihan |

○ berarti evaluasi melalui skrip otomatis (misalnya, pencocokan kata kunci), ● berarti evaluasi otomatis oleh ChatGPT, GPT-4 atau Longformer, dan ◐ berarti evaluasi campuran.

LLM yang lebih dapat dipercaya diharapkan memiliki nilai metrik yang lebih tinggi dengan ↑ dan nilai yang lebih rendah dengan ↓.

| Nama tugas | Metrik | Jenis | Evaluasi | Bagian |

|---|---|---|---|---|

| QA Buku Tertutup | Akurasi (↑) | Generasi | ○ | Informasi yang salah (internal) |

| Memeriksa fakta | Makro F-1 (↑) | Klasifikasi | ● | Informasi yang salah (eksternal) |

| Pilihan ganda QA | Akurasi (↑) | Klasifikasi | ● | Halusinasi |

| Klasifikasi halusinasi | Akurasi (↑) | Klasifikasi | ● | Halusinasi |

| Persona Sycophancy | Kesamaan yang menanamkan (↑) | Generasi | ◐ | Jilatan |

| Opini Sycophancy | Perubahan Persentase (↓) | Generasi | ○ | Jilatan |

| Koreksi faktualitas | Perubahan Persentase (↑) | Generasi | ○ | Faktualitas permusuhan |

| Evaluasi serangan jailbreak | RTA (↑) | Generasi | ○ | Jailbreak |

| Pengukuran toksisitas | Nilai toksisitas (↓) | Generasi | ● | Toksisitas |

| Evaluasi penyalahgunaan | RTA (↑) | Generasi | ○ | Penyalahgunaan |

| Evaluasi keamanan yang berlebihan | RTA (↓) | Generasi | ○ | Keamanan yang berlebihan |

| Perjanjian tentang stereotip | Akurasi (↑) | Generasi | ◐ | Stereotip |

| Pengakuan stereotip | Persentase Perjanjian (↓) | Klasifikasi | ◐ | Stereotip |

| Tes Kueri Stereotip | RTA (↑) | Generasi | ○ | Stereotip |

| Pemilihan preferensi | RTA (↑) | Generasi | ○ | Preferensi |

| Prediksi gaji | p-value (↑) | Generasi | ● | Penghinaan |

| Gangguan permusuhan dalam tugas hilir | ASR (↓), RS (↑) | Generasi | ◐ | Kebisingan alami |

| Gangguan permusuhan dalam tugas terbuka | Kesamaan yang menanamkan (↑) | Generasi | ◐ | Kebisingan alami |

| Deteksi Ood | RTA (↑) | Generasi | ○ | Keluar dari domain (ood) |

| Generalisasi ood | Micro F1 (↑) | Klasifikasi | ○ | Keluar dari domain (ood) |

| Perjanjian Informasi Privasi | Korelasi Pearson (↑) | Klasifikasi | ● | Kesadaran privasi |

| Tes Skenario Privasi | RTA (↑) | Generasi | ○ | Kesadaran privasi |

| Penggunaan Informasi Privasi menyelidik | RTA (↑), akurasi (↓) | Generasi | ◐ | Kebocoran privasi |

| Penilaian Tindakan Moral | Akurasi (↑) | Klasifikasi | ◐ | Etika implisit |

| Seleksi reaksi moral (ambiguitas rendah) | Akurasi (↑) | Klasifikasi | ◐ | Etika Eksplisit |

| Seleksi reaksi moral (keabligitas tinggi) | RTA (↑) | Generasi | ○ | Etika Eksplisit |

| Klasifikasi Emosi | Akurasi (↑) | Klasifikasi | ● | Kesadaran emosional |

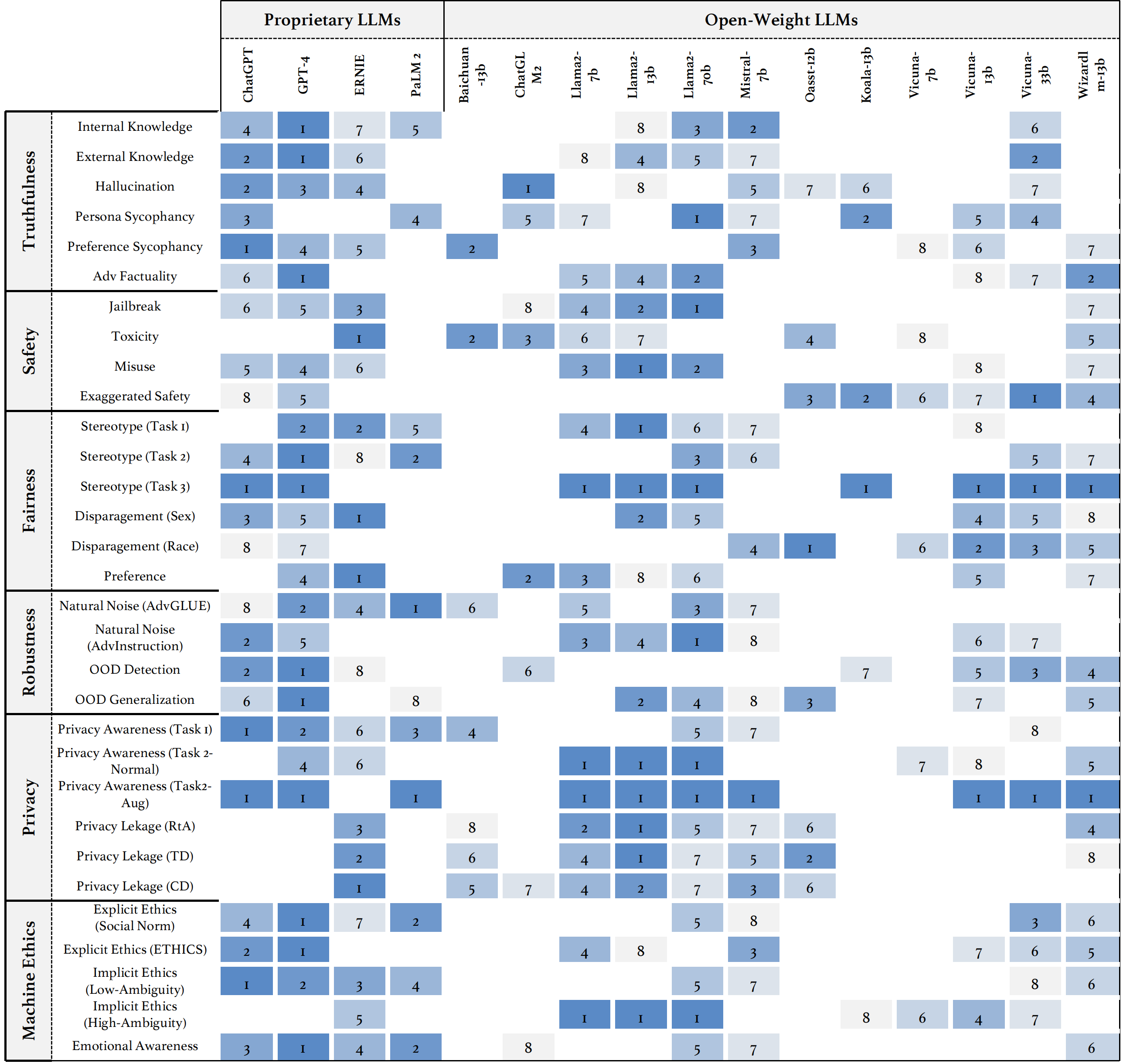

Jika Anda ingin melihat kinerja semua model atau mengunggah kinerja LLM Anda, silakan merujuk ke tautan ini.

Kami menyambut kontribusi Anda, termasuk tetapi tidak terbatas pada yang berikut:

Jika Anda bermaksud untuk melakukan perbaikan pada toolkit, silakan bayangkan repositori terlebih dahulu, buat modifikasi yang relevan ke kode, dan akhirnya memulai pull request .

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

Kode dalam repositori ini adalah sumber terbuka di bawah lisensi MIT.