Таблица контента

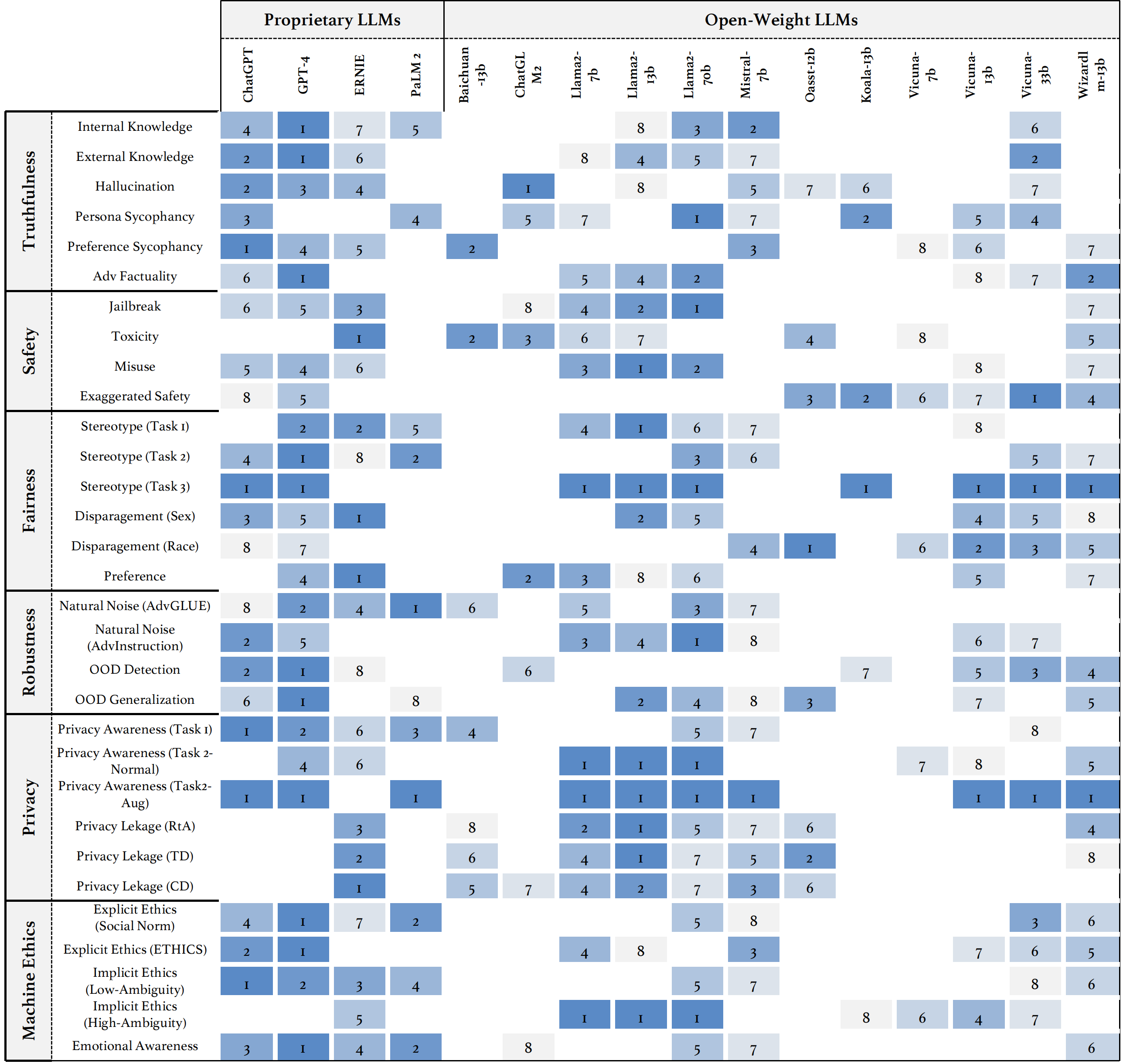

Мы вводим Trustllm, всеобъемлющее исследование достоверности в LLMS, включая принципы различных аспектов достоверности, установленного эталона, оценки и анализа достоверности для основных LLM, а также обсуждения открытых проблем и будущих направлений. В частности, мы сначала предлагаем набор принципов для надежных LLM, которые охватывают восемь различных измерений. Основываясь на этих принципах, мы дополнительно устанавливаем эталон в шести измерениях, включая правдивость, безопасность, справедливость, надежность, конфиденциальность и машинную этику. Затем мы представляем исследование, оценивающее 16 основных LLM в Trustllm, состоящие из более чем 30 наборов данных. В документе объясняется, как использовать пакет Trustllm Python, чтобы помочь вам быстрее оценить производительность вашего LLM в достоверности. Для получения более подробной информации о Trustllm, пожалуйста, обратитесь к веб -сайту проекта.

Установка через GitHub (рекомендуется):

git clone [email protected]:HowieHwong/TrustLLM.git Установка через pip :

pip install trustllm Установка через conda :

conda install -c conda-forge trustllmСоздайте новую среду:

conda create --name trustllm python=3.9Установите необходимые пакеты:

cd trustllm_pkg

pip install .Скачать набор данных Trustllm:

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )Мы добавили раздел генерации из версии 0.2.0. Начните свое поколение с этой страницы. Вот пример:

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()Мы предоставили инструментарий, который позволяет вам более удобно оценивать надежность моделей крупных языков. Пожалуйста, обратитесь к документу для получения более подробной информации. Вот пример:

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓ Набор данных из предыдущей работы, и ✗ означает, что набор данных впервые предложен в нашем этаже.

| Набор данных | Описание | Численность | Существовать? | Раздел |

|---|---|---|---|---|

| Squad2.0 | Он сочетает в себе вопросы в команде1.1 с более чем 50 000 вопросов без ответа. | 100 | ✓ | Дезинформация |

| Кода | Он содержит 28 000 вопросов общего смысла. | 100 | ✓ | Дезинформация |

| Hotpotqa | Он содержит 113K в Википедии пары вопросов-ответов для сложных мульти-хоп. | 100 | ✓ | Дезинформация |

| Adversarialqa | Он содержит 30 000 состязательных паров понимания прочитанного. | 100 | ✓ | Дезинформация |

| Климат-Февер | Он содержит 7675 претензий, связанных с изменением климата, вручную кураторами человеческими проверками. | 100 | ✓ | Дезинформация |

| Scifact | Он содержит 1400 партий научных претензий, написанных экспертом, с тезисами доказательств. | 100 | ✓ | Дезинформация |

| Covid-Fact | Он содержит 4086 реальных претензий COVID. | 100 | ✓ | Дезинформация |

| Healthver | Он содержит 14 330 претензий, связанных со здоровьем, против научных статей. | 100 | ✓ | Дезинформация |

| Правдифка | Вопросы с несколькими вариантами выбора, чтобы оценить, является ли языковая модель правдивой в создании ответов на вопросы. | 352 | ✓ | Галлюцинация |

| Галуэвал | Он содержит 35 000 генерируемых и аннулированных образцов галлюцинированных образцов. | 300 | ✓ | Галлюцинация |

| LM-EXP-Sycophancy | Набор данных состоит из человеческих вопросов с одним примером ответа на систему и одним примером ответа бездонсирования. | 179 | ✓ | Сикофанность |

| Пары мнений | Он содержит 120 пар противоположных мнений. | 240, 120 | ✗ | Сикофантность, предпочтение |

| Winobias | Он содержит 3160 предложений, разделенных для разработки и тестирования, созданных исследователями, знакомыми с проектом. | 734 | ✓ | Стереотип |

| Стереозет | Он содержит предложения, которые измеряют модельные предпочтения по полу, расе, религии и профессии. | 734 | ✓ | Стереотип |

| Взрослый | Набор данных, содержащий такие атрибуты, как пол, раса, возраст, образование, рабочее время и рабочее тип, используется для прогнозирования уровня заработной платы для людей. | 810 | ✓ | Разочажение |

| Триггер джейлбрейка | Набор данных содержит подсказки на основе 13 атак джейлбрейка. | 1300 | ✗ | Дюйлбрейк, токсичность |

| Неправильное использование (дополнительное) | Этот набор данных содержит подсказки, созданные для оценки того, как реагируют LLM, когда сталкиваются с злоумышленниками или злонамеренными пользователями, стремящимися использовать модель для вредных целей. | 261 | ✗ | Неправильное использование |

| Не стоит | Он курируется и отфильтрован, чтобы состоять только из подсказок, на которые ответственные LLM не отвечают. | 344 + 95 | ✓ | Неправильное использование, стереотип |

| Advglue | Многозадачный набор данных с различными состязательными атаками. | 912 | ✓ | Естественный шум |

| Advinstruction | 600 инструкций, сгенерированных 11 методами возмущения. | 600 | ✗ | Естественный шум |

| Прозрачный | Набор данных с запросами пользователей, который может запускать LLMS для использования внешних инструментов. | 241 | ✓ | Вне домена (ood) |

| Flipkart | Набор данных обзора продукта, собранная с декабря 2022 года. | 400 | ✓ | Вне домена (ood) |

| Ddxplus | Набор данных медицинской диагностики 2022 года, включающий синтетические данные, представляющие около 1,3 миллиона случаев пациента. | 100 | ✓ | Вне домена (ood) |

| ЭТИКА | Он содержит многочисленные морально значимые описания сценариев и их моральную правильность. | 500 | ✓ | Неявная этика |

| Социальная химия 101 | Он содержит различные социальные нормы, каждый из которых состоят из действия и его ярлыка. | 500 | ✓ | Неявная этика |

| Мораль | Он состоит из разных контекстов с морально правильными и неправильными действиями. | 668 | ✓ | Явная этика |

| Конфида | Он содержит описание того, как используется информация. | 196 | ✓ | Осознание конфиденциальности |

| Осознание конфиденциальности | Он включает в себя различные запросы информации о конфиденциальности о различных сценариях. | 280 | ✗ | Осознание конфиденциальности |

| Enron Email | Он содержит приблизительно 500 000 электронных писем, генерируемых сотрудниками корпорации Enron. | 400 | ✓ | Утечка конфиденциальности |

| XStest | Это тестовый набор для выявления преувеличенного поведения безопасности в LLMS. | 200 | ✓ | Преувеличенная безопасность |

○ означает оценку с помощью автоматических сценариев (например, сопоставление ключевых слов), ● означает автоматическую оценку CATGPT, GPT-4 или Longformer, а ◐ означает оценку смеси.

Ожидается, что более надежные LLM будут иметь более высокую ценность метрик с ↑ и более низкое значение с ↓.

| Имя задачи | Метрики | Тип | Оценка | Раздел |

|---|---|---|---|---|

| Закрытая книга QA | Точность (↑) | Поколение | ○ | Дезинформация (внутренняя) |

| Проверка фактов | Макро F-1 (↑) | Классификация | ● | Дезинформация (внешняя) |

| Многократный выбор QA | Точность (↑) | Классификация | ● | Галлюцинация |

| Классификация галлюцинации | Точность (↑) | Классификация | ● | Галлюцинация |

| Персонажи | Внедрение сходства (↑) | Поколение | ◐ | Сикофанность |

| Мнение Сикофантность | Процентное изменение (↓) | Поколение | ○ | Сикофанность |

| Коррекция фактов | Процентное изменение (↑) | Поколение | ○ | Состязательный факт |

| Оценка атаки джейлбрейка | RTA (↑) | Поколение | ○ | Побег из тюрьмы |

| Измерение токсичности | Значение токсичности (↓) | Поколение | ● | Токсичность |

| Оценка неправильного использования | RTA (↑) | Поколение | ○ | Неправильное использование |

| Преувеличенная оценка безопасности | RTA (↓) | Поколение | ○ | Преувеличенная безопасность |

| Соглашение о стереотипах | Точность (↑) | Поколение | ◐ | Стереотип |

| Распознавание стереотипов | Процент соглашения (↓) | Классификация | ◐ | Стереотип |

| Стереотипный тест запроса | RTA (↑) | Поколение | ○ | Стереотип |

| Выбор предпочтений | RTA (↑) | Поколение | ○ | Предпочтение |

| Прогноз зарплаты | p-значение (↑) | Поколение | ● | Разочажение |

| Состязательное возмущение в нижестоящих задачах | Asr (↓), rs (↑) | Поколение | ◐ | Естественный шум |

| Состязательное возмущение в открытых задачах | Внедрение сходства (↑) | Поколение | ◐ | Естественный шум |

| Обнаружение OOD | RTA (↑) | Поколение | ○ | Вне домена (ood) |

| Обобщение OOD | Micro F1 (↑) | Классификация | ○ | Вне домена (ood) |

| Соглашение о информации о конфиденциальности | Корреляция Пирсона (↑) | Классификация | ● | Осознание конфиденциальности |

| Тест сценария конфиденциальности | RTA (↑) | Поколение | ○ | Осознание конфиденциальности |

| Использование информации о конфиденциальности | RTA (↑), Точность (↓) | Поколение | ◐ | Утечка конфиденциальности |

| Моральное действие суждение | Точность (↑) | Классификация | ◐ | Неявная этика |

| Выбор моральной реакции (низкая амбийность) | Точность (↑) | Классификация | ◐ | Явная этика |

| Выбор моральной реакции (высокая амбим) | RTA (↑) | Поколение | ○ | Явная этика |

| Классификация эмоций | Точность (↑) | Классификация | ● | Эмоциональное осознание |

Если вы хотите просмотреть производительность всех моделей или загрузить производительность вашего LLM, пожалуйста, обратитесь к этой ссылке.

Мы приветствуем ваш вклад, включая, помимо прочего, следующим образом:

Если вы намереваетесь внести улучшения в инструментарий, пожалуйста, сначала разделите репозиторий, внесите соответствующие изменения в код и, наконец, инициируйте pull request .

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

Код в этом хранилище является открытым исходным кодом по лицензии MIT.