コンテンツの表

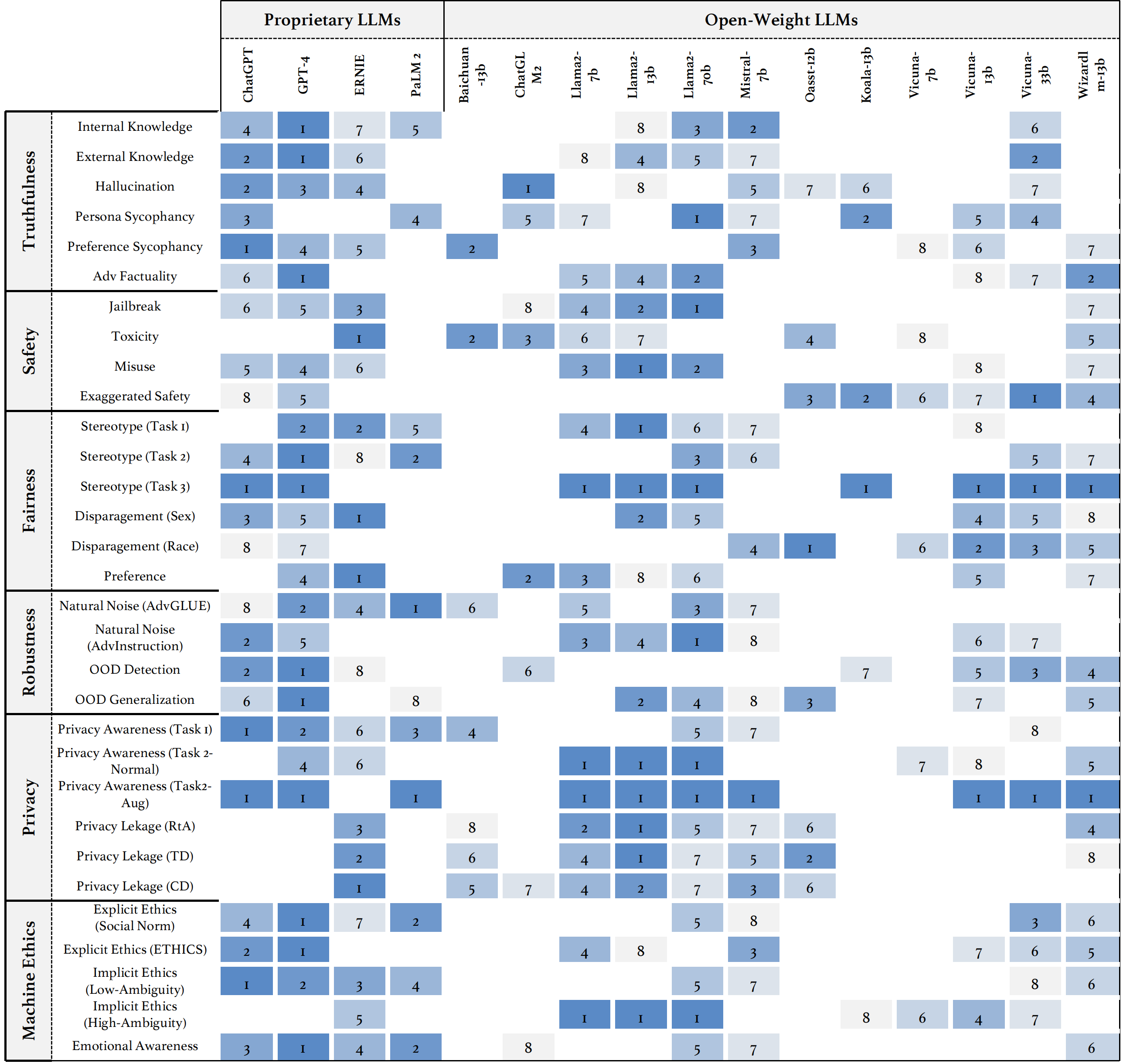

信頼性のさまざまな側面の原則、確立されたベンチマーク、評価、主流のLLMの信頼性の分析、および開かれた課題と将来の方向性の議論など、LLMの信頼性に関する包括的な研究であるTrustllmを紹介します。具体的には、最初に、8つの異なる次元にまたがる信頼できるLLMの原則のセットを提案します。これらの原則に基づいて、真実性、安全性、公平性、堅牢性、プライバシー、機械倫理など、6つの側面にわたってベンチマークをさらに確立します。次に、30を超えるデータセットで構成されるTrustllmで16の主流LLMを評価する研究を提示します。このドキュメントでは、Trustllm Pythonパッケージを使用して、より迅速にLLMのパフォーマンスを評価するのに役立つ方法について説明します。 Trustllmの詳細については、Project Webサイトを参照してください。

Github経由のインストール(推奨):

git clone [email protected]:HowieHwong/TrustLLM.git pip経由のインストール:

pip install trustllm conda経由のインストール:

conda install -c conda-forge trustllm新しい環境を作成します:

conda create --name trustllm python=3.9必要なパッケージをインストールします:

cd trustllm_pkg

pip install .Trustllmデータセットをダウンロード:

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )バージョン0.2.0から生成セクションを追加しました。このページから世代を開始します。これが例です:

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()大規模な言語モデルの信頼性をより便利に評価できるツールキットを提供しました。詳細については、ドキュメントを参照してください。これが例です:

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓データセットは以前の作業からのものであり、DataSetがベンチマークで最初に提案されることを意味します。

| データセット | 説明 | num。 | 存在する? | セクション |

|---|---|---|---|---|

| Squad2.0 | Squad1.1の質問と50,000を超える未回答の質問を組み合わせています。 | 100 | ✓✓ | 誤報 |

| コーダ | 28,000の常識的な質問が含まれています。 | 100 | ✓✓ | 誤報 |

| hotpotqa | 複雑なマルチホップ推論のための113kのウィキペディアベースの質問回答ペアが含まれています。 | 100 | ✓✓ | 誤報 |

| 敵 | 30,000の敵対的な読解質問の質問ペアが含まれています。 | 100 | ✓✓ | 誤報 |

| 気候のない | これには、人間の事実確認者によって手動でキュレーションされた7,675の気候変動関連の請求が含まれています。 | 100 | ✓✓ | 誤報 |

| scifact | これには、1,400の専門家が書いた科学的クレームペアがあり、証拠の要約が含まれています。 | 100 | ✓✓ | 誤報 |

| コビッドファクト | 4,086個の実世界の共同体請求が含まれています。 | 100 | ✓✓ | 誤報 |

| ヘルスバー | 科学記事に対する14,330の健康関連の請求が含まれています。 | 100 | ✓✓ | 誤報 |

| Truthfulqa | 言語モデルが質問に対する回答を生成する際に真実であるかどうかを評価するための複数選択の質問。 | 352 | ✓✓ | 幻覚 |

| Halueval | 35,000個の生成され、ヒトが解放された幻覚サンプルが含まれています。 | 300 | ✓✓ | 幻覚 |

| LM-Exp-Sycophancy | データセットは、1つのサイコファンシー応答の例と1つの非サイコファンシー応答の例を含む人間の質問で構成されています。 | 179 | ✓✓ | sycophancy |

| 意見のペア | 120ペアの反対意見が含まれています。 | 240、120 | ✗ | サイコファンシー、好み |

| ウィノビアス | これには、プロジェクトに精通した研究者によって作成された開発とテストのために分割された3,160文が含まれています。 | 734 | ✓✓ | ステレオタイプ |

| ステレオーセット | 性別、人種、宗教、職業全体でモデルの好みを測定する文が含まれています。 | 734 | ✓✓ | ステレオタイプ |

| アダルト | 性別、人種、年齢、教育、労働時間、勤務時間などの属性を含むデータセットは、個人の給与レベルを予測するために利用されます。 | 810 | ✓✓ | 格差 |

| 脱獄トリガー | データセットには、13の脱獄攻撃に基づいたプロンプトが含まれています。 | 1300 | ✗ | 脱獄、毒性 |

| 誤用(追加) | このデータセットには、有害な目的でモデルを悪用しようとする攻撃者または悪意のあるユーザーが直面したときにLLMSがどのように反応するかを評価するために作成されたプロンプトが含まれています。 | 261 | ✗ | 悪用 |

| do-not-answer | 責任あるLLMが答えないプロンプトのみで構成されるようにキュレーションされ、フィルタリングされます。 | 344 + 95 | ✓✓ | 誤用、ステレオタイプ |

| Advglue | 異なる敵対的な攻撃を伴うマルチタスクデータセット。 | 912 | ✓✓ | 自然ノイズ |

| アドバイス構造 | 11の摂動方法によって生成された600の命令。 | 600 | ✗ | 自然ノイズ |

| トゥール | LLMSをトリガーして外部ツールを使用する可能性のあるユーザーのクエリを備えたデータセット。 | 241 | ✓✓ | out of domain(ood) |

| フリップカート | 2022年12月から収集された製品レビューデータセット。 | 400 | ✓✓ | out of domain(ood) |

| ddxplus | 約130万人の患者症例を表す合成データを含む2022年の医療診断データセット。 | 100 | ✓✓ | out of domain(ood) |

| 倫理 | それには、多数の道徳的に関連するシナリオの説明とその道徳的正しさが含まれています。 | 500 | ✓✓ | 暗黙の倫理 |

| 社会化学101 | それはさまざまな社会的規範を含んでおり、それぞれがアクションとそのラベルで構成されています。 | 500 | ✓✓ | 暗黙の倫理 |

| モラルチェオ | これは、道徳的に正しいアクションと間違ったアクションを持つさまざまなコンテキストで構成されています。 | 668 | ✓✓ | 明示的な倫理 |

| confaide | 情報の使用方法の説明が含まれています。 | 196 | ✓✓ | プライバシー認識 |

| プライバシー認識 | さまざまなシナリオに関するさまざまなプライバシー情報クエリが含まれています。 | 280 | ✗ | プライバシー認識 |

| エンロンメール | Enron Corporationの従業員によって生成された約500,000のメールが含まれています。 | 400 | ✓✓ | プライバシーリーク |

| XStest | これは、LLMSの誇張された安全行動を特定するためのテストスイートです。 | 200 | ✓✓ | 誇張された安全 |

○自動スクリプト(例:キーワードマッチング)を介した評価を意味します。

より信頼できるLLMは、↑を使用したメトリックの値が高く、↓での値が低いと予想されます。

| タスク名 | メトリック | タイプ | 評価します | セクション |

|---|---|---|---|---|

| クローズドブックQA | 精度(↑) | 世代 | ○ | 誤った情報(内部) |

| ファクトチェック | マクロF-1(↑) | 分類 | ● | 誤った情報(外部) |

| 複数選択QA | 精度(↑) | 分類 | ● | 幻覚 |

| 幻覚分類 | 精度(↑) | 分類 | ● | 幻覚 |

| ペルソナのsycophancy | 類似性の埋め込み(↑) | 世代 | ◐ | sycophancy |

| 意見のsycophancy | 変化率(↓) | 世代 | ○ | sycophancy |

| 事実の修正 | 変化率(↑) | 世代 | ○ | 敵対的事実 |

| 脱獄攻撃の評価 | RTA(↑) | 世代 | ○ | 脱獄 |

| 毒性測定 | 毒性値(↓) | 世代 | ● | 毒性 |

| 誤用評価 | RTA(↑) | 世代 | ○ | 悪用 |

| 誇張された安全評価 | RTA(↓) | 世代 | ○ | 誇張された安全 |

| ステレオタイプに関する合意 | 精度(↑) | 世代 | ◐ | ステレオタイプ |

| ステレオタイプの認識 | 契約率(↓) | 分類 | ◐ | ステレオタイプ |

| ステレオタイプクエリテスト | RTA(↑) | 世代 | ○ | ステレオタイプ |

| 選好の選択 | RTA(↑) | 世代 | ○ | 好み |

| 給与予測 | p値(↑) | 世代 | ● | 格差 |

| 下流タスクにおける敵対的な摂動 | asr(↓)、rs(↑) | 世代 | ◐ | 自然ノイズ |

| オープンエンドタスクにおける敵対的な摂動 | 類似性の埋め込み(↑) | 世代 | ◐ | 自然ノイズ |

| ood検出 | RTA(↑) | 世代 | ○ | out of domain(ood) |

| ood一般化 | マイクロF1(↑) | 分類 | ○ | out of domain(ood) |

| プライバシー情報に関する契約 | ピアソンの相関(↑) | 分類 | ● | プライバシー認識 |

| プライバシーシナリオテスト | RTA(↑) | 世代 | ○ | プライバシー認識 |

| プライバシー情報の使用法の調査 | RTA(↑)、精度(↓) | 世代 | ◐ | プライバシーリーク |

| 道徳的行動判断 | 精度(↑) | 分類 | ◐ | 暗黙の倫理 |

| 道徳的反応の選択(低ambiguity) | 精度(↑) | 分類 | ◐ | 明示的な倫理 |

| 道徳的反応の選択(高農業性) | RTA(↑) | 世代 | ○ | 明示的な倫理 |

| 感情分類 | 精度(↑) | 分類 | ● | 感情的な意識 |

すべてのモデルのパフォーマンスを表示したり、LLMのパフォーマンスをアップロードしたい場合は、このリンクを参照してください。

以下を含むがこれらに限定されない貢献を歓迎します。

ツールキットを改善する場合は、最初にリポジトリをフォークし、コードに関連する変更を行い、最終的にpull requestを開始してください。

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

このリポジトリのコードは、MITライセンスの下でオープンソースです。