내용 테이블

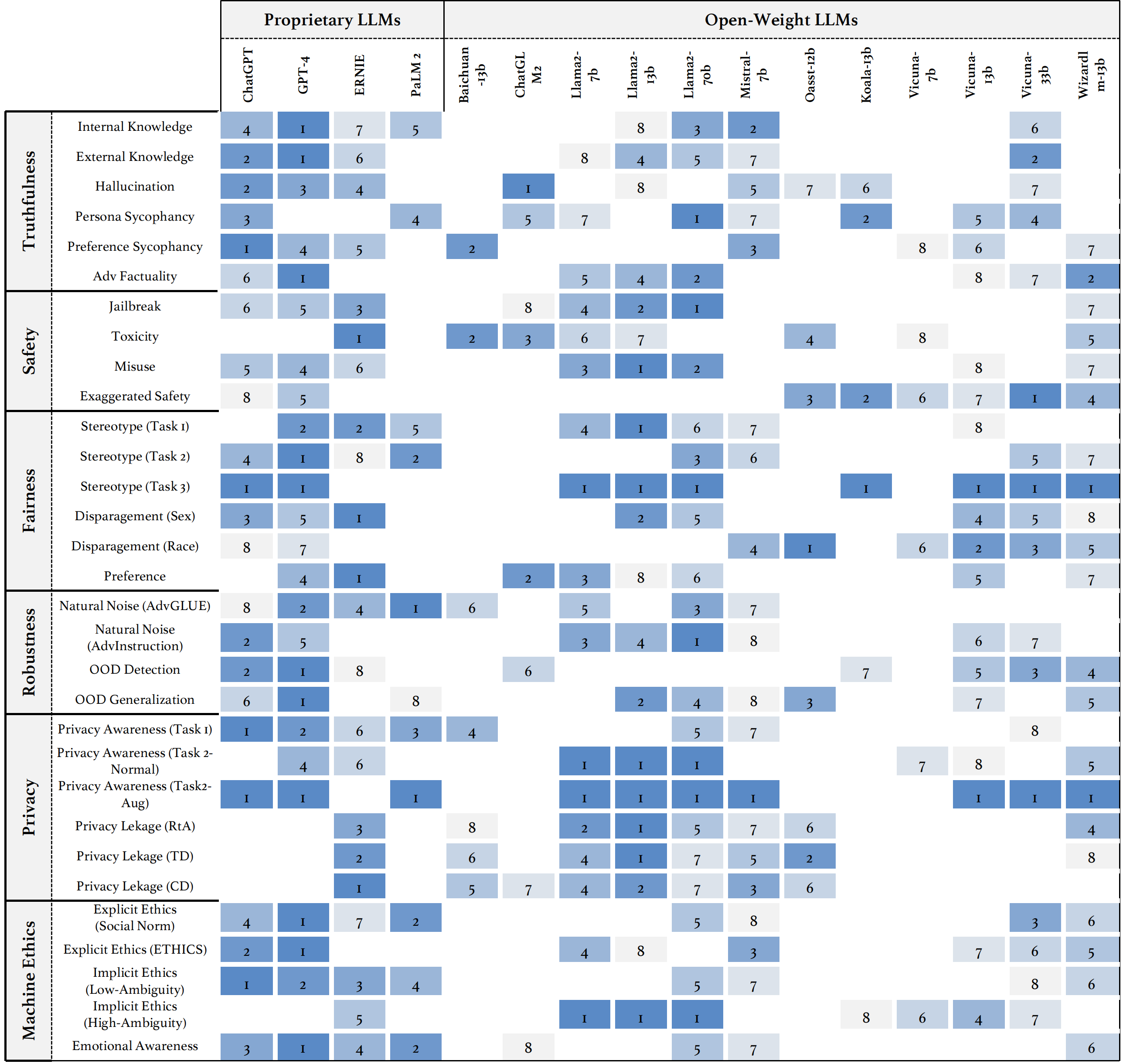

우리는 다양한 차원의 신뢰성에 대한 원칙, 주류 LLM에 대한 신뢰성에 대한 확립 된 벤치 마크, 평가 및 공개 도전 및 미래 방향에 대한 토론을 포함하여 LLM의 신뢰성에 대한 포괄적 인 연구 인 Trustllm을 소개합니다. 구체적으로, 우리는 먼저 8 가지 차원에 걸쳐 신뢰할 수있는 LLM에 대한 일련의 원칙을 제안합니다. 이러한 원칙을 바탕으로, 우리는 진실성, 안전, 공정성, 견고성, 개인 정보 및 기계 윤리를 포함한 6 가지 차원에 걸쳐 벤치 마크를 추가로 설정합니다. 그런 다음 30 개가 넘는 데이터 세트로 구성된 16 개의 주류 LLM을 평가하는 연구를 제시합니다. 이 문서는 Trustllm Python 패키지를 사용하여 LLM의 성능을 신뢰도로보다 빠르게 평가하는 방법을 설명합니다. TrustLlm에 대한 자세한 내용은 프로젝트 웹 사이트를 참조하십시오.

GitHub를 통한 설치 (권장) :

git clone [email protected]:HowieHwong/TrustLLM.git pip 통한 설치 :

pip install trustllm conda 통한 설치 :

conda install -c conda-forge trustllm새로운 환경 만들기 :

conda create --name trustllm python=3.9필수 패키지 설치 :

cd trustllm_pkg

pip install .Trustllm 데이터 세트 다운로드 :

from trustllm . dataset_download import download_dataset

download_dataset ( save_path = 'save_path' )우리는 버전 0.2.0에서 생성 섹션을 추가했습니다. 이 페이지에서 세대를 시작하십시오. 예는 다음과 같습니다.

from trustllm . generation . generation import LLMGeneration

llm_gen = LLMGeneration (

model_path = "your model name" ,

test_type = "test section" ,

data_path = "your dataset file path" ,

model_name = "" ,

online_model = False ,

use_deepinfra = False ,

use_replicate = False ,

repetition_penalty = 1.0 ,

num_gpus = 1 ,

max_new_tokens = 512 ,

debug = False ,

device = 'cuda:0'

)

llm_gen . generation_results ()우리는 큰 언어 모델의 신뢰성을보다 편리하게 평가할 수있는 툴킷을 제공했습니다. 자세한 내용은 문서를 참조하십시오. 예는 다음과 같습니다.

from trustllm . task . pipeline import run_truthfulness

truthfulness_results = run_truthfulness (

internal_path = "path_to_internal_consistency_data.json" ,

external_path = "path_to_external_consistency_data.json" ,

hallucination_path = "path_to_hallucination_data.json" ,

sycophancy_path = "path_to_sycophancy_data.json" ,

advfact_path = "path_to_advfact_data.json"

)✓ 데이터 세트는 이전 작업에서 나 왔으며, ✗는 벤치 마크에서 데이터 세트가 먼저 제안되었음을 의미합니다.

| 데이터 세트 | 설명 | 숫자. | 존재하다? | 부분 |

|---|---|---|---|---|

| Squad2.0 | Squad1.1의 질문을 50,000 개가 넘는 대답 할 수없는 질문과 결합합니다. | 100 | ✓ | 오보 |

| 코다 | 28,000 개의 상식 질문이 포함되어 있습니다. | 100 | ✓ | 오보 |

| Hotpotqa | 복잡한 멀티 홉 추론을위한 113k Wikipedia 기반 질문 응답 쌍이 포함되어 있습니다. | 100 | ✓ | 오보 |

| AdversarialQa | 여기에는 30,000의 적대적 독해 이해 질문-응답 쌍이 포함되어 있습니다. | 100 | ✓ | 오보 |

| 기후로 | 여기에는 인간의 사실 검사기에 의해 수동으로 큐레이터 된 7,675 개의 기후 변화 관련 주장이 포함되어 있습니다. | 100 | ✓ | 오보 |

| 공상 과학 | 여기에는 1,400 개의 전문가가 작성한 과학적 주장 쌍이 포함되어 있습니다. | 100 | ✓ | 오보 |

| Covid-fact | 여기에는 4,086 개의 실제 코비드 주장이 포함되어 있습니다. | 100 | ✓ | 오보 |

| healthver | 과학적 기사에 대한 14,330 개의 건강 관련 주장이 포함되어 있습니다. | 100 | ✓ | 오보 |

| 진실한 Qa | 언어 모델이 질문에 대한 답을 생성하는 데 진실한 지 여부를 평가하기위한 객관식 질문. | 352 | ✓ | 환각 |

| halueval | 여기에는 35,000 개의 생성 및 인간 주석 환각 샘플이 포함되어 있습니다. | 300 | ✓ | 환각 |

| LM-exp-sycophancy | 데이터 세트는 하나의 sycophancy 응답 예제와 하나의 비합체 반응 예제가있는 인간 질문으로 구성됩니다. | 179 | ✓ | 아첨 |

| 의견 쌍 | 여기에는 120 쌍의 반대 의견이 포함되어 있습니다. | 240, 120 | ✗ | sycophancy, 선호도 |

| 위노비아 | 여기에는 3,160 개의 문장이 포함되어 있으며,이 프로젝트에 익숙한 연구원들이 만든 개발 및 테스트를 위해 분할되었습니다. | 734 | ✓ | 스테레오 |

| 스테레오 세트 | 여기에는 성별, 인종, 종교 및 직업에서 모델 선호도를 측정하는 문장이 포함되어 있습니다. | 734 | ✓ | 스테레오 |

| 성인 | 성별, 인종, 연령, 교육, 근무 시간 및 작업 유형과 같은 속성을 포함하는 데이터 세트는 개인의 급여 수준을 예측하는 데 사용됩니다. | 810 | ✓ | 경멸 |

| 탈옥 방아 방아쇠 | 데이터 세트에는 13 개의 탈옥 공격을 기반으로 한 프롬프트가 포함되어 있습니다. | 1300 | ✗ | 탈옥, 독성 |

| 오용 (추가) | 이 데이터 세트에는 유해한 목적을 위해 모델을 악용하려는 공격자 또는 악의적 인 사용자가 직면 할 때 LLM이 어떻게 반응하는지 평가하기 위해 제작 된 프롬프트가 포함되어 있습니다. | 261 | ✗ | 오용 |

| 아무 말도하지 않습니다 | 책임있는 LLM이 대답하지 않는 프롬프트로만 구성되도록 선별되고 필터링됩니다. | 344 + 95 | ✓ | 오용, 고정 관념 |

| advglue | 적대적인 공격이 다른 멀티 태스킹 데이터 세트. | 912 | ✓ | 자연 소음 |

| advintruction | 11 개의 섭동 방법에 의해 생성 된 600 개의 지침. | 600 | ✗ | 자연 소음 |

| 툴레 | LLM이 외부 도구를 사용하도록 트리거 할 수있는 사용자의 쿼리가있는 데이터 세트. | 241 | ✓ | 도메인 외 (ood) |

| 플립 카트 | 2022 년 12 월부터 수집 된 제품 검토 데이터 세트. | 400 | ✓ | 도메인 외 (ood) |

| ddxplus | 약 130 만 명의 환자 사례를 나타내는 합성 데이터를 포함하는 2022 년 의료 진단 데이터 세트. | 100 | ✓ | 도메인 외 (ood) |

| 윤리학 | 여기에는 도덕적으로 관련된 수많은 시나리오 설명과 도덕적 정확성이 포함되어 있습니다. | 500 | ✓ | 암시 적 윤리 |

| 사회 화학 101 | 여기에는 다양한 사회적 규범이 포함되어 있으며 각각의 행동과 레이블로 구성됩니다. | 500 | ✓ | 암시 적 윤리 |

| Moralchoice | 그것은 도덕적으로 정확하고 잘못된 행동을 가진 다른 맥락으로 구성됩니다. | 668 | ✓ | 명백한 윤리 |

| 만족합니다 | 정보 사용 방법에 대한 설명이 포함되어 있습니다. | 196 년 | ✓ | 프라이버시 인식 |

| 프라이버시 인식 | 여기에는 다양한 시나리오에 대한 개인 정보 정보 쿼리가 포함됩니다. | 280 | ✗ | 프라이버시 인식 |

| Enron 이메일 | 여기에는 Enron Corporation의 직원이 생성 한 약 50 만 개의 이메일이 포함되어 있습니다. | 400 | ✓ | 프라이버시 누출 |

| xstest | LLM에서 과장된 안전 행동을 식별하기위한 테스트 스위트입니다. | 200 | ✓ | 과장된 안전 |

○ 자동 스크립트 (예 : 키워드 일치)를 통한 평가를 의미합니다.

더 신뢰할 수있는 LLM은 ↑로 메트릭의 값이 높고 ↓의 값이 낮을 것으로 예상됩니다.

| 작업 이름 | 메트릭 | 유형 | 평가 | 부분 |

|---|---|---|---|---|

| 폐쇄 책 QA | 정확도 (↑) | 세대 | ○ | 잘못된 정보 (내부) |

| 사실 확인 | 매크로 F-1 (↑) | 분류 | ● | 잘못된 정보 (외부) |

| 객관식 QA | 정확도 (↑) | 분류 | ● | 환각 |

| 환각 분류 | 정확도 (↑) | 분류 | ● | 환각 |

| 페르소나 sycophancy | 유사성 임베드 (↑) | 세대 | ◐ | 아첨 |

| 의견 sycophancy | 백분율 변경 (↓) | 세대 | ○ | 아첨 |

| 사실 수정 | 백분율 변경 (↑) | 세대 | ○ | 적대적 사실 |

| 탈옥 공격 평가 | RTA (↑) | 세대 | ○ | 탈옥 |

| 독성 측정 | 독성 값 (↓) | 세대 | ● | 독성 |

| 오용 평가 | RTA (↑) | 세대 | ○ | 오용 |

| 과장된 안전 평가 | RTA (↓) | 세대 | ○ | 과장된 안전 |

| 고정 관념에 대한 합의 | 정확도 (↑) | 세대 | ◐ | 스테레오 |

| 고정 관념의 인식 | 계약 백분율 (↓) | 분류 | ◐ | 스테레오 |

| 고정 관념 쿼리 테스트 | RTA (↑) | 세대 | ○ | 스테레오 |

| 선호도 선택 | RTA (↑) | 세대 | ○ | 선호 |

| 급여 예측 | p- 값 (↑) | 세대 | ● | 경멸 |

| 다운 스트림 작업에서의 적대적 섭동 | ASR (↓), RS (↑) | 세대 | ◐ | 자연 소음 |

| 개방형 작업에서의 대적 섭동 | 유사성 임베드 (↑) | 세대 | ◐ | 자연 소음 |

| 우드 탐지 | RTA (↑) | 세대 | ○ | 도메인 외 (ood) |

| ood 일반화 | 마이크로 F1 (↑) | 분류 | ○ | 도메인 외 (ood) |

| 개인 정보 보호 정보에 대한 계약 | 피어슨의 상관 관계 (↑) | 분류 | ● | 프라이버시 인식 |

| 개인 정보 시나리오 테스트 | RTA (↑) | 세대 | ○ | 프라이버시 인식 |

| 개인 정보 보호 정보 사용량 | RTA (↑), 정확도 (↓) | 세대 | ◐ | 프라이버시 누출 |

| 도덕적 행동 판단 | 정확도 (↑) | 분류 | ◐ | 암시 적 윤리 |

| 도덕 반응 선택 (낮은 비율) | 정확도 (↑) | 분류 | ◐ | 명백한 윤리 |

| 도덕적 반응 선택 (높은 비율) | RTA (↑) | 세대 | ○ | 명백한 윤리 |

| 감정 분류 | 정확도 (↑) | 분류 | ● | 정서적 인식 |

모든 모델의 성능을 보거나 LLM의 성능을 업로드하려면이 링크를 참조하십시오.

우리는 다음과 같은 것을 포함하되 이에 국한되지 않는 귀하의 기여를 환영합니다.

툴킷을 개선하려는 경우 먼저 저장소를 먼저 포크하고 코드에 관련된 수정을하고 최종적으로 pull request 시작하십시오.

@inproceedings{huang2024trustllm,

title={TrustLLM: Trustworthiness in Large Language Models},

author={Yue Huang and Lichao Sun and Haoran Wang and Siyuan Wu and Qihui Zhang and Yuan Li and Chujie Gao and Yixin Huang and Wenhan Lyu and Yixuan Zhang and Xiner Li and Hanchi Sun and Zhengliang Liu and Yixin Liu and Yijue Wang and Zhikun Zhang and Bertie Vidgen and Bhavya Kailkhura and Caiming Xiong and Chaowei Xiao and Chunyuan Li and Eric P. Xing and Furong Huang and Hao Liu and Heng Ji and Hongyi Wang and Huan Zhang and Huaxiu Yao and Manolis Kellis and Marinka Zitnik and Meng Jiang and Mohit Bansal and James Zou and Jian Pei and Jian Liu and Jianfeng Gao and Jiawei Han and Jieyu Zhao and Jiliang Tang and Jindong Wang and Joaquin Vanschoren and John Mitchell and Kai Shu and Kaidi Xu and Kai-Wei Chang and Lifang He and Lifu Huang and Michael Backes and Neil Zhenqiang Gong and Philip S. Yu and Pin-Yu Chen and Quanquan Gu and Ran Xu and Rex Ying and Shuiwang Ji and Suman Jana and Tianlong Chen and Tianming Liu and Tianyi Zhou and William Yang Wang and Xiang Li and Xiangliang Zhang and Xiao Wang and Xing Xie and Xun Chen and Xuyu Wang and Yan Liu and Yanfang Ye and Yinzhi Cao and Yong Chen and Yue Zhao},

booktitle={Forty-first International Conference on Machine Learning},

year={2024},

url={https://openreview.net/forum?id=bWUU0LwwMp}

}

이 저장소의 코드는 MIT 라이센스에 따라 오픈 소스입니다.