上海AI实验室近日发布了一款名为InternLM-XComposer-2.5(简称IXC-2.5)的多模态大型语言模型,这一开源项目在人工智能领域引起了广泛关注。该模型不仅在技术上实现了多项突破,还在实际应用中展现了强大的潜力,特别是在超高分辨率图像理解、细粒度视频理解和多轮图像对话等方面,其表现尤为突出。

IXC-2.5的发布填补了国内在多模态LLM领域的空白,尤其是在网页制作和图文混排文章生成方面,该模型进行了特别的优化,为内容创作者提供了极大的便利。无论是网页设计还是图文内容的生成,IXC-2.5都能提供高效且精准的解决方案,极大地提升了创作效率。

IXC-2.5模型的核心特点包括:

长上下文处理能力:该模型原生支持24K标记的输入,并可扩展到96K,这意味着它能够处理超长的文本和图像输入,为用户提供了更大的创作空间。无论是复杂的文档还是大量的图像数据,IXC-2.5都能轻松应对。

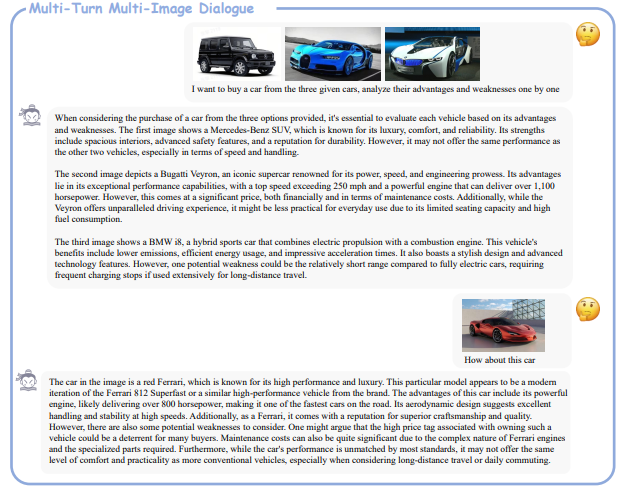

多样化的视觉能力:IXC-2.5不仅支持超高分辨率的图像理解,还能进行细粒度的视频理解和多轮多图对话。这种多模态的处理能力在以往的模型中极为罕见,尤其是在视频理解方面,IXC-2.5能够将视频中的帧沿短边拼接,形成高分辨率图像,同时保留帧的索引以提供时间关系。

强大的生成能力:IXC-2.5能够生成网页和高质量的图文文章,将文本和图像的结合提升到了一个新的高度。无论是网页设计还是图文混排的文章生成,IXC-2.5都能提供高质量的输出,满足不同场景的需求。

先进的模型架构:IXC-2.5采用了轻量级的视觉编码器、大型语言模型以及部分LoRA对齐技术,这些技术的结合使得模型在性能上有了显著的提升。尤其是在处理复杂的多模态数据时,IXC-2.5展现出了卓越的效率。

在28个基准测试中,IXC-2.5在16项测试中超过了现有的开源模型,另外16项测试中的表现接近或超过了GPT-4V和Gemini Pro。这一测试结果充分证明了IXC-2.5的强大实力,尤其是在视频理解、结构化高分辨率图像理解、多轮多图对话和通用视觉问答等任务上,IXC-2.5展现出了极强的竞争力。

IXC-2.5的研发团队由上海人工智能实验室、香港中文大学、商汤科技集团以及清华大学联合组成。该模型的设计初衷是为了支持长上下文的输入与输出,以应对日益复杂的文本图像理解和创作任务。在预训练阶段,IXC-2.5通过位置编码外推,将上下文窗口扩展到96K,这在人机交互和内容创作方面展现出了卓越的能力。

在图像处理方面,IXC-2.5采用了统一的动态图像分割策略,能够适应任意分辨率和纵横比的图像。而在视频处理方面,它能够将视频中的帧沿短边拼接,形成高分辨率图像,同时保留帧的索引以提供时间关系。这种处理方式使得IXC-2.5在视频理解任务中表现出色。

此外,IXC-2.5还扩展了其在网页生成方面的应用,能够根据视觉截图、自由形式指令或简历文档自动构建网页。在文本图像文章创作方面,IXC-2.5通过结合多种技术,提出了一种可扩展的流程,以生成高质量和稳定的文本图像文章。

IXC-2.5的开源不仅是技术上的一次飞跃,更是对整个人工智能领域的一大贡献。它让我们看到了多模态LLM的无限可能,也为未来的AI应用开辟了新的道路。无论是内容创作、网页设计还是多模态数据处理,IXC-2.5都将成为未来人工智能应用中的重要工具。

项目地址:https://top.aibase.com/tool/internlm-xcomposer-2-5

论文地址:https://arxiv.org/pdf/2407.03320