Sakana AI เริ่มต้นได้เปิดตัวเทคโนโลยีนวัตกรรมที่เรียกว่า "AI CUDA Engineer" ซึ่งเป็นระบบที่ออกแบบมาเพื่อสร้างแกน CUDA ที่ได้รับการปรับปรุงสูงผ่านกระบวนการอัตโนมัติซึ่งเป็นการปรับปรุงประสิทธิภาพการทำงานของการเรียนรู้ของเครื่อง ระบบได้เพิ่มความเร็วในการดำเนินงานของ Pytorch ทั่วไป 10 ถึง 100 เท่าผ่านการวิวัฒนาการของแบบจำลองภาษาขนาดใหญ่ (LLM)-เทคโนโลยีการเพิ่มประสิทธิภาพรหัสที่ได้รับการขับเคลื่อนโดยทำเครื่องหมายการพัฒนาที่สำคัญสำหรับ AI ในด้านการเพิ่มประสิทธิภาพประสิทธิภาพ GPU

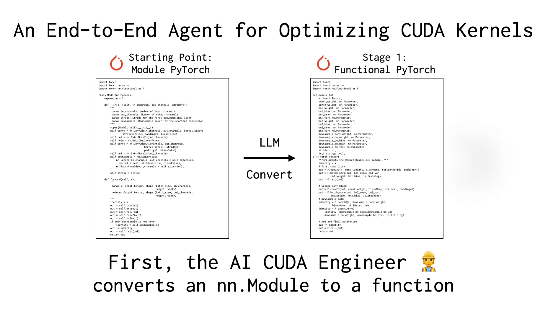

CUDA Cores เป็นแกนหลักของการคำนวณ GPU และการเขียนและการเพิ่มประสิทธิภาพของพวกเขามักจะต้องมีพื้นหลังทางเทคนิคที่ลึกและมีความเชี่ยวชาญระดับสูง แม้ว่าเฟรมเวิร์กที่มีอยู่เช่น Pytorch จะให้การใช้งานที่สะดวก แต่พวกเขามักจะล้มเหลวในการจับคู่เมล็ดที่เหมาะสมด้วยตนเองในประสิทธิภาพ "Ai Cuda Engineer" ของ Sakana AI แก้ไขปัญหานี้ผ่านเวิร์กโฟลว์อัจฉริยะ ไม่เพียง แต่แปลงรหัส pytorch โดยอัตโนมัติให้เป็น CUDA Core ที่มีประสิทธิภาพ แต่ยังดำเนินการปรับแต่งประสิทธิภาพผ่านอัลกอริทึมวิวัฒนาการและแม้กระทั่งรวมหลายแกนเพื่อปรับปรุงประสิทธิภาพของรันไทม์ต่อไป

ผู้ใช้ @shao__meng บนแพลตฟอร์ม X เปรียบเทียบเทคโนโลยีนี้กับ "การติดตั้งกล่องเกียร์อัตโนมัติสำหรับการพัฒนา AI" ทำให้รหัสธรรมดาสามารถ "อัพเกรดเป็นประสิทธิภาพในระดับการแข่งโดยอัตโนมัติ" ผู้ใช้อีกคน @FinanceYF5 ยังชี้ให้เห็นในโพสต์ว่าการเปิดตัวระบบแสดงให้เห็นถึงศักยภาพของการเพิ่มประสิทธิภาพด้วยตนเองของ AI และอาจนำการปรับปรุงการปฏิวัติมาสู่ประสิทธิภาพของการใช้ทรัพยากรคอมพิวเตอร์ในอนาคต

Sakana AI ก่อนหน้านี้ได้ทำเครื่องหมายในอุตสาหกรรมเนื่องจากโครงการเช่น "นักวิทยาศาสตร์ AI" การเปิดตัว "AI CUDA Engineer" เน้นย้ำความทะเยอทะยานในสาขา AI Automation บริษัท อ้างว่าระบบสร้างความสำเร็จและตรวจสอบคอร์ CUDA มากกว่า 17,000 คอร์ซึ่งครอบคลุมการดำเนินงาน pytorch หลายครั้งและชุดข้อมูลที่เปิดเผยจะให้ทรัพยากรที่มีค่าสำหรับนักวิจัยและนักพัฒนา คนวงในอุตสาหกรรมเชื่อว่าเทคโนโลยีนี้ไม่เพียง แต่ลดเกณฑ์สำหรับการเขียนโปรแกรม GPU ที่มีประสิทธิภาพสูง แต่ยังอาจผลักดันการฝึกอบรมและประสิทธิภาพการใช้งานของโมเดลปัญญาประดิษฐ์ในระดับใหม่

ข้อมูลอ้างอิง: https://x.com/financef5/status/1892856847780237318