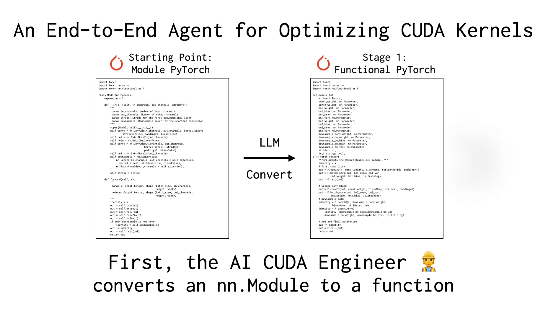

أصدرت شركة Sakana AI المبتدئة في الذكاء الاصطناعي الياباني تقنية مبتكرة تسمى "AI Cuda Engineer" ، وهو نظام مصمم لإنشاء نوى CUDA محسنة للغاية من خلال العمليات الآلية ، وبالتالي تحسين الكفاءة التشغيلية لعمليات التعلم الآلي. زاد النظام من سرعة تشغيل Pytorch المشتركة بمقدار 10 إلى 100 مرة من خلال تطور تقنية تحسين الكود النموذجية (LLM) ، مما يمثل اختراقًا كبيرًا لمنظمة العفو الدولية في مجال تحسين أداء GPU.

CUDA CORES هي جوهر حوسبة GPU ، وعادة ما تتطلب الكتابة والتحسين خلفية تقنية عميقة ومستوى عال من الخبرة. على الرغم من أن الأطر الحالية مثل Pytorch توفر استخدامًا مناسبًا ، إلا أنها غالبًا ما تفشل في مطابقة النواة المحسنة يدويًا في الأداء. حلت "AI Cuda Engineer" من Sakana AI هذه المشكلة من خلال سير عمل ذكي.

قارن AsserShao__meng usa __meng على منصة X هذه التكنولوجيا بـ "تثبيت علبة تروس تلقائية لتطوير الذكاء الاصطناعي" ، مما يتيح رمزًا عاديًا "للترقية تلقائيًا إلى أداء مستوى السباق". كما أشار مستخدم آخر @financeyf5 في المنشور إلى أن إطلاق النظام يوضح إمكانات التحسين الذاتي لمنظمة العفو الدولية وقد يجلب تحسنا ثوريًا لكفاءة استخدام موارد الحوسبة المستقبلية.

سبق أن صنعت Sakana AI بصماتها في الصناعة بسبب مشاريع مثل "عالم الذكاء الاصطناعي". تدعي الشركة أن النظام قد أنشأ ونجاح أكثر من 17000 نوى CUDA ، والتي تغطي عمليات Pytorch متعددة ، وستوفر مجموعة البيانات المكشوفة موارد قيمة للباحثين والمطورين. يعتقد المطلعون على الصناعة أن هذه التكنولوجيا لا تخفض فقط عتبة برمجة GPU عالية الأداء ، ولكنها قد تدفع أيضًا كفاءة التدريب والنشر لنماذج الذكاء الاصطناعي إلى مستوى جديد.

مرجع المعلومات: https://x.com/financeyf5/status/1892856847780237318