日本の人工知能スタートアップSakana AIは最近、自動化されたプロセスを通じて高度に最適化されたCUDAコアを生成するように設計された「AI CUDAエンジニア」と呼ばれる革新的なテクノロジーをリリースし、それにより機械学習運用の運用効率を大幅に改善します。このシステムは、大規模な言語モデル(LLM)駆動型コード最適化テクノロジーの進化を通じて、一般的なPytorchの動作速度を10〜100倍増加させ、GPUパフォーマンス最適化の分野でAIの大きなブレークスルーをマークしています。

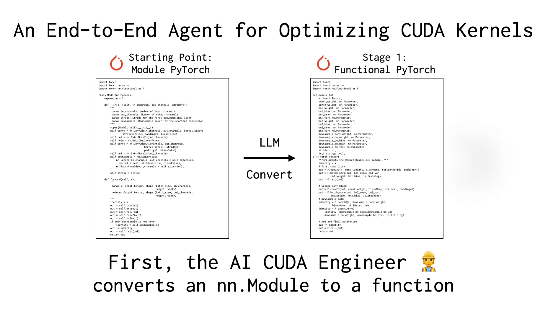

CUDAコアはGPUコンピューティングの中核であり、その執筆と最適化には通常、深い技術的背景と高いレベルの専門知識が必要です。 Pytorchなどの既存のフレームワークは便利な使用法を提供しますが、パフォーマンスで手動で最適化されたカーネルと一致しないことがよくあります。 Sakana Aiの「AI CUDAエンジニア」は、インテリジェントなワークフローを通じてこの問題を解決しました。Pytorchコードを自動的にCUDAコアに変換するだけでなく、進化的アルゴリズムを通じてパフォーマンス調整を実行し、ランタイム効率をさらに改善することさえします。

Xプラットフォーム上のユーザー@Shao__Mengこのテクノロジーを「AI開発用の自動ギアボックスのインストール」と比較し、通常のコードが「レーシングレベルのパフォーマンスに自動的にアップグレードする」ことができます。別のユーザー @Financef5は、システムの発売がAIの自己最適化の可能性を示しており、将来のコンピューティングリソースの使用の効率を革新的な改善をもたらす可能性があることを投稿で指摘しました。

Sakana Aiは、「AI科学者」などのプロジェクトのために、以前は業界でマークを付けています。同社は、システムが複数のPytorch操作をカバーする17,000を超えるCUDAコアを成功裏に生成および検証したと主張しており、露出したデータセットは研究者と開発者に貴重なリソースを提供すると主張しています。業界のインサイダーは、このテクノロジーが高性能GPUプログラミングのしきい値を下げるだけでなく、人工知能モデルのトレーニングと展開効率を新しいレベルに押し上げる可能性もあると考えています。

情報リファレンス:https://x.com/financeyf5/status/189285684780237318