Das japanische Startup Sakana AI für künstliche Intelligenz hat kürzlich eine innovative Technologie namens "AI CUDA Engineer" veröffentlicht, ein System, das durch automatische Prozesse hoch optimierte CUDA -Kerne erzeugt und damit die Betriebseffizienz des maschinellen Lernens erheblich verbessert. Das System hat die gängige Pytorch-Betriebsgeschwindigkeit durch die Entwicklung des Großsprachmodells (LLM) um das 10- bis 100-fache erhöht.

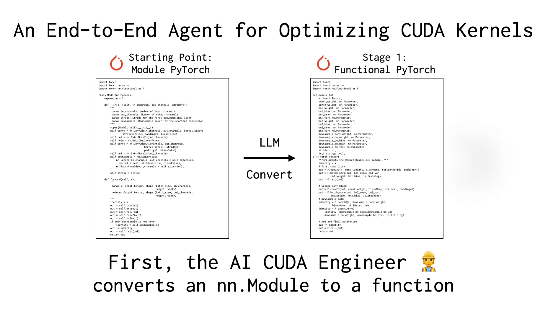

CUDA -Kerne sind der Kern des GPU -Computing, und ihre Schrift und Optimierung erfordern normalerweise einen tiefen technischen Hintergrund und ein hohes Maß an Fachwissen. Obwohl vorhandene Frameworks wie Pytorch bequeme Verwendung bieten, entsprechen sie häufig nicht mit manuell optimierten Leistungskern. Sakana Ais "Ai Cuda Engineer" löste dieses Problem durch einen intelligenten Workflow. Es kann nicht nur den Pytorch -Code automatisch in einen effizienten CUDA -Kern umwandeln, sondern auch die Leistungsabstimmung durch evolutionäre Algorithmen durchführen und sogar mehrere Kerne integrieren, um die Laufzeit -Effizienz weiter zu verbessern.

User @SHAO__Meng auf der X-Plattform verglich diese Technologie mit "Installation eines Automatikgetriebes für die AI-Entwicklung", sodass der ordentliche Code "automatisch auf die Leistung auf Rennebene aktualisiert" wird. Ein anderer Benutzer @Financeyf5 wies auch in der Post darauf hin, dass der Start des Systems das Potenzial der KI-Selbstoptimierung demonstriert und eine revolutionäre Verbesserung der Effizienz zukünftiger Ressourcenanwendung verleihen kann.

Sakana AI hat sich zuvor aufgrund von Projekten wie "AI -Wissenschaftler" in der Branche einen Namen gemacht. Die Veröffentlichung von "Ai Cuda Engineer" unterstreicht die Ambitionen im Bereich der KI -Automatisierung weiter. Das Unternehmen behauptet, dass das System mehr als 17.000 CUDA -Kerne erfolgreich generiert und überprüft hat und mehrere Pytorch -Operationen abdeckt, und der freiliegende Datensatz bietet Forschern und Entwicklern wertvolle Ressourcen. Branchenkenner sind der Ansicht, dass diese Technologie nicht nur den Schwellenwert für die Hochleistungs-GPU-Programmierung senkt, sondern auch die Schulungs- und Bereitstellungseffizienz künstlicher Intelligenzmodelle auf ein neues Niveau treiben kann.

Informationsreferenz: https://x.com/financeyf5/status/1892856847780237318