일본 인공 지능 스타트 업 Sakana AI는 최근 자동화 된 프로세스를 통해 고도로 최적화 된 CUDA 코어를 생성하도록 설계된 시스템 인 "AI CUDA 엔지니어"라는 혁신적인 기술을 발표하여 기계 학습 운영의 운영 효율성을 크게 향상 시켰습니다. 이 시스템은 LLM (Lange Language Model)-유도 코드 최적화 기술을 통해 일반적인 Pytorch 작동 속도를 10 ~ 100 배 증가하여 GPU 성능 최적화 분야에서 AI의 주요 획기적인 혁신을 표시했습니다.

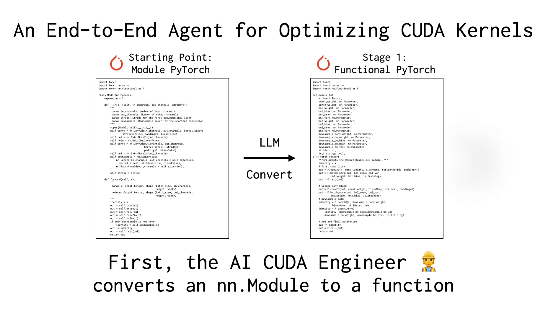

Cuda Cores는 GPU 컴퓨팅의 핵심이며, 작문 및 최적화에는 일반적으로 깊은 기술적 배경과 높은 수준의 전문 지식이 필요합니다. Pytorch와 같은 기존의 프레임 워크는 편리한 사용을 제공하지만 종종 성능에서 수동으로 최적화 된 커널과 일치하지 않습니다. Sakana AI의 "AI Cuda 엔지니어"는 지능형 워크 플로를 통해이 문제를 해결했습니다. 그것은 Pytorch 코드를 효율적인 CUDA 코어로 자동 변환 할뿐만 아니라 진화 알고리즘을 통해 성능 튜닝을 수행하고 여러 코어를 통합하여 런타임 효율을 더욱 향상시킵니다.

X 플랫폼의 사용자 @shao__meng 은이 기술을 "AI 개발을위한 자동 기어 박스 설치"와 비교하여 일반적인 코드가 "경주 수준 성능으로 자동 업그레이드"할 수 있습니다. 또 다른 사용자 @Financeyf5는 또한 시스템의 출시가 AI 자체 최적화의 잠재력을 보여주고 향후 컴퓨팅 리소스 사용의 효율성을 혁신적인 개선 할 수 있다고 포스트에서 지적했다.

Sakana AI는 이전에 "AI 과학자"와 같은 프로젝트로 인해 업계에서 자리를 잡았습니다. "AI CUDA 엔지니어"의 출시는 AI 자동화 분야에서 야심을 강조합니다. 이 회사는이 시스템이 여러 Pytorch 운영을 다루는 17,000 개 이상의 CUDA 코어를 성공적으로 생성하고 확인했으며 노출 된 데이터 세트는 연구원과 개발자에게 귀중한 리소스를 제공 할 것이라고 주장합니다. 업계 내부자들은이 기술이 고성능 GPU 프로그래밍의 임계 값을 낮출뿐만 아니라 인공 지능 모델의 교육 및 배치 효율성을 새로운 수준으로 밀어 붙일 수 있다고 생각합니다.

정보 참조 : https://x.com/financeyf5/status/1892856847780237318