CLI สำหรับการปรับปรุงการแจ้งเตือน AI ของคุณอย่างรวดเร็ว ไม่จำเป็นต้องมีชุดข้อมูล

เพียงส่งพรอมต์และคำอธิบายของสิ่งที่คุณต้องการปรับปรุง จากนั้นจะใช้อัลกอริทึมทางพันธุกรรมเพื่อปรับแต่งพรอมต์ซ้ำ ๆ จนกว่าจะดีกว่าต้นฉบับ LLM ประเมินพรอมต์ที่ได้รับการแก้ไขเพื่อเป็นแนวทางในกระบวนการ แต่คุณยังสามารถกำหนดฟังก์ชั่นการประเมินของคุณเองได้

> pipx install promptimalเมื่อติดตั้งแล้วตรวจสอบให้แน่ใจว่าคุณได้เพิ่มคีย์ OpenAI API ของคุณในสภาพแวดล้อมของคุณ:

> export OPENAI_API_KEY= " ... " เปิดเครื่องมือจากเทอร์มินัลของคุณ:

> promptimalคุณจะถูกขอให้ป้อนพรอมต์เริ่มต้นและสิ่งที่คุณต้องการปรับปรุง หรือคุณสามารถระบุอินพุตเหล่านี้เป็นอาร์กิวเมนต์บรรทัดคำสั่ง:

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

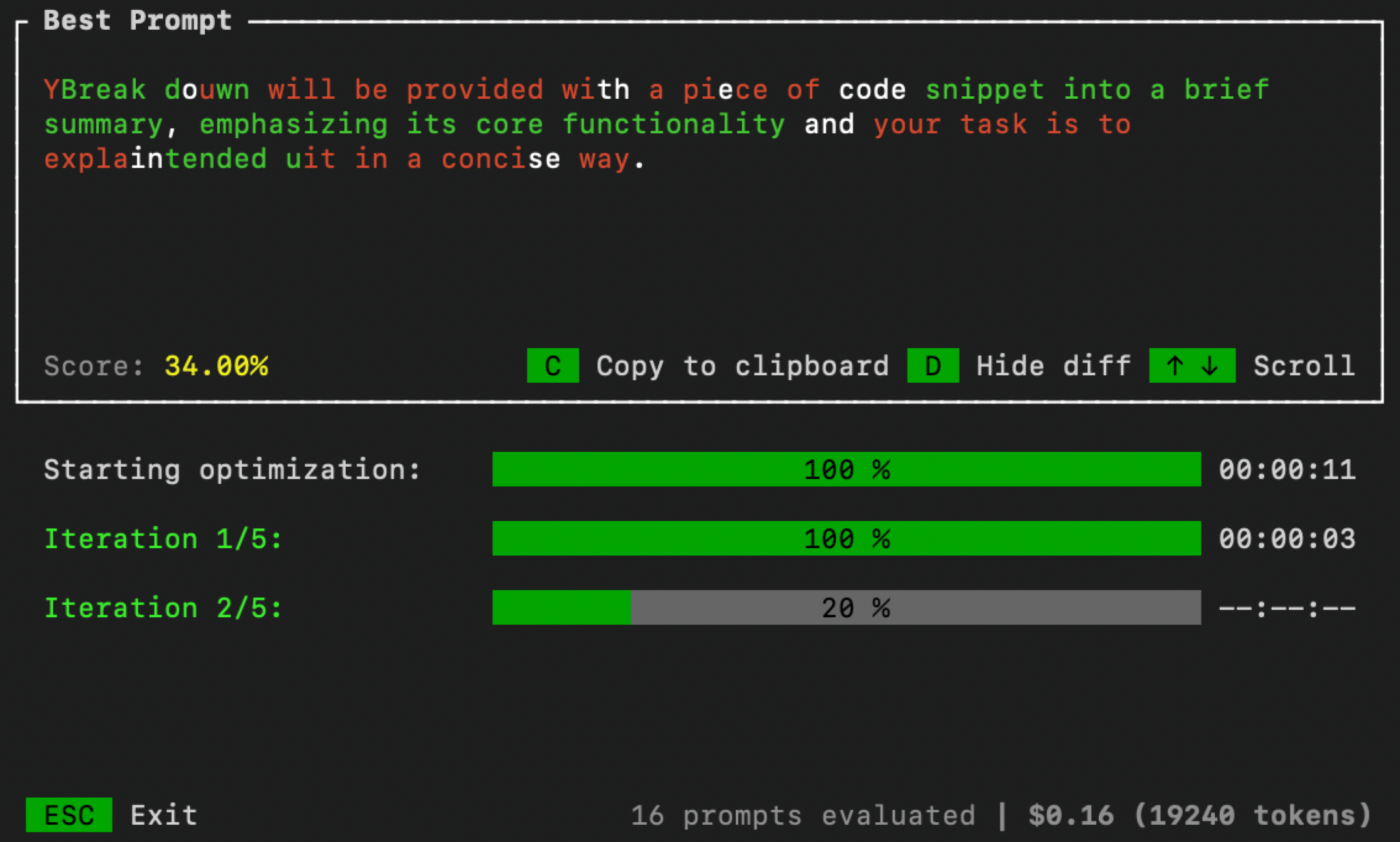

--improve " Summaries need to include less code references and be more high-level. "เมื่อเสร็จแล้ว UI จะเปิดในเทอร์มินัลของคุณเพื่อตรวจสอบกระบวนการปรับให้เหมาะสม:

คุณสามารถควบคุมพารามิเตอร์การเพิ่มประสิทธิภาพโดยผ่านอาร์กิวเมนต์บรรทัดคำสั่งเพิ่มเติม:

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : จำนวนการวนซ้ำเพื่อเรียกใช้ลูปการเพิ่มประสิทธิภาพสำหรับ เทียบเท่ากับจำนวน "รุ่น" ในอัลกอริทึมวิวัฒนาการnum_samples : จำนวนผู้สมัครที่ได้รับแจ้งเพื่อสร้างในการวนซ้ำแต่ละครั้ง เทียบเท่ากับ "ขนาดประชากร" ในอัลกอริทึมวิวัฒนาการthreshold : เกณฑ์การสิ้นสุดสำหรับลูป หากพรอมต์ของผู้สมัครได้รับคะแนนสูงกว่าเกณฑ์นี้ลูปการเพิ่มประสิทธิภาพจะหยุดลง ค่าเริ่มต้นคือ 1.0 โดยค่าเริ่มต้น Pretctimal ใช้วิธี LLM-as-Judge (ด้วยความสอดคล้องกัน) เพื่อประเมินผู้สมัครที่ได้รับการแจ้ง แต่เพื่อเพิ่มประสิทธิภาพคุณอาจต้องการประเมินพรอมต์กับชุดข้อมูลหรือใช้เทคนิคการประเมินอื่น ๆ ในการทำเช่นนี้ก่อนอื่นให้สร้างไฟล์ Python ที่เรียกว่า evaluator.py จากนั้นคัดลอก/วางรหัสด้านล่างลงในไฟล์นั้นและกำหนดฟังก์ชั่นการประเมินของคุณเอง:

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () เมื่อเสร็จแล้วให้ระบุเส้นทางไปยัง evaluator.py

> promptimal --evaluator= " path/to/evaluator.py "ไฟล์นี้จะทำหน้าที่เป็นสคริปต์ที่ใช้ในการประเมินพรอมต์ได้อย่างมีประสิทธิภาพ