CLI для быстрого улучшения ваших подсказок ИИ. Нет набора данных.

Просто отправьте свою подсказку и описание того, что вы хотите улучшить. Затем rackimal будет использовать генетический алгоритм, чтобы итеративно уточнить подсказку, пока он не станет лучше оригинал. LLM оценивает модифицированные подсказки для руководства процессом, но вы также можете определить свою собственную функцию оценки.

> pipx install promptimalПосле установки убедитесь, что у вас добавлен ключ API OpenAI в вашу среду:

> export OPENAI_API_KEY= " ... " Откройте инструмент из вашего терминала:

> promptimalВас попросят ввести свою первоначальную подсказку и то, что вы хотите улучшить. В качестве альтернативы, вы можете указать эти входы в качестве аргументов командной строки:

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

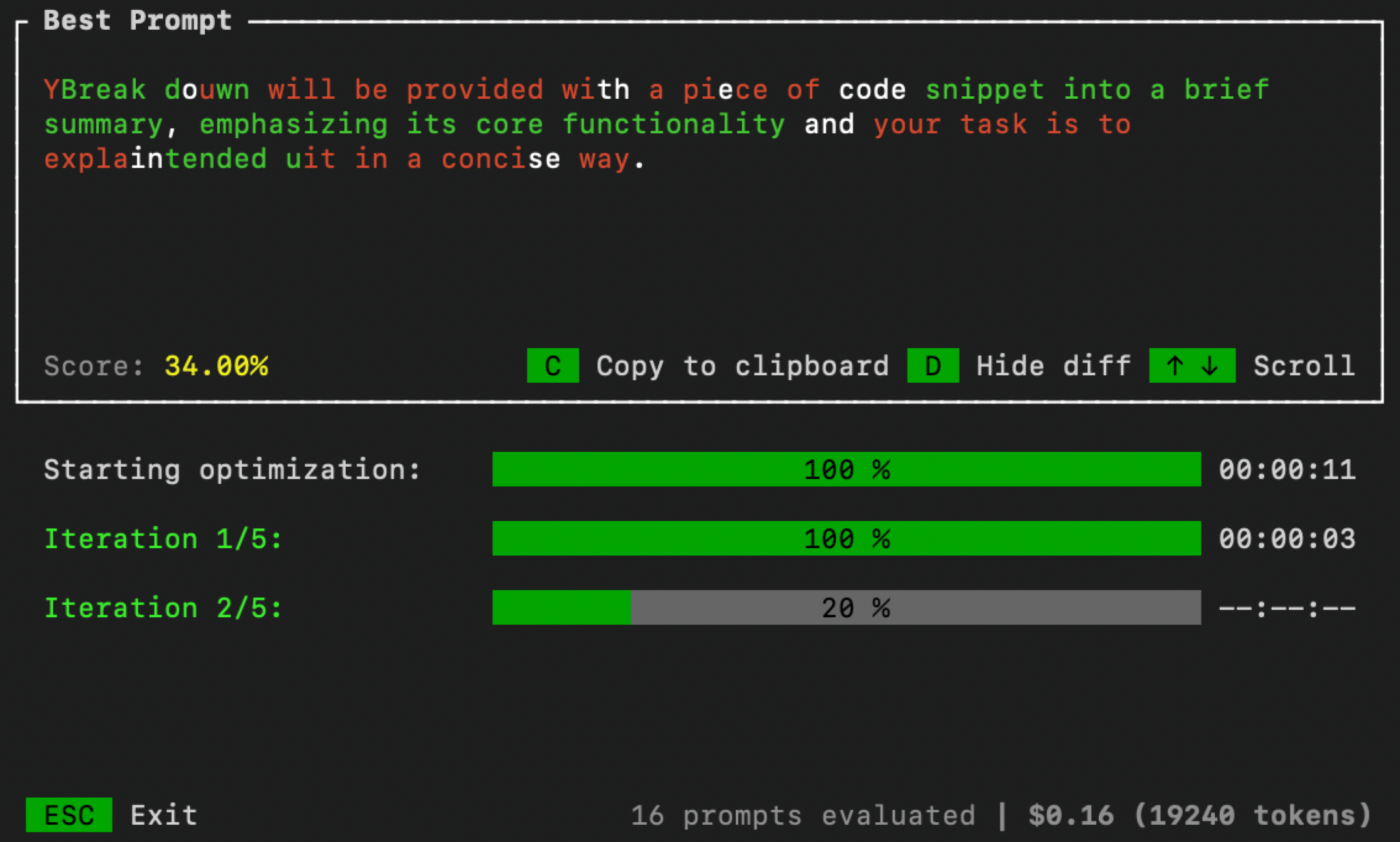

--improve " Summaries need to include less code references and be more high-level. "Как только вы закончите, в вашем терминале откроется пользовательский интерфейс для мониторинга процесса оптимизации:

Вы можете управлять параметрами оптимизации, передавая дополнительные аргументы командной строки:

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : количество итераций для запуска петли оптимизации для. Эквивалентно количеству «поколений» в эволюционном алгоритме.num_samples : количество подсказок кандидатов для генерации в каждой итерации. Эквивалент «численности населения» в эволюционном алгоритме.threshold : Порог завершения для петли. Если подсказка кандидата получает оценку выше этого порога, петля оптимизации остановится. По умолчанию 1,0. По умолчанию rackleimal использует подход LLM-как сумасшедший (с самосогласованностью) для оценки быстрого кандидатов. Но чтобы повысить производительность, вы можете оценить подсказки с набором данных или использовать какую -то другую технику оценки. Для этого сначала создайте файл Python с именем evaluator.py . Затем скопируйте/вставьте код ниже в этот файл и определите свою собственную функцию оценки:

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () После завершения указать путь к evaluator.py при запуске rasstical:

> promptimal --evaluator= " path/to/evaluator.py "Этот файл будет эффективно служить сценарием, который призрачный использует для оценки подсказок.