A CLI para melhorar rapidamente suas solicitações de IA. Nenhum conjunto de dados é necessário.

Basta enviar seu prompt e uma descrição do que você deseja melhorar. O Promptimal usará um algoritmo genético para refinar iterativamente o prompt até que seja melhor que o original. Um LLM avalia os avisos modificados para orientar o processo, mas você também pode definir sua própria função de avaliação.

> pipx install promptimalDepois de instalado, verifique se sua chave da API do OpenAI adicionou ao seu ambiente:

> export OPENAI_API_KEY= " ... " Abra a ferramenta do seu terminal:

> promptimalVocê será solicitado a inserir seu prompt inicial e o que deseja melhorar. Como alternativa, você pode especificar essas entradas como argumentos da linha de comando:

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

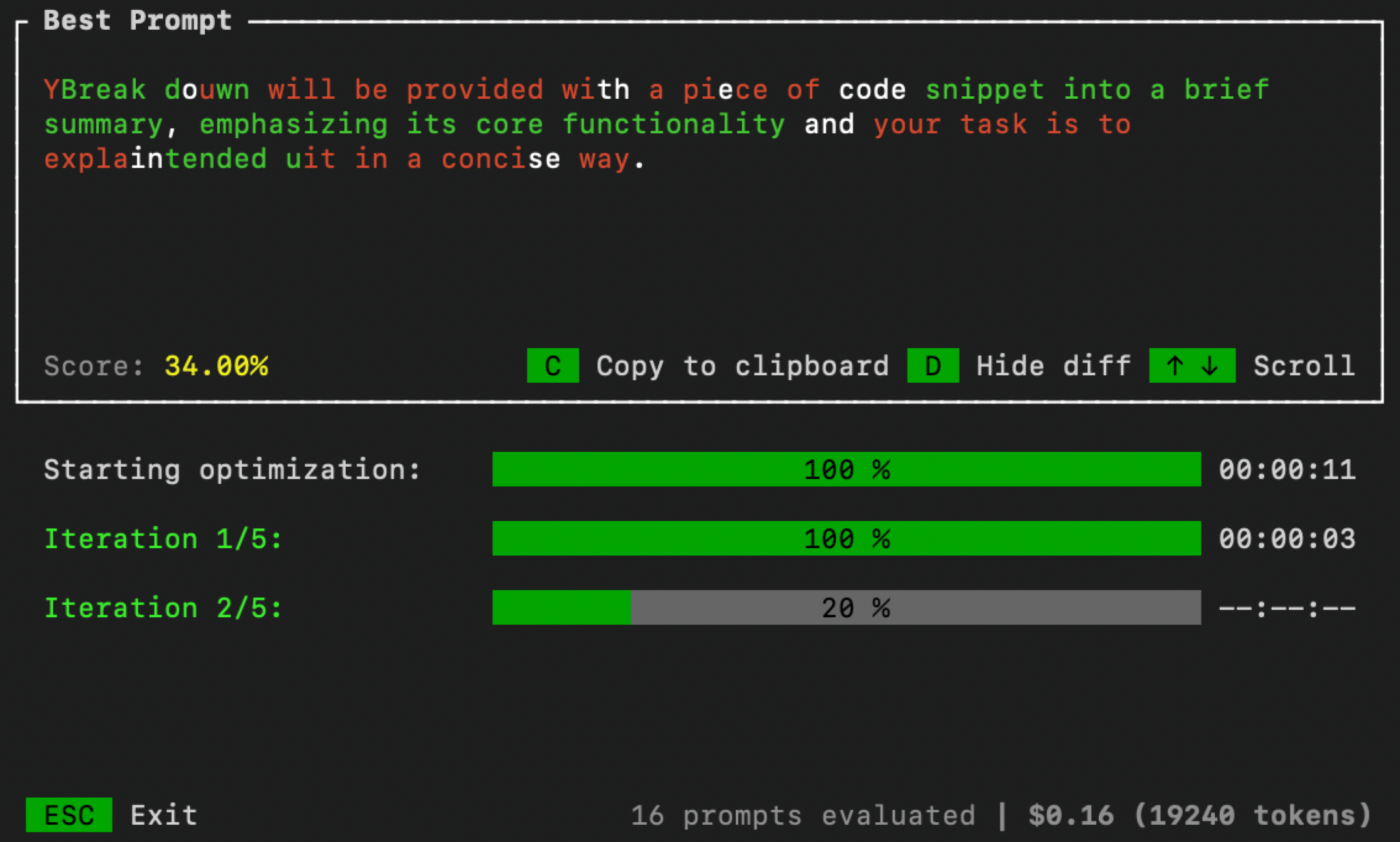

--improve " Summaries need to include less code references and be more high-level. "Depois de terminar, uma interface do usuário será aberta no seu terminal para monitorar o processo de otimização:

Você pode controlar os parâmetros de otimização passando argumentos adicionais da linha de comando:

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : Número de iterações para executar o loop de otimização. Equivalente ao número de "gerações" em um algoritmo evolutivo.num_samples : Número de avisos de candidatos a gerar em cada iteração. Equivalente ao "tamanho da população" em um algoritmo evolutivo.threshold : limiar de terminação para o loop. Se um prompt candidato obtiver uma pontuação mais alta que esse limite, o loop de otimização parará. O padrão é 1.0. Por padrão, o Randimal usa uma abordagem LLM-AS-JUDGE (com autoconsistência) para avaliar os candidatos imediatos. Mas, para aumentar o desempenho, convém avaliar prompts em relação a um conjunto de dados ou usar alguma outra técnica de avaliação. Para fazer isso, primeiro crie um arquivo python chamado evaluator.py . Em seguida, copie/cole o código abaixo nesse arquivo e defina sua própria função de avaliação:

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () Depois de terminar, especifique o caminho para evaluator.py quando você executar o Promptimal:

> promptimal --evaluator= " path/to/evaluator.py "Esse arquivo servirá efetivamente como um script que o Promptimal usa para avaliar os prompts.