CLI untuk meningkatkan petunjuk AI Anda dengan cepat. Tidak ada dataset yang diperlukan.

Cukup kirimkan prompt Anda dan deskripsi tentang apa yang ingin Anda tingkatkan. Promptimal kemudian akan menggunakan algoritma genetika untuk secara iteratif memperbaiki prompt sampai lebih baik dari aslinya. LLM mengevaluasi prompt yang dimodifikasi untuk memandu proses, tetapi Anda juga dapat menentukan fungsi evaluasi Anda sendiri.

> pipx install promptimalSetelah diinstal, pastikan Anda memiliki kunci API OpenAI Anda ditambahkan ke lingkungan Anda:

> export OPENAI_API_KEY= " ... " Buka alat dari terminal Anda:

> promptimalAnda akan diminta untuk memasukkan prompt awal Anda dan apa yang ingin Anda tingkatkan. Atau, Anda dapat menentukan input ini sebagai argumen baris perintah:

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

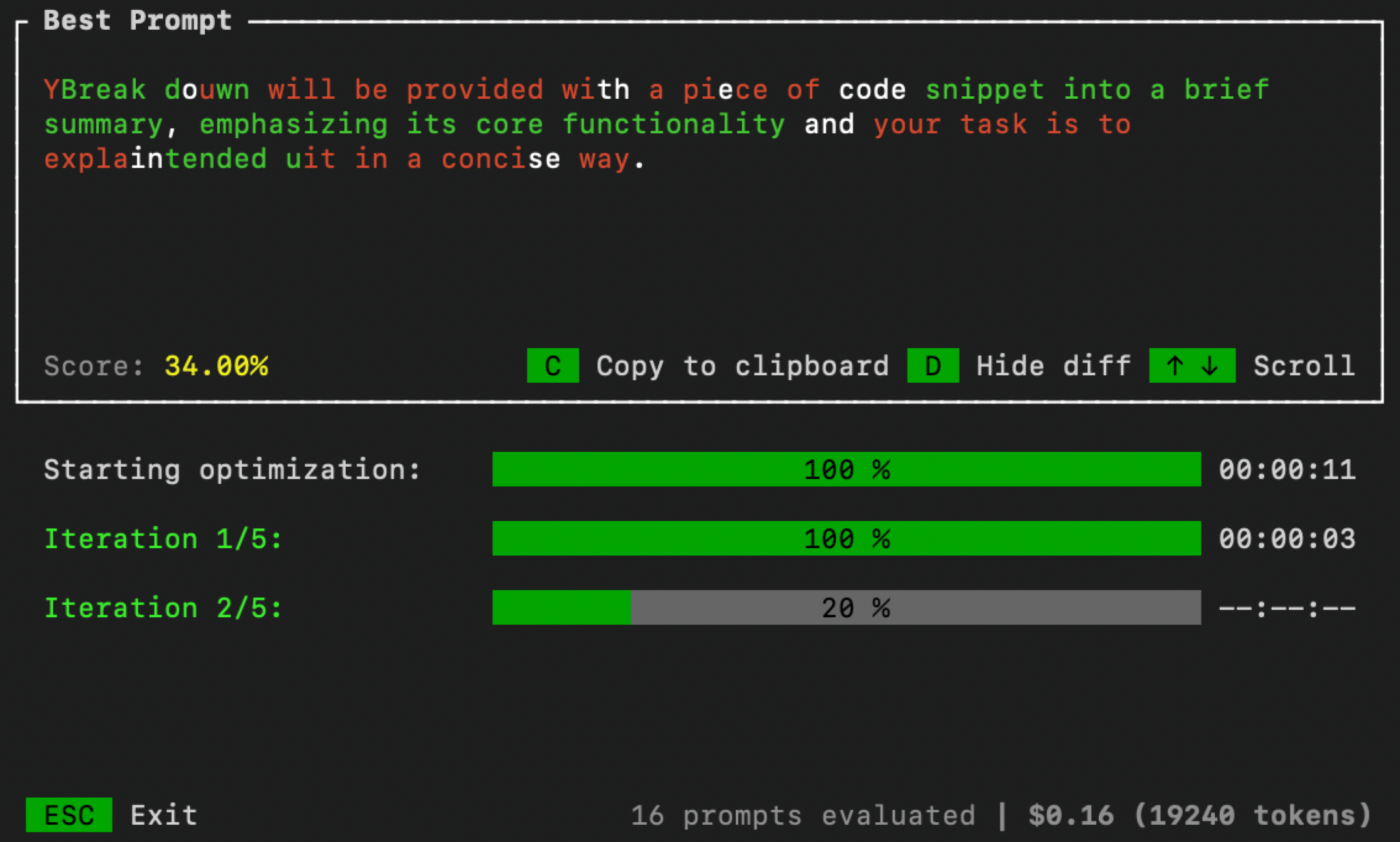

--improve " Summaries need to include less code references and be more high-level. "Setelah selesai, UI akan terbuka di terminal Anda untuk memantau proses optimasi:

Anda dapat mengontrol parameter optimasi dengan meloloskan argumen baris perintah tambahan:

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : Jumlah iterasi untuk menjalankan loop optimasi. Setara dengan jumlah "generasi" dalam algoritma evolusi.num_samples : Jumlah kandidat yang diminta untuk menghasilkan di setiap iterasi. Setara dengan "ukuran populasi" dalam algoritma evolusi.threshold : Ambang batas penghentian untuk loop. Jika prompt kandidat mendapatkan skor lebih tinggi dari ambang ini, loop optimasi akan berhenti. Default adalah 1.0. Secara default, PromptImal menggunakan pendekatan LLM-as-Judge (dengan konsistensi diri) untuk mengevaluasi kandidat yang cepat. Tetapi untuk meningkatkan kinerja, Anda mungkin ingin mengevaluasi petunjuk terhadap dataset atau menggunakan beberapa teknik evaluasi lainnya. Untuk melakukan ini, pertama -tama buat file python yang disebut evaluator.py . Kemudian salin/tempel kode di bawah ini ke dalam file itu dan tentukan fungsi evaluasi Anda sendiri:

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () Setelah selesai, tentukan jalur ke evaluator.py saat Anda menjalankan promptimal:

> promptimal --evaluator= " path/to/evaluator.py "File ini akan secara efektif berfungsi sebagai skrip yang digunakan dengan cepat untuk mengevaluasi petunjuk.