CLI para mejorar rápidamente sus indicaciones de IA. No se necesita ningún conjunto de datos.

Simplemente envíe su aviso y una descripción de lo que desea mejorar. TRAdImal usará un algoritmo genético para refinar iterativamente el aviso hasta que sea mejor que el original. Un LLM evalúa las indicaciones modificadas para guiar el proceso, pero también puede definir su propia función de evaluación.

> pipx install promptimalUna vez instalado, asegúrese de agregar su tecla API OpenAI a su entorno:

> export OPENAI_API_KEY= " ... " Abra la herramienta desde su terminal:

> promptimalSe le pedirá que ingrese su mensaje inicial y lo que desea mejorar. Alternativamente, puede especificar estas entradas como argumentos de línea de comandos:

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

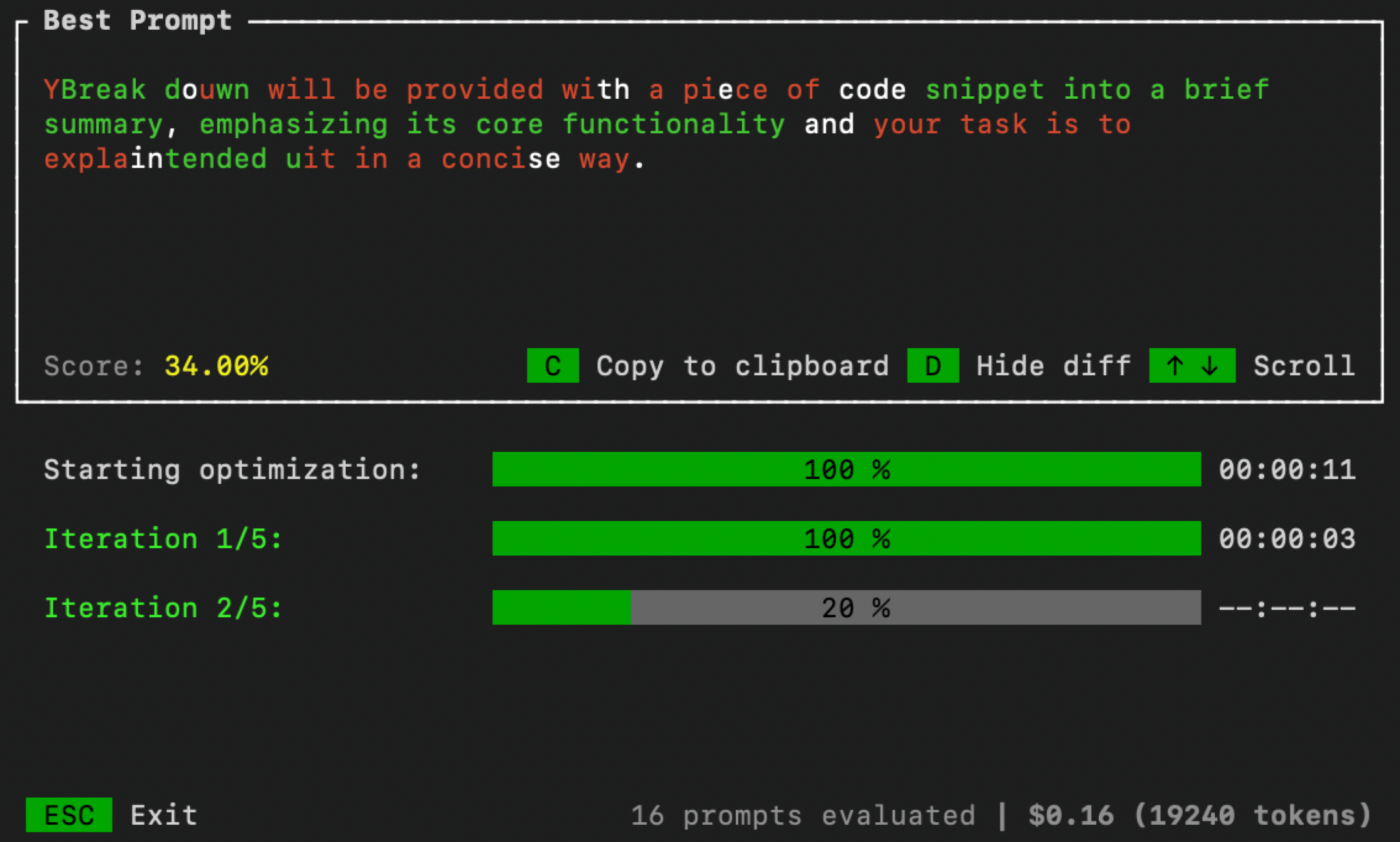

--improve " Summaries need to include less code references and be more high-level. "Una vez que haya terminado, una interfaz de usuario se abrirá en su terminal para monitorear el proceso de optimización:

Puede controlar los parámetros de optimización pasando argumentos de línea de comandos adicionales:

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : número de iteraciones para ejecutar el bucle de optimización para. Equivalente al número de "generaciones" en un algoritmo evolutivo.num_samples : número de indicaciones candidatas para generar en cada iteración. Equivalente al "tamaño de la población" en un algoritmo evolutivo.threshold : umbral de terminación para el bucle. Si un mensaje candidato obtiene una puntuación más alta que este umbral, el bucle de optimización se detendrá. El valor predeterminado es 1.0. De forma predeterminada, TISTIMAL utiliza un enfoque de LLM-as-Judge (con autoconsistencia) para evaluar a los candidatos rápidos. Pero para aumentar el rendimiento, es posible que desee evaluar las indicaciones en un conjunto de datos o utilizar alguna otra técnica de evaluación. Para hacer esto, primero cree un archivo Python llamado evaluator.py . Luego copie/pegue el código a continuación en ese archivo y defina su propia función de evaluación:

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () Una vez terminado, especifique la ruta a evaluator.py cuando ejecute PrompiliMal:

> promptimal --evaluator= " path/to/evaluator.py "Este archivo servirá efectivamente como un script que utiliza PrompiliMal para evaluar las indicaciones.