promptimal

1.0.0

AI 프롬프트를 신속하게 향상시키기위한 CLI. 데이터 세트가 필요하지 않습니다.

프롬프트와 개선하려는 것에 대한 설명을 제출하십시오. Promptimal은 유전자 알고리즘을 사용하여 원본보다 나을 때까지 프롬프트를 반복적으로 개선합니다. LLM은 프로세스를 안내하기 위해 수정 된 프롬프트를 평가하지만 자체 평가 기능을 정의 할 수도 있습니다.

> pipx install promptimal일단 설치되면 OpenAI API 키가 환경에 추가되어 있는지 확인하십시오.

> export OPENAI_API_KEY= " ... " 터미널에서 도구를 엽니 다 :

> promptimal초기 프롬프트와 개선하려는 내용을 입력하라는 요청을받을 수 있습니다. 또는 이러한 입력을 명령 줄 인수로 지정할 수 있습니다.

> promptimal

--prompt " You will be provided with a piece of code, and your task is to explain it in a concise way. "

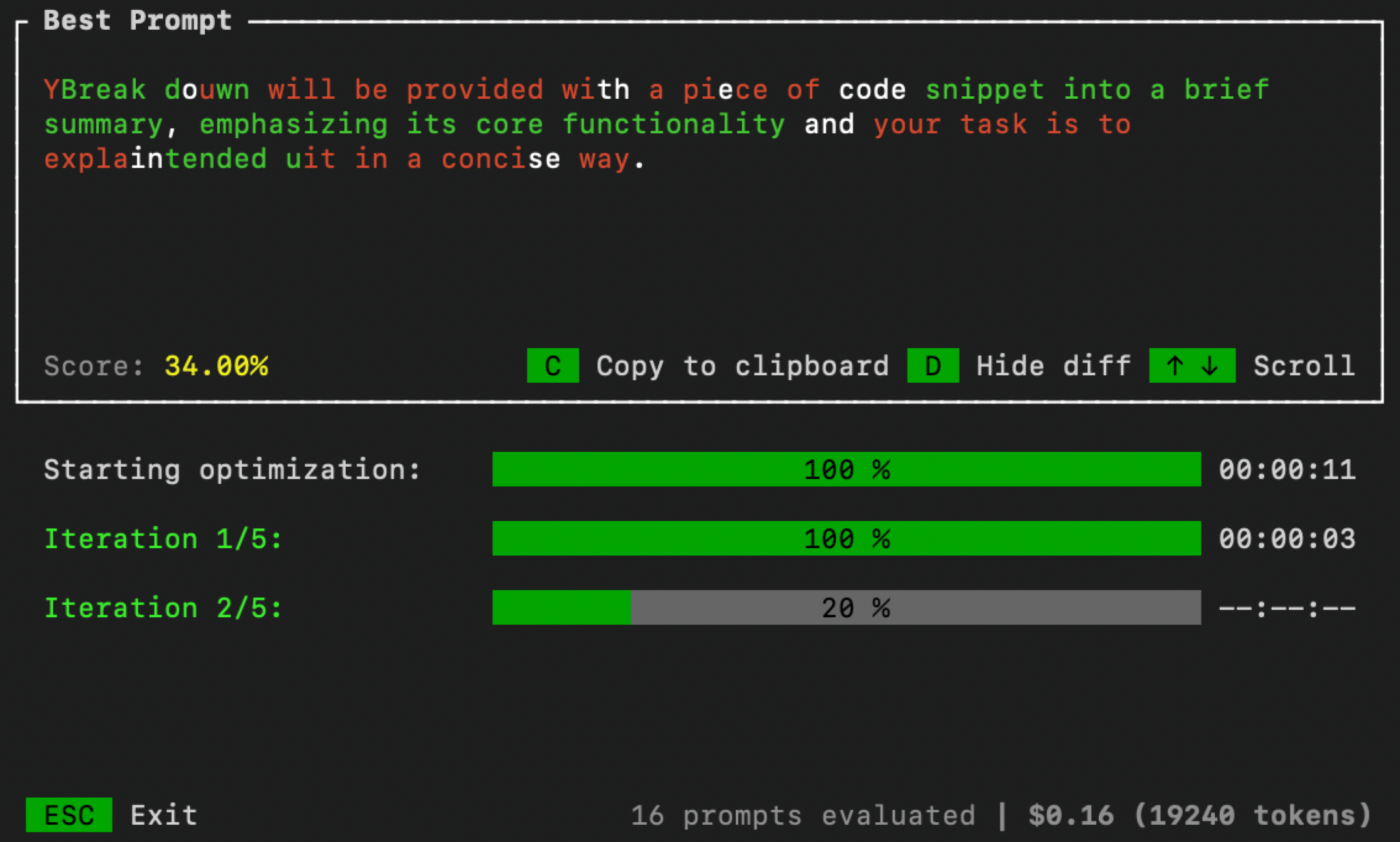

--improve " Summaries need to include less code references and be more high-level. "완료되면 최적화 프로세스 모니터링을 위해 터미널에서 UI가 열립니다.

추가 명령 줄 인수를 전달하여 최적화 매개 변수를 제어 할 수 있습니다.

> promptimal --num_iters=10 --num_samples=20 --threshold=0.7num_iters : 최적화 루프를 실행하기위한 반복 횟수. 진화 알고리즘의 "세대"수와 동일합니다.num_samples : 각 반복에서 생성해야 할 후보 프롬프트 수. 진화 알고리즘의 "인구 규모"와 동일합니다.threshold : 루프의 종료 임계 값. 후보 프롬프트 가이 임계 값보다 점수가 높아지면 최적화 루프가 중지됩니다. 기본값은 1.0입니다. 기본적으로 Promptimal은 LLM-as-judge 접근법 (자기 일관성이 있음)을 사용하여 신속한 후보를 평가합니다. 그러나 성능을 높이려면 데이터 세트에 대한 프롬프트를 평가하거나 다른 평가 기술을 사용하려고합니다. 이렇게하려면 먼저 evaluator.py 라는 Python 파일을 만듭니다. 그런 다음 아래 코드를 해당 파일에 복사/붙여 넣고 자체 평가 기능을 정의하십시오.

import argparse

def evaluator ( prompt : str ) -> float :

# Your code goes here

# Must return value between 0 and 1

def main ():

parser = argparse . ArgumentParser ()

parser . add_argument ( "--prompt" , required = True , type = str )

args = parser . parse_args ()

score = evaluator ( args . prompt )

print ( score )

if __name__ == "__main__" :

main () 완료되면 Promptimal을 실행할 때 evaluator.py 의 경로를 지정하십시오.

> promptimal --evaluator= " path/to/evaluator.py "이 파일은 프롬프트가 프롬프트를 평가하는 데 사용하는 스크립트 역할을합니다.