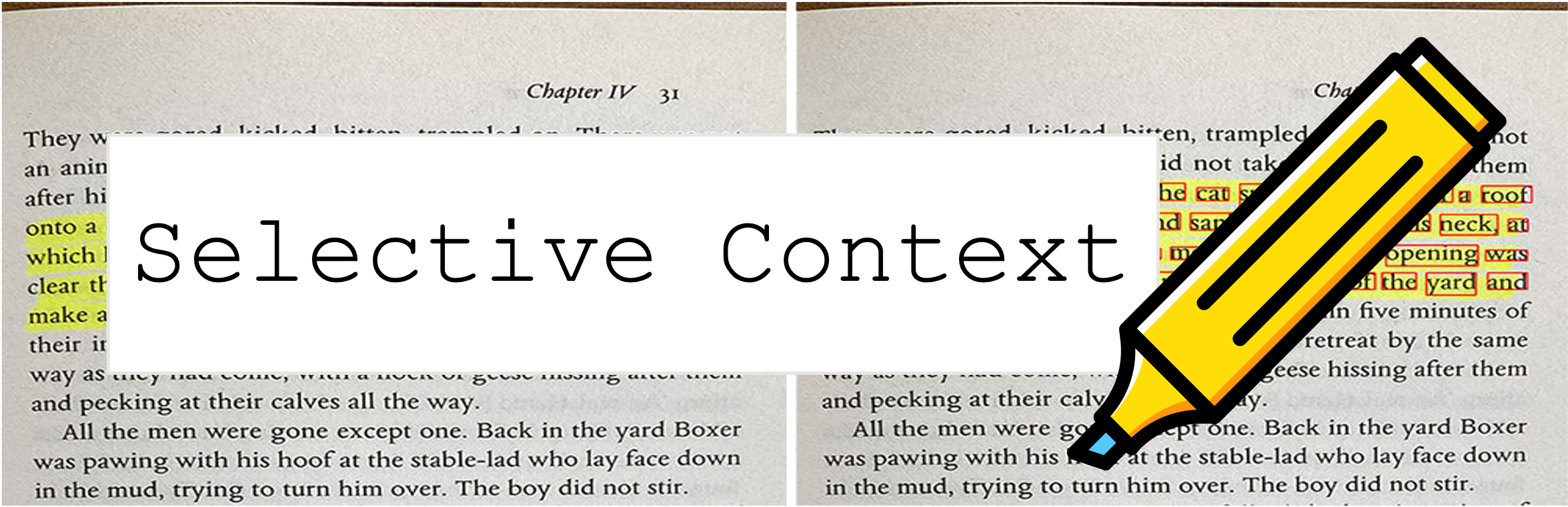

บริบทที่เลือกจะบีบอัดพรอมต์และบริบทของคุณเพื่อให้ LLMs (เช่น chatgpt) ประมวลผลเนื้อหาเพิ่มเติม 2x มันมีประโยชน์อย่างยิ่งในการจัดการกับเอกสารที่ยาวนานและยังคงการสนทนาที่ยาวนานโดยไม่ลดทอนประสิทธิภาพของพวกเขาในงานต่าง ๆ !

ที่เก็บนี้มีรหัสและข้อมูลสำหรับกระดาษ: การบีบอัดบริบทเพื่อเพิ่มประสิทธิภาพการอนุมานของแบบจำลองภาษาขนาดใหญ่

9 ต.ค. 2023 : งานนี้ได้รับการยอมรับสำหรับการดำเนินการหลักของ EMNLP 2023 ? ลิงค์กระดาษด้านบนเป็นเวอร์ชันการประชุมล่าสุด หากคุณกำลังมองหากระดาษ arxiv รุ่นก่อนหน้า: ปลดล็อคข้อ จำกัด บริบทของ LLMS

6 พฤษภาคม 2023 : ลองสาธิตของเราในพื้นที่ HuggingFace

ในการเริ่มต้นให้ทำตามขั้นตอนเหล่านี้:

ติดตั้ง selective-context ผ่าน PYPI:

pip install selective-context

python -m spacy download en_core_web_sm

หากคุณกำลังประมวลผลภาษาจีนให้เรียกใช้ python -m spacy download zh_core_web_sm เช่นกัน

นำเข้า SelectiveContext :

from selective_context import SelectiveContext

บีบอัดพรอมต์และบริบทของคุณ context มีบริบทบีบอัด:

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

นอกจากนี้คุณยังสามารถปรับอัตราส่วนลด:

context, reduced_content = sc(text, reduce_ratio = 0.5)

หากคุณต้องการลองใช้เว็บอินเตอร์เฟสให้ลองใช้แอพ Streamlit ของเรา:

streamlit run app/app.py

หรือเยี่ยมชมพื้นที่ของเราโดยตรงบน Hugging Face Hub

selective_context.py : ตัวอย่างสำหรับการลดบริบทโดยใช้บริบทที่เลือกcontext_manager.py : โมดูลหลักสำหรับการจัดการบริบทและการใช้อัลกอริทึมบริบทที่เลือกmain.py : สคริปต์หลักสำหรับการทดลองและประเมินประสิทธิภาพของบริบทที่เลือกqa_manager.py : โมดูลผู้ช่วยสำหรับการจัดการงานตอบคำถามในระหว่างการทดลอง เพื่อทำซ้ำการทดลองจากกระดาษ:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

ชุดข้อมูลที่ใช้ในกระดาษสามารถดูได้ที่:

ชุดข้อมูลถูกสร้างขึ้นด้วยตัวเองดังนั้นหากคุณต้องการการอ้างอิงเพียงใช้การอ้างอิงของเครื่องมือนี้

หากคุณมีปัญหาในการเข้าถึง HuggingFace Hub ให้ดาวน์โหลดข้อมูลผ่าน:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

หากคุณพบว่าที่เก็บนี้มีประโยชน์หรือใช้วิธีการของเราในการวิจัยของคุณโปรดพิจารณาอ้างถึงบทความของเรา:

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

เวอร์ชันก่อนหน้า:

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

โครงการนี้ได้รับใบอนุญาตภายใต้ใบอนุญาต MIT