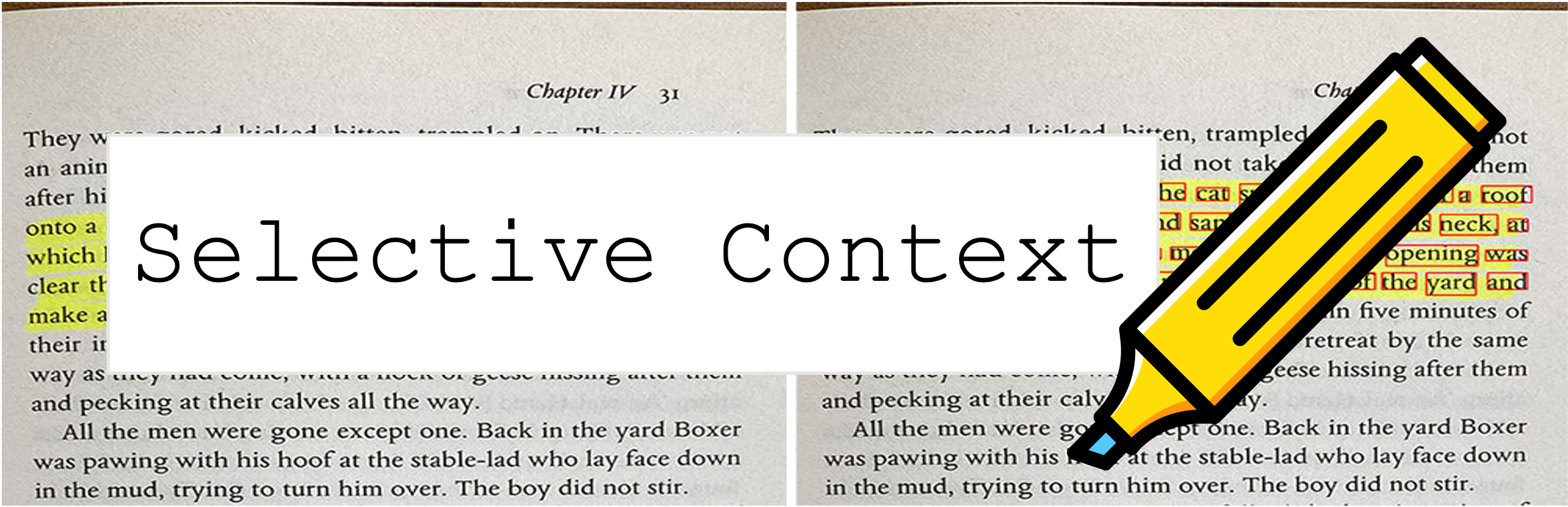

Selective Contextは、プロンプトとコンテキストを圧縮して、LLMS(ChatGPTなど)が2倍のコンテンツを処理できるようにします。さまざまなタスクでのパフォーマンスを損なうことなく、長いドキュメントを扱い、長い会話を維持するのに特に役立ちます!

このリポジトリには、大規模な言語モデルの推論効率を高めるためのコンテキストの圧縮コンテキストのコードとデータが含まれています。

2023年10月9日:この作業は、 EMNLP 2023の主要な議事録に対して受け入れられています。上記のペーパーリンクは、最新の会議版です。以前のARXIVバージョンの論文を探している場合:LLMSのコンテキスト制約のロックを解除します。

2023年5月6日:Huggingfaceスペースでデモを試してみてください。

開始するには、次の手順に従ってください。

Pypi経由でselective-contextをインストールします。

pip install selective-context

python -m spacy download en_core_web_sm

中国語を処理している場合は、 python -m spacy download zh_core_web_sm 。

SelectiveContextをインポートします:

from selective_context import SelectiveContext

プロンプトとコンテキストを圧縮します。 contextには、圧縮コンテキストが含まれています。

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

削減比を調整することもできます。

context, reduced_content = sc(text, reduce_ratio = 0.5)

Webインターフェイスを試してみたい場合は、retrienlitアプリをお試しください。

streamlit run app/app.py

または、顔のハブを抱き締めるスペースを直接訪れます。

selective_context.py :選択的コンテキストを使用してコンテキスト削減を実行するためのデモ。context_manager.py :コンテキストを管理し、選択的コンテキストアルゴリズムを実装するためのメインモジュール。main.py :実験を実行し、選択的コンテキストの有効性を評価するためのメインスクリプト。qa_manager.py :実験中に質問に答える質問を管理するためのヘルパーモジュール。 紙からの実験を再現するには:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

論文で使用されているデータセットは、次のように見つけることができます。

データセットは自分で作成されているため、引用が必要な場合は、このツールの引用を使用してください。

Huggingface Hubにアクセスするのに問題がある場合は、以下を介してデータをダウンロードしてください。

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

このリポジトリが役立つか、研究で私たちの方法を使用している場合は、私たちの論文を引用することを検討してください。

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

前のバージョン:

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

このプロジェクトは、MITライセンスの下でライセンスされています。