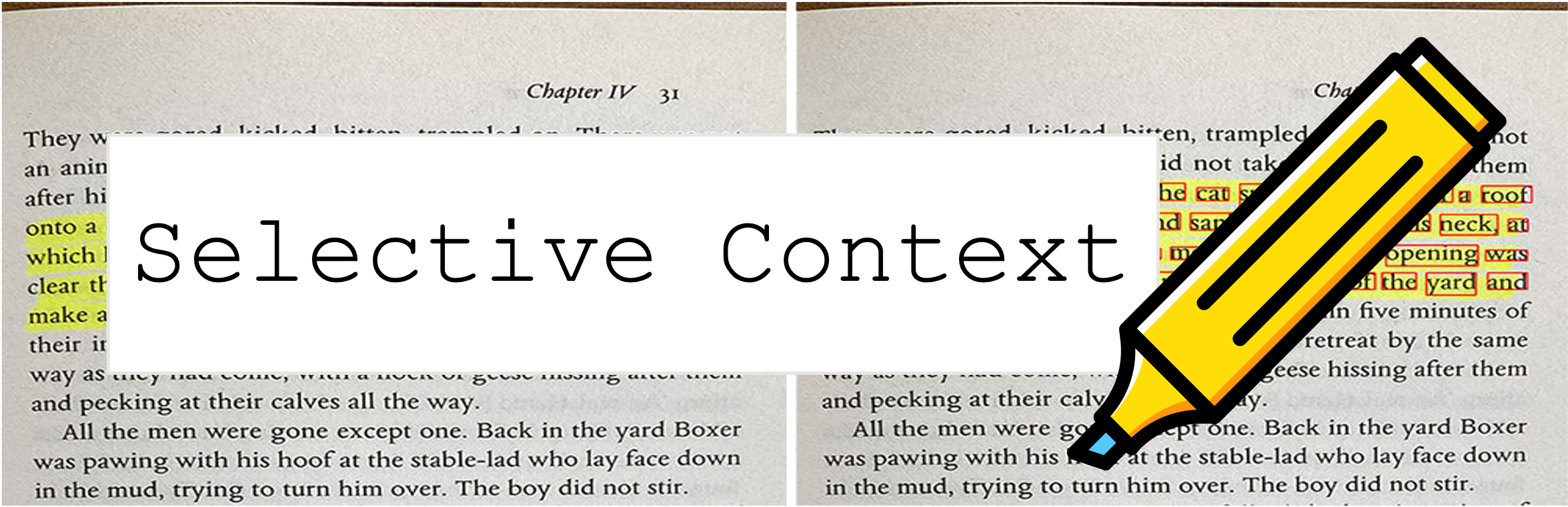

Konteks selektif mengompres prompt dan konteks Anda untuk memungkinkan LLMS (seperti chatgpt) untuk memproses 2x lebih banyak konten. Ini sangat berguna dalam menangani dokumen panjang dan memelihara percakapan panjang tanpa mengurangi kinerja mereka pada berbagai tugas!

Repositori ini berisi kode dan data untuk makalah: Mengompresi konteks untuk meningkatkan efisiensi inferensi model bahasa besar.

9 Okt 2023 : Pekerjaan ini telah diterima untuk proses utama EMNLP 2023 ? Tautan makalah di atas adalah versi konferensi terbaru. Jika Anda mencari versi ARXIV sebelumnya dari makalah ini: Membuka batasan konteks LLMS.

6 Mei 2023 : Coba demo kami di ruang pelukan.

Untuk memulai, ikuti langkah -langkah ini:

Instal selective-context melalui PYPI:

pip install selective-context

python -m spacy download en_core_web_sm

Jika Anda memproses bahasa Mandarin, jalankan python -m spacy download zh_core_web_sm juga.

Impor SelectiveContext :

from selective_context import SelectiveContext

Kompres prompt dan konteks Anda. context berisi konteks terkompresi:

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

Anda juga dapat menyesuaikan rasio pengurangan:

context, reduced_content = sc(text, reduce_ratio = 0.5)

Jika Anda lebih suka mencoba dengan antarmuka web, coba aplikasi streamLit kami:

streamlit run app/app.py

Atau langsung mengunjungi ruang kami di Hugging Face Hub.

selective_context.py : Demo untuk melakukan pengurangan konteks menggunakan konteks selektif.context_manager.py : Modul utama untuk mengelola konteks dan mengimplementasikan algoritma konteks selektif.main.py : Skrip utama untuk menjalankan eksperimen dan mengevaluasi efektivitas konteks selektif.qa_manager.py : Modul helper untuk mengelola tugas menjawab tugas selama percobaan. Untuk mereproduksi percobaan dari kertas:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

Dataset yang digunakan dalam kertas dapat ditemukan di:

Kumpulan data dibuat sendiri sehingga jika Anda memerlukan kutipan, gunakan kutipan dari alat ini.

Jika Anda mengalami kesulitan mengakses hub HuggingFace, unduh data melalui:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

Jika Anda menemukan repositori ini bermanfaat atau menggunakan metode kami dalam riset Anda, harap pertimbangkan mengutip makalah kami:

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Versi sebelumnya:

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Proyek ini dilisensikan di bawah lisensi MIT.