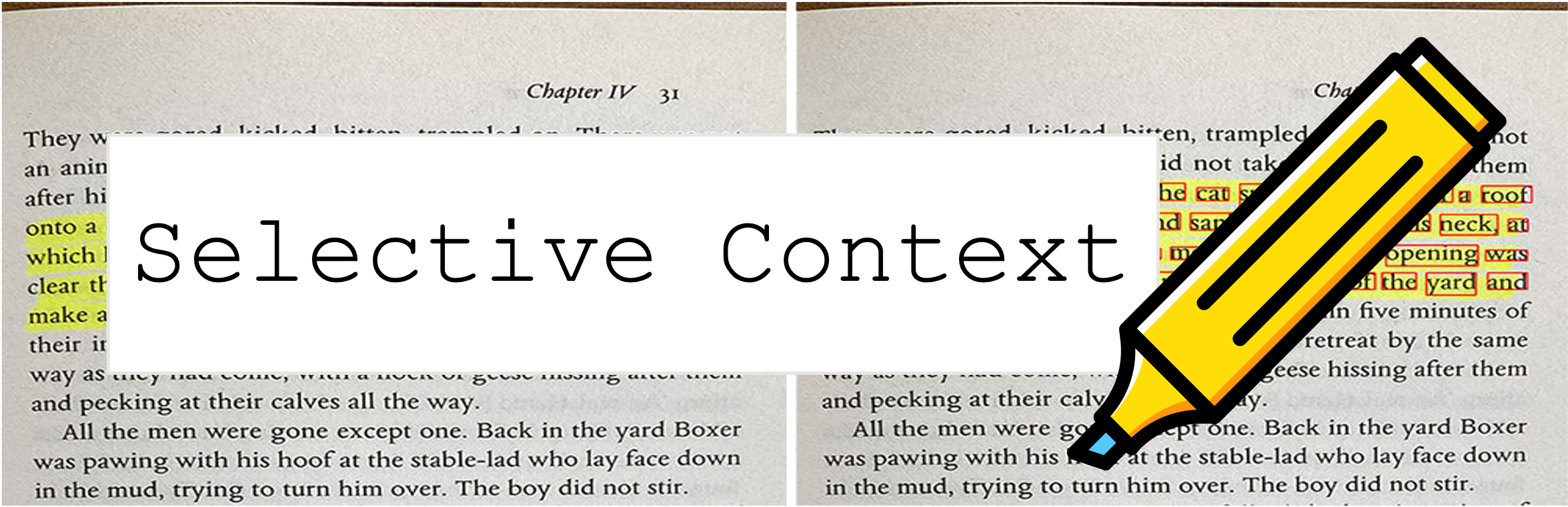

سياق الانتقائي يضغط المطالبة والسياق الخاص بك للسماح LLMS (مثل ChatGPT) بمعالجة محتوى مزيد من 2x. إنه مفيد بشكل خاص في التعامل مع المستندات الطويلة والحفاظ على محادثات طويلة دون المساس بأدائها في مختلف المهام!

يحتوي هذا المستودع على الكود والبيانات الخاصة بالورقة: ضغط السياق لتعزيز كفاءة الاستدلال لنماذج اللغة الكبيرة.

9 أكتوبر 2023 : تم قبول هذا العمل للإجراءات الرئيسية لـ EMNLP 2023 ؟ الرابط الورقي أعلاه هو أحدث إصدار للمؤتمرات. إذا كنت تبحث عن إصدار Arxiv السابق من الورقة: فتح قيود السياق من LLMS.

6 مايو 2023 : جرب العرض التوضيحي الخاص بنا على مساحة Huggingface.

للبدء ، اتبع هذه الخطوات:

تثبيت selective-context عبر PYPI:

pip install selective-context

python -m spacy download en_core_web_sm

إذا كنت تقوم بمعالجة الصينية ، فقم بتشغيل python -m spacy download zh_core_web_sm أيضًا.

استيراد SelectiveContext :

from selective_context import SelectiveContext

اضغط على المطالبة والسياق. يحتوي context على السياق المضغوط:

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

يمكنك أيضًا ضبط نسبة تقليل:

context, reduced_content = sc(text, reduce_ratio = 0.5)

إذا كنت تفضل المحاولة مع واجهة الويب ، جرب تطبيق SPEREMLIT:

streamlit run app/app.py

أو قم بزيارة مساحتنا بشكل مباشر على Huging Face Hub.

selective_context.py : عرض تجريبي لأداء الحد من السياق باستخدام سياق انتقائي.context_manager.py : الوحدة الرئيسية لإدارة السياق وتنفيذ خوارزمية السياق الانتقائي.main.py : البرنامج النصي الرئيسي لتشغيل التجارب وتقييم فعالية السياق الانتقائي.qa_manager.py : وحدة مساعد لإدارة المهام الإجابة على الأسئلة أثناء التجارب. لإعادة إنتاج التجارب من الورقة:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

يمكن العثور على مجموعة البيانات المستخدمة في الورقة على:

يتم إنشاء مجموعات البيانات من قبل أنفسنا ، لذلك إذا كنت بحاجة إلى اقتباس ، فما عليك سوى استخدام استشهاد بهذه الأداة.

إذا كنت تواجه مشكلة في الوصول إلى Huggingface Hub ، فقم بتنزيل البيانات عبر:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

إذا وجدت هذا المستودع مفيدًا أو استخدم طريقتنا في بحثك ، فيرجى التفكير في ذكر ورقتنا:

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

الإصدار السابق:

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

هذا المشروع مرخص بموجب ترخيص معهد ماساتشوستس للتكنولوجيا.