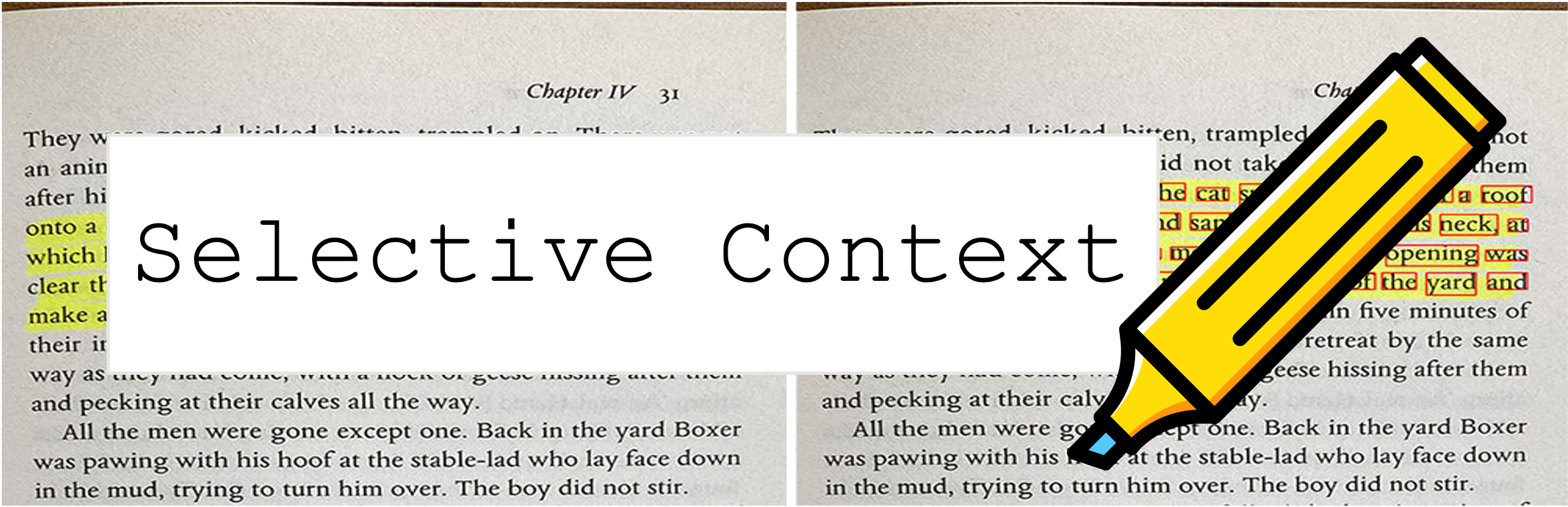

선택적 컨텍스트는 프롬프트와 컨텍스트를 압축하여 LLM (예 : ChatGpt)이 2 배 더 많은 컨텐츠를 처리 할 수 있도록합니다. 다양한 작업에 대한 성과를 손상시키지 않고 긴 문서를 다루고 긴 대화를 유지하는 데 특히 유용합니다!

이 저장소에는 논문의 코드 및 데이터가 포함되어 있습니다. 대형 언어 모델의 추론 효율성을 향상시키기위한 컨텍스트 압축.

2023 년 10 월 9 일 :이 작업은 EMNLP 2023 의 주요 절차를 위해 받아 들여 졌습니까?. 위의 종이 링크는 최신 컨퍼런스 버전입니다. 논문의 이전 ARXIV 버전을 찾고 있다면 LLM의 잠금 해제 컨텍스트 제약 조건.

2023 년 5 월 6 일 : 포옹 페이스 공간에 대한 데모를 시도하십시오.

시작하려면 다음 단계를 따르십시오.

PYPI를 통해 selective-context 설치하십시오.

pip install selective-context

python -m spacy download en_core_web_sm

중국어를 처리하는 경우 python -m spacy download zh_core_web_sm 도 실행하십시오.

SelectiveContext 가져 오기 :

from selective_context import SelectiveContext

프롬프트와 컨텍스트를 압축하십시오. context 에는 압축 컨텍스트가 포함됩니다.

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

또한 감소 비율을 조정할 수도 있습니다.

context, reduced_content = sc(text, reduce_ratio = 0.5)

웹 인터페이스로 시도하려면 간소화 앱을 사용해보십시오.

streamlit run app/app.py

또는 포옹 페이스 허브의 공간을 직접 방문하십시오.

selective_context.py : 선택적 컨텍스트를 사용하여 컨텍스트 감소를 수행하기위한 데모.context_manager.py : 컨텍스트를 관리하고 선택적 컨텍스트 알고리즘을 구현하기위한 기본 모듈.main.py : 실험을 진행하고 선택적 컨텍스트의 효과를 평가하기위한 주요 스크립트.qa_manager.py : 실험 중 작업 응답 작업을 관리하기위한 도우미 모듈. 논문에서 실험을 재현하려면 :

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

논문에 사용 된 데이터 세트는 다음에서 찾을 수 있습니다.

데이터 세트는 스스로 생성되므로 인용이 필요한 경우이 도구의 인용을 사용하십시오.

Huggingface Hub에 액세스하는 데 어려움이있는 경우 다음을 통해 데이터를 다운로드하십시오.

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

이 저장소가 도움이되거나 연구에서 당사의 방법을 사용하는 경우, 논문을 인용하는 것을 고려하십시오.

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

이전 버전 :

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

이 프로젝트는 MIT 라이센스에 따라 라이센스가 부여됩니다.