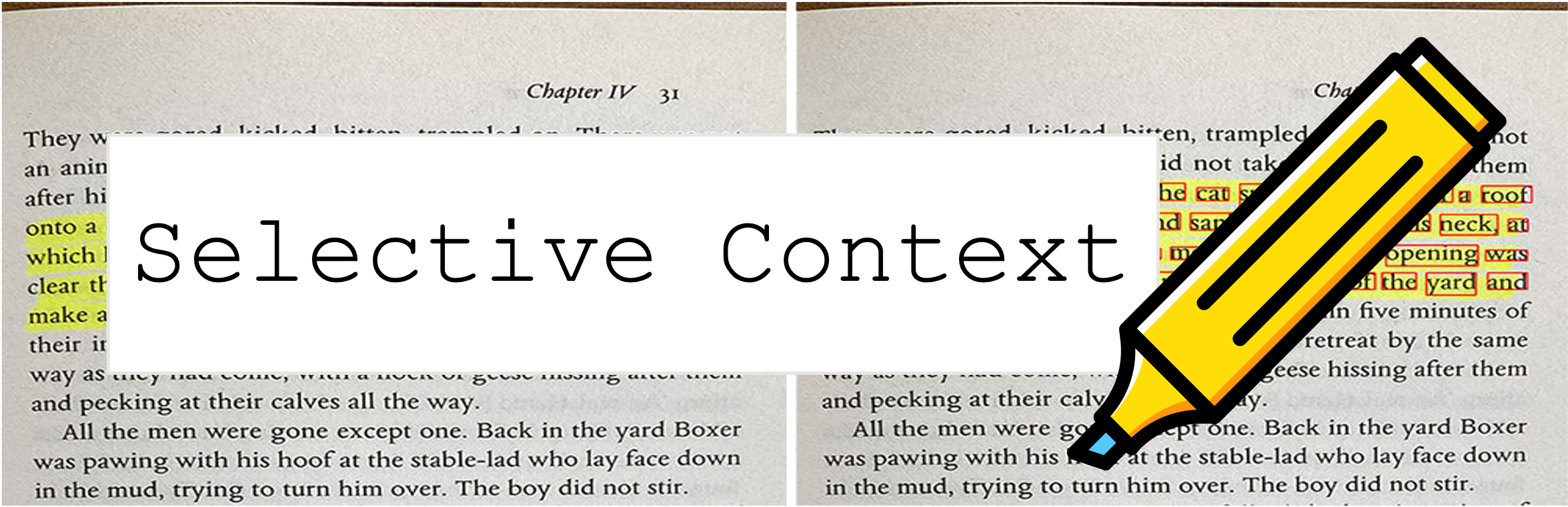

Селективный контекст сжимает вашу подсказку и контекст, чтобы позволить LLMS (например, CHATGPT) обрабатывать 2x больше контента. Это особенно полезно для борьбы с длинными документами и поддержания долгих разговоров, не ставя под угрозу их эффективность по различным задачам!

Этот репозиторий содержит код и данные для статьи: сжатие контекста для повышения эффективности вывода крупных языковых моделей.

9 октября 2023 года . Эта работа была принята для основного разбирательства EMNLP 2023 ? Бумажная ссылка выше - последняя версия конференции. Если вы ищете предыдущую версию Arxiv в статье: разблокировка контекста ограничения LLMS.

6 мая 2023 года . Попробуйте нашу демонстрацию в пространстве Huggingface.

Чтобы начать, следуйте этим шагам:

Установите selective-context через PYPI:

pip install selective-context

python -m spacy download en_core_web_sm

Если вы обрабатываете китайский язык, запустите python -m spacy download zh_core_web_sm .

Import SelectiveContext :

from selective_context import SelectiveContext

Сжатие вашей подсказки и контекста. context содержит сжатый контекст:

sc = SelectiveContext(model_type='gpt2', lang='en')

context, reduced_content = sc(text)

Вы также можете настроить коэффициент уменьшения:

context, reduced_content = sc(text, reduce_ratio = 0.5)

Если вы предпочитаете попробовать с веб -интерфейсом, попробуйте наше приложение Streamlit:

streamlit run app/app.py

Или прямо посетите наше пространство на обнимании Hub.

selective_context.py : демо для выполнения сокращения контекста с использованием выборочного контекста.context_manager.py : основной модуль для управления контекстом и реализации алгоритма селективного контекста.main.py : основной сценарий для проведения экспериментов и оценки эффективности селективного контекста.qa_manager.py : вспомогательный модуль для управления задачами ответа на вопросы во время экспериментов. Чтобы воспроизвести эксперименты из бумаги:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/datasets_dumps.zip

unzip datasets_dumps.zip

python main.py datasets_dumps/arxiv datasets_dumps/news datasets_dump/conversation <output_path_to_save_results> <num_articles> <HF_model_name_or_path>

Набор данных, используемый в бумаге, можно найти по адресу:

Наборы данных создаются самими собой, поэтому, если вам нужна цитирование, просто используйте цитирование этого инструмента.

Если у вас есть проблемы с доступом к HUB HuggingFace, загрузите данные через:

wget https://github.com/liyucheng09/Selective_Context/releases/download/v0.1.0rc1/data_dumps.zip

Если вы обнаружите этот репозиторий полезным или используйте наш метод в своем исследовании, пожалуйста, рассмотрите возможность ссылаться на нашу статью:

@misc{li2023compressing,

title={Compressing Context to Enhance Inference Efficiency of Large Language Models},

author={Yucheng Li and Bo Dong and Chenghua Lin and Frank Guerin},

year={2023},

eprint={2310.06201},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Предыдущая версия:

@misc{li2023unlocking,

title={Unlocking Context Constraints of LLMs: Enhancing Context Efficiency of LLMs with Self-Information-Based Content Filtering},

author={Yucheng Li},

year={2023},

eprint={2304.12102},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Этот проект лицензирован по лицензии MIT.