gpt2 ml

V1.0 Release

中文说明| ภาษาอังกฤษ

| ขนาด | ภาษา | คอร์ปัส | คำศัพท์ | Link1 | link2 | Sha256 |

|---|---|---|---|---|---|---|

| 1.5B params | ชาวจีน | ~ 30 กรัม | เบาะแส (โทเค็น 8021) | Google Drive | Baidu Pan (FFZ6) | E698CC97A7F5F706F84F58BB469D614E 51D3C0CE5F9AB9BF77E01E3FCB41D482 |

| 1.5B params | ชาวจีน | ~ 15g | เบิร์ต (21128 โทเค็น) | Google Drive | Baidu Pan (Q9VR) | 4A6E5124DF8DB7AC2BDD902E6191B807 A6983A7F5D09FB10CE011F9A073B183E |

คลังข้อมูลจาก Thucnews และ NLP_CHINESE_CORPUS

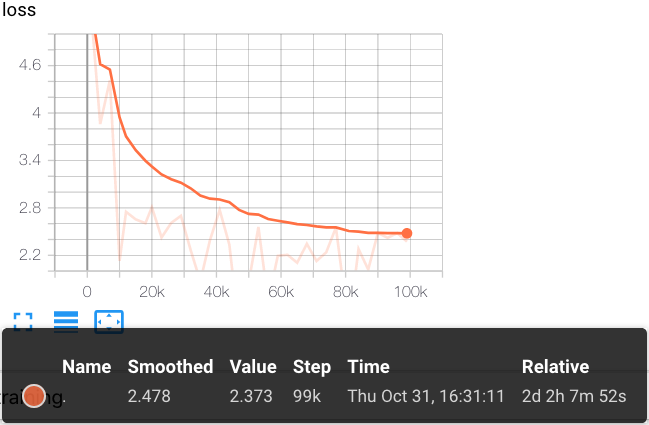

การใช้ Cloud TPU POD V3-256 เพื่อฝึกอบรมขั้นตอน 22W

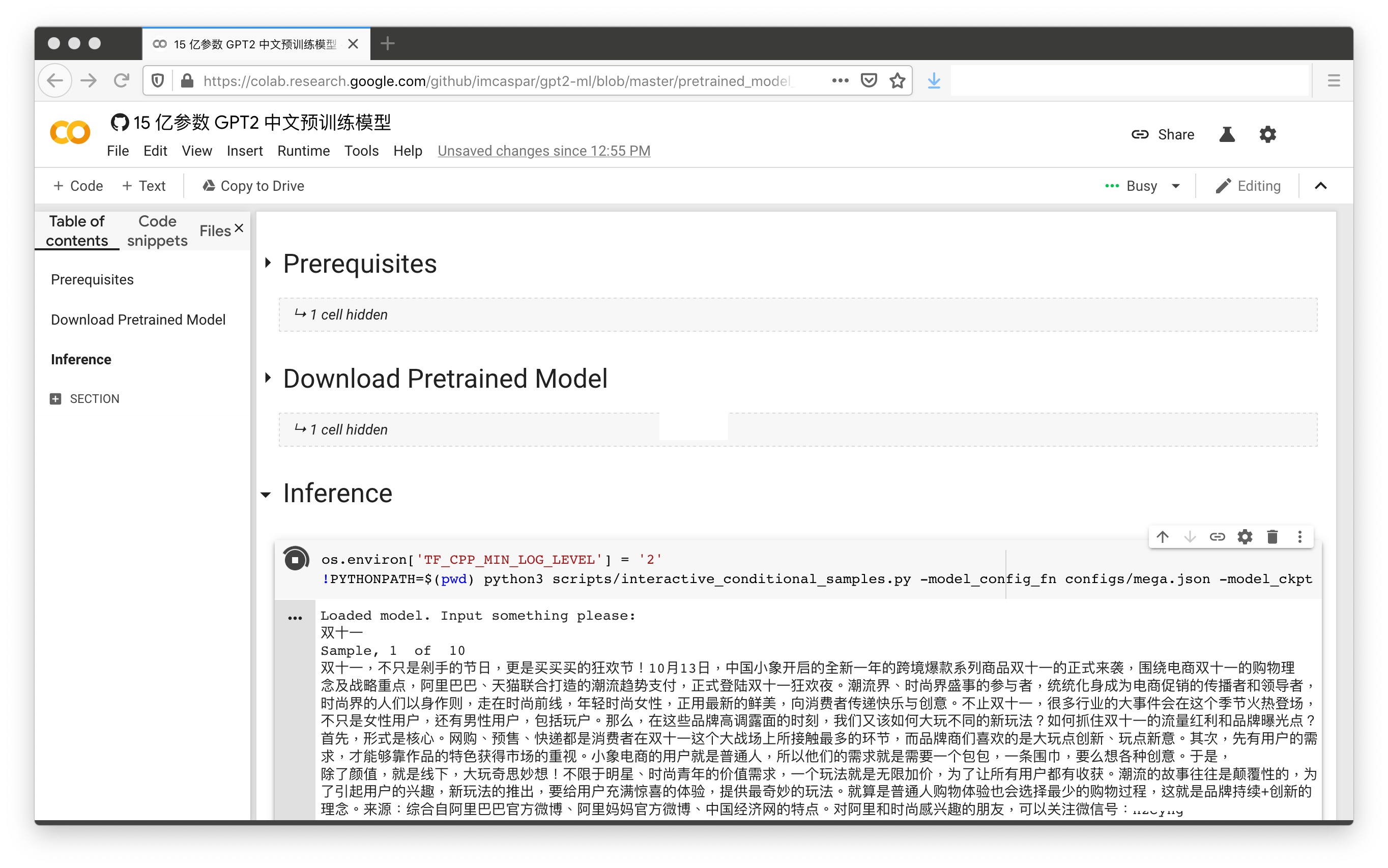

ด้วยการคลิกเพียง 2 ครั้ง (ไม่รวมถึงกระบวนการ Auth Auth) การสาธิตโมเดลภาษาจีน 1.5B ที่ได้รับการฝึกฝนพร้อม:

[โน๊ตบุ๊ค Colab]

เนื้อหาในพื้นที่เก็บข้อมูลนี้มีวัตถุประสงค์เพื่อการวิจัยเชิงวิชาการและเราไม่ได้ให้ข้อสังเกตข้อสรุปใด ๆ

@misc{GPT2-ML,

author = {Zhibo Zhang},

title = {GPT2-ML: GPT-2 for Multiple Languages},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/imcaspar/gpt2-ml}},

}

https://github.com/google-research/bert

https://github.com/rowanz/grover

การวิจัยสนับสนุนด้วยคลาวด์ TPU จาก Cloud Tensorflow Research Cloud (TFRC) ของ Google (TFRC)

[机器之心] 只需单击三次, 让中文 gpt-2 为你生成定制故事

[科学空间] 现在可以用 Keras 玩中文 GPT2 了