gpt2 ml

V1.0 Release

中文说明| Inglés

| Tamaño | Idioma | Cuerpo | Vocabulario | Enlace1 | Enlace2 | SHA256 |

|---|---|---|---|---|---|---|

| Parámetros 1.5b | Chino | ~ 30g | Pista (tokens 8021) | Google Drive | Baidu Pan (FFZ6) | E698CC97A7F5F706F84F58BB469D614E 51D3C0CE5F9AB9BF77E01E3FCB41D482 |

| Parámetros 1.5b | Chino | ~ 15g | Bert (tokens 21128) | Google Drive | Baidu Pan (Q9VR) | 4A6E5124DF8DB7AC2BDD902E6191B807 A6983A7F5D09FB10CE011F9A073B183E |

Corpus de Thucnews y NLP_Chinese_Corpus

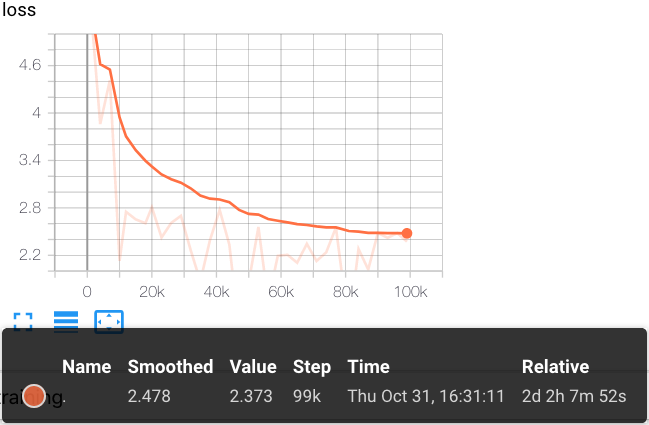

Uso de Cloud TPU POD V3-256 para entrenar 22W Pasos

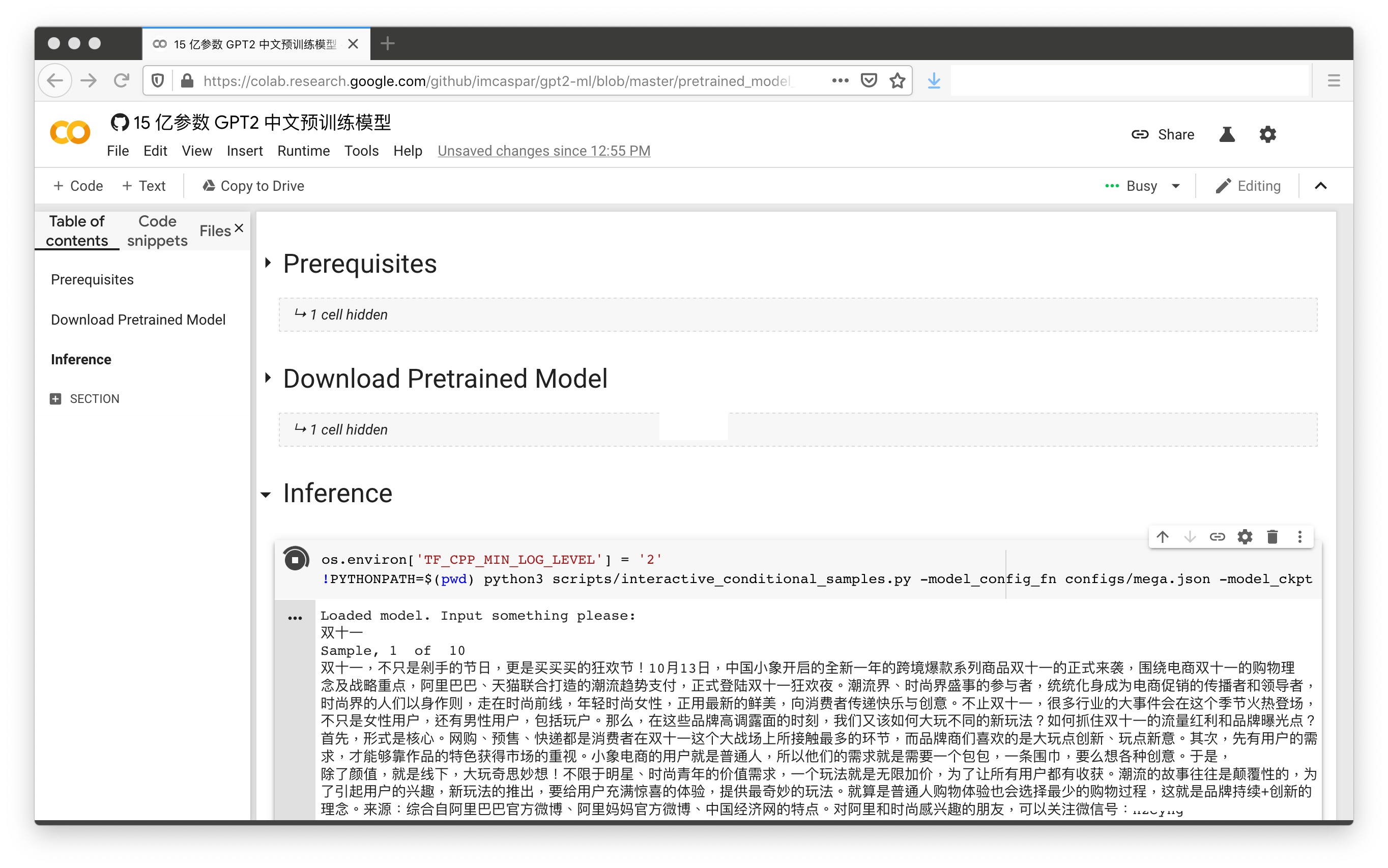

Con solo 2 clics (sin incluir el proceso de autenticación de Colab), la demostración del modelo chino previamente previamente previo al estado de 1.5B está listo para funcionar:

[Cuaderno de colab]

Los contenidos en este repositorio son para fines de investigación académica, y no proporcionamos ningún comentario concluyente.

@misc{GPT2-ML,

author = {Zhibo Zhang},

title = {GPT2-ML: GPT-2 for Multiple Languages},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/imcaspar/gpt2-ml}},

}

https://github.com/google-research/bert

https://github.com/rowanz/grover

Investigación apoyada con TPUS de Cloud de la Cloud de Investigación TensorFlow (TFRC) de Google de Google de Google de Google de Google de Google

[机器之心] 只需单击三次 , 让中文 GPT-2 为你生成定制故事

[科学空间] 现在可以用 keras 玩中文 gpt2 了