gpt2 ml

V1.0 Release

中文说明| 영어

| 크기 | 언어 | 신체 | 어휘 | 링크 1 | 링크 2 | SHA256 |

|---|---|---|---|---|---|---|

| 1.5B 매개 변수 | 중국인 | ~ 30g | 단서 (8021 토큰) | 구글 드라이브 | 바이두 팬 (FFZ6) | E698CC97A7F5F706F84F58BB469D614E 51D3C0CE5F9AB9BF77E01E3FCB41D482 |

| 1.5B 매개 변수 | 중국인 | ~ 15g | 버트 (21128 토큰) | 구글 드라이브 | 바이두 팬 (Q9VR) | 4A6E5124DF8DB7AC2BDD902E6191B807 A6983A7F5D09FB10CE011F9A073B183E |

Thucnews 및 NLP_CHINESE_CORPUS의 코퍼스

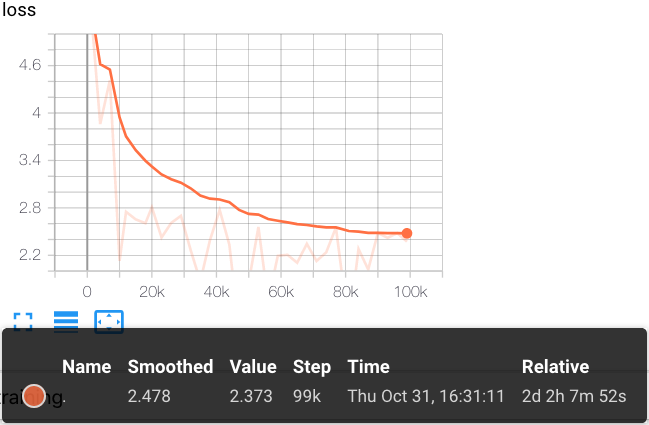

클라우드 TPU POD v3-256을 사용하여 22W 단계를 훈련시킵니다

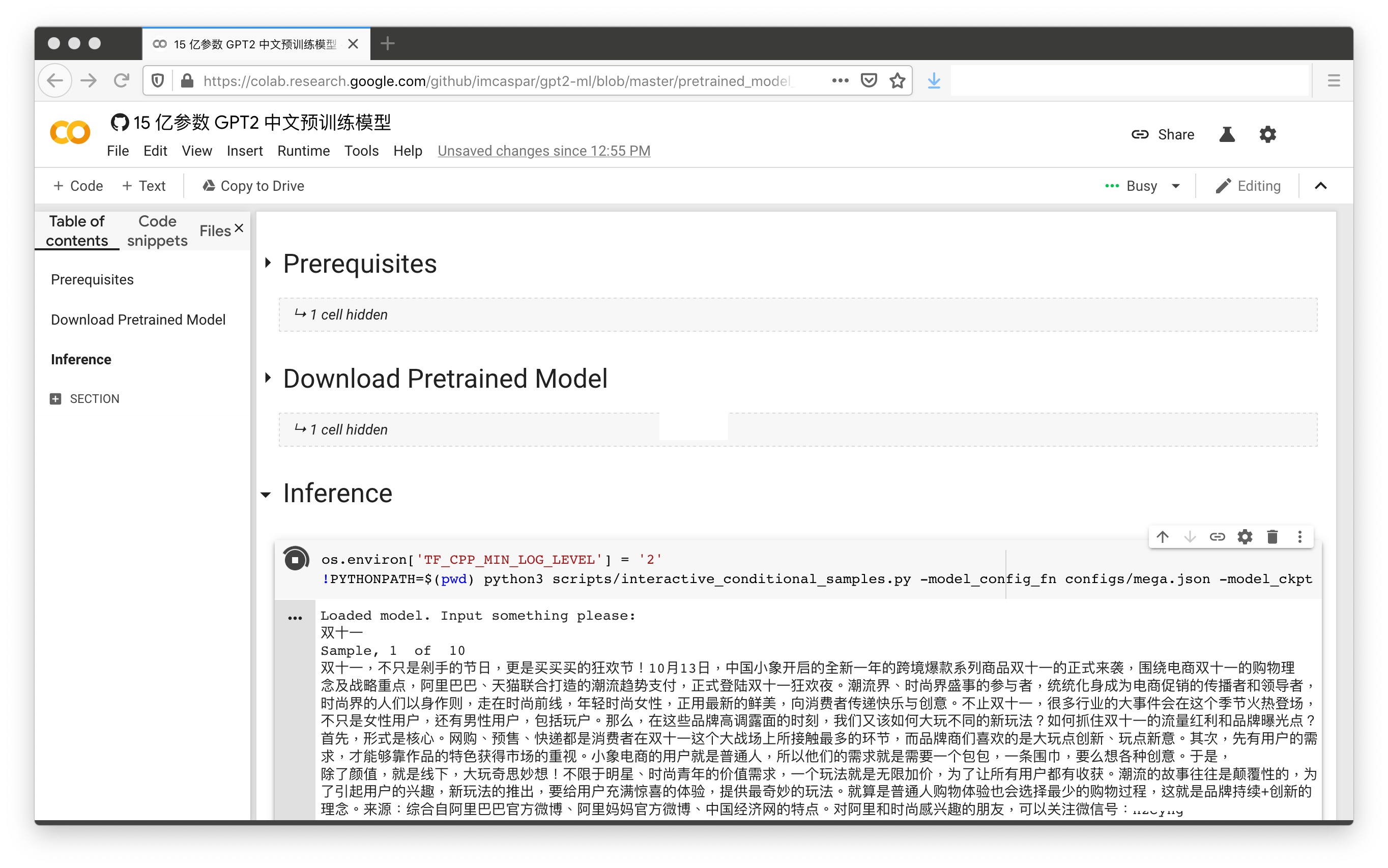

1.5B 사전 REATERED 중국 모델 데모는 2 번의 클릭 (Colab Auth Process 포함)만으로 다음과 같습니다.

[Colab 노트북]

이 저장소의 내용은 학문적 연구 목적을위한 것이며, 우리는 결정적인 언급을 제공하지 않습니다.

@misc{GPT2-ML,

author = {Zhibo Zhang},

title = {GPT2-ML: GPT-2 for Multiple Languages},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/imcaspar/gpt2-ml}},

}

https://github.com/google-research/bert

https://github.com/rowanz/grover

Google의 Tensorflow Research Cloud (TFRC)의 Cloud TPU로 지원되는 연구

[,] 只需单击三次 只需单击三次, 让中文 gpt-2 为你生成定制故事

[er] 现在可以用 keras 玩中文 gpt2 了