Английский | 简体中文 |

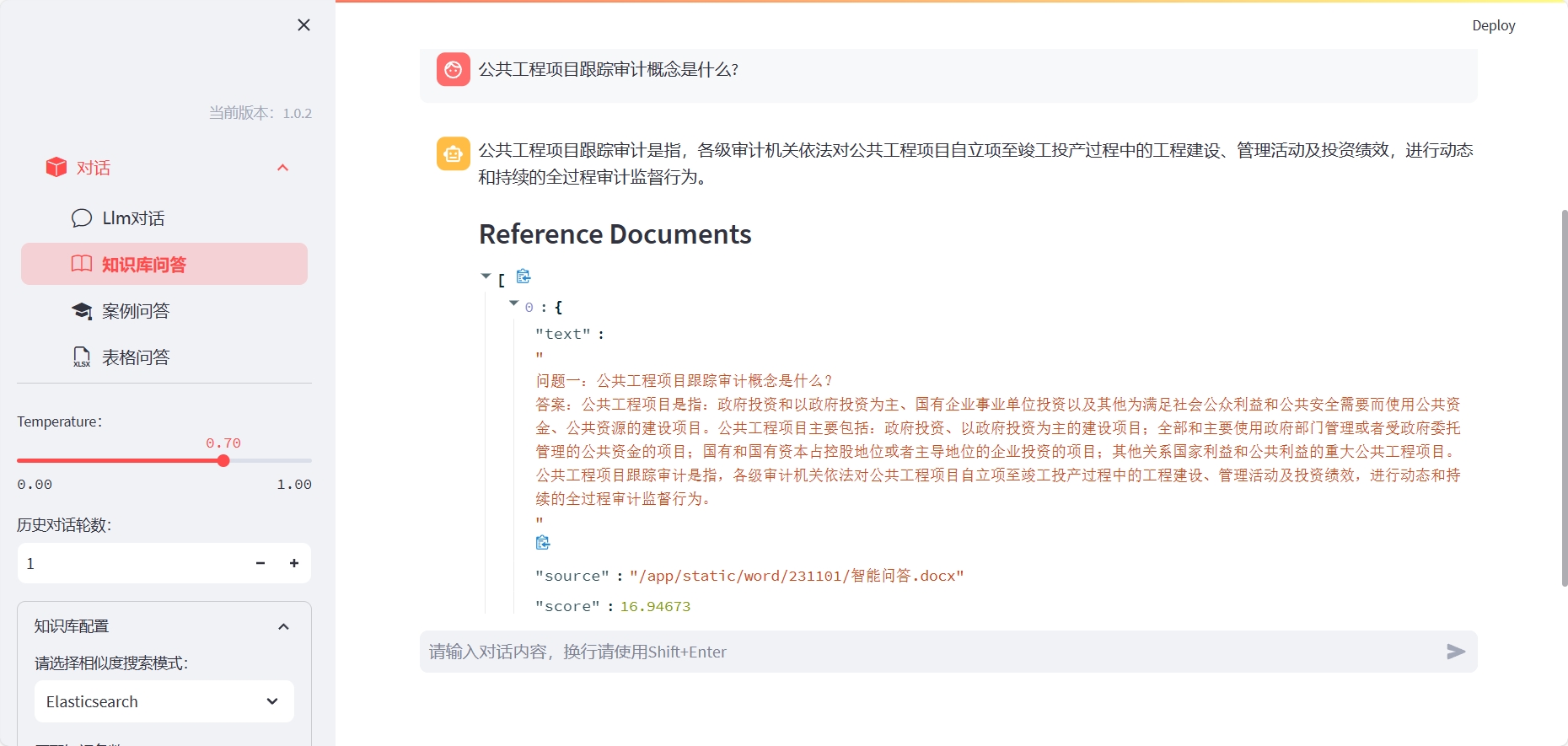

LLM-Workbench-это инструментарий для обучения, точной настройки и визуализации языковых моделей с использованием потоковой связи. Это очень подходит для исследователей и энтузиастов искусственного интеллекта.

Установите Elasticsearch (пожалуйста, откройте соответствующий порт сервера в соответствии с файлом Docker-Compose или настраивайте его):

cd docker/es

docker-compose up -d

Чтобы использовать вопросы и ответы базы знаний, вам необходимо построить соответствующий индекс:

Метод первый: вы можете установить LLM-Workbench со следующей командой:

cd LLM-Workbench

docker-compose up -d

Для случая использования Q & A Q & A вам необходимо войти в контейнер и указать интерпретатор ядра:

ipython kernel install --name llm --user

Где LLM соответствует названию среды Conda.

Метод второй: После установки LLM-WorkBench вы можете начать его со следующей команды:

pip install -r requirements.txt

streamlit run chat-box.py

Затем вы можете открыть отображаемый URL в своем браузере, чтобы начать использовать LLM-Workbench.

Мы приветствуем любую форму вклада! Если у вас есть какие -либо вопросы или предложения, не стесняйтесь поднимать их на GitHub.

LLM-Workbench выпускается по лицензии MIT. Для получения более подробной информации см. Файл лицензии.

Если у вас есть какие -либо вопросы или предложения, не стесняйтесь спрашивать нас по электронной почте или GitHub.