Englisch | 简体中文 |

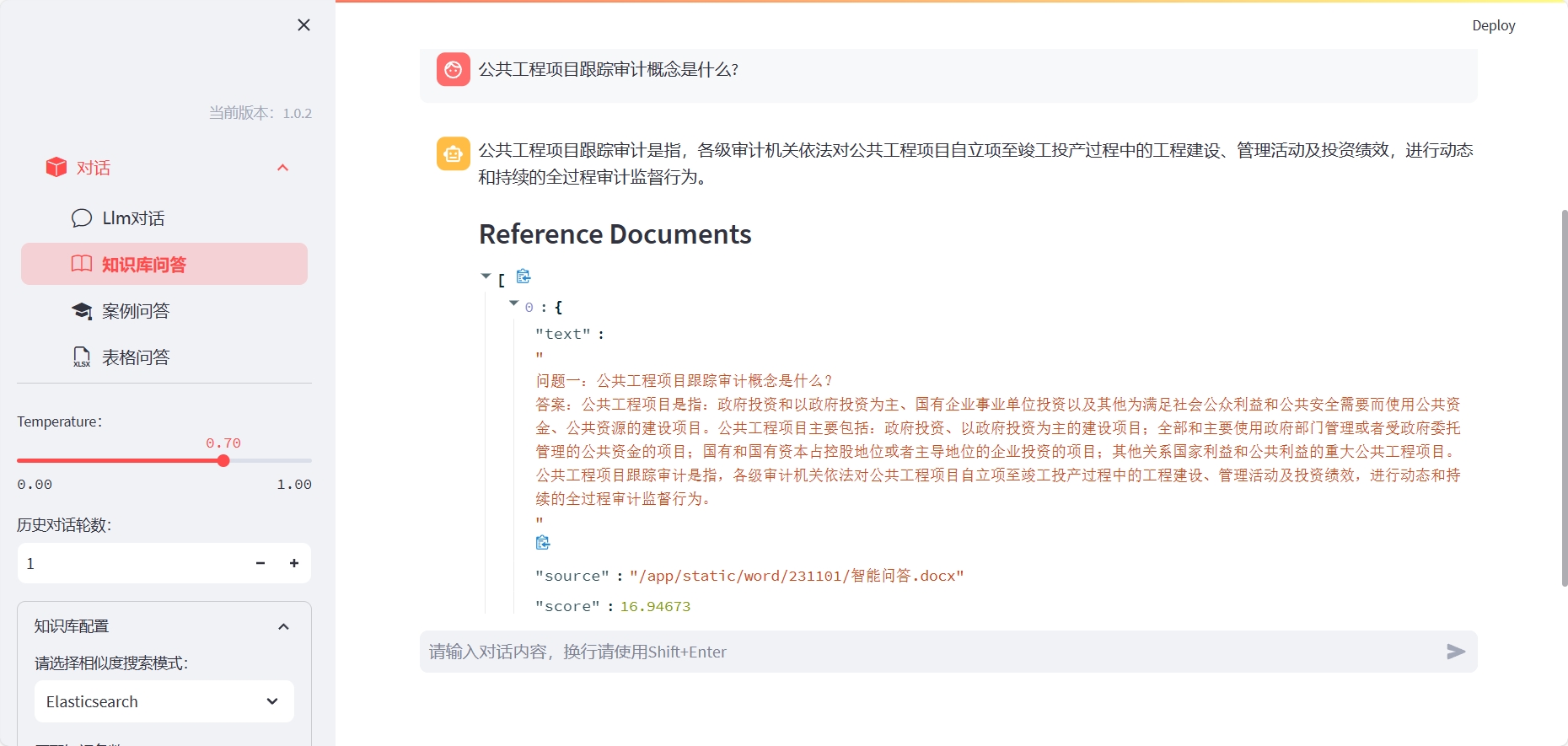

LLM-Workbench ist ein Toolkit für das Training, die Feinabstimmung und die Visualisierung von Sprachmodellen mithilfe von Streamlit. Es ist sehr geeignet für Forscher und KI -Enthusiasten.

Installieren Sie ElasticSearch (bitte öffnen Sie den entsprechenden Serverport gemäß der Docker-Compose-Datei oder passen Sie ihn an):

cd docker/es

docker-compose up -d

Um die Q & A zu verwenden, müssen Sie den entsprechenden Index erstellen:

Methode 1: Sie können LLM-Workbench mit dem folgenden Befehl installieren:

cd LLM-Workbench

docker-compose up -d

Für die Verwendung von Excel -Tabellen -Q & A müssen Sie den Container eingeben und den Kernel -Interpreter angeben:

ipython kernel install --name llm --user

Wo, LLM entspricht dem Namen der Konda -Umgebungsnamen.

Methode zwei: Nach der Installation von LLM-Workbench können Sie es mit dem folgenden Befehl starten:

pip install -r requirements.txt

streamlit run chat-box.py

Dann können Sie die angezeigte URL in Ihrem Browser öffnen, um mit LLM-Workbench zu beginnen.

Wir begrüßen jede Form des Beitrags! Wenn Sie Fragen oder Vorschläge haben, können Sie sie gerne auf GitHub erheben.

LLM-Workbench wird unter der MIT-Lizenz veröffentlicht. Weitere Informationen finden Sie in der Lizenzdatei.

Wenn Sie Fragen oder Vorschläge haben, können Sie uns gerne per E -Mail oder GitHub fragen.