Inglés | 简体中文 |

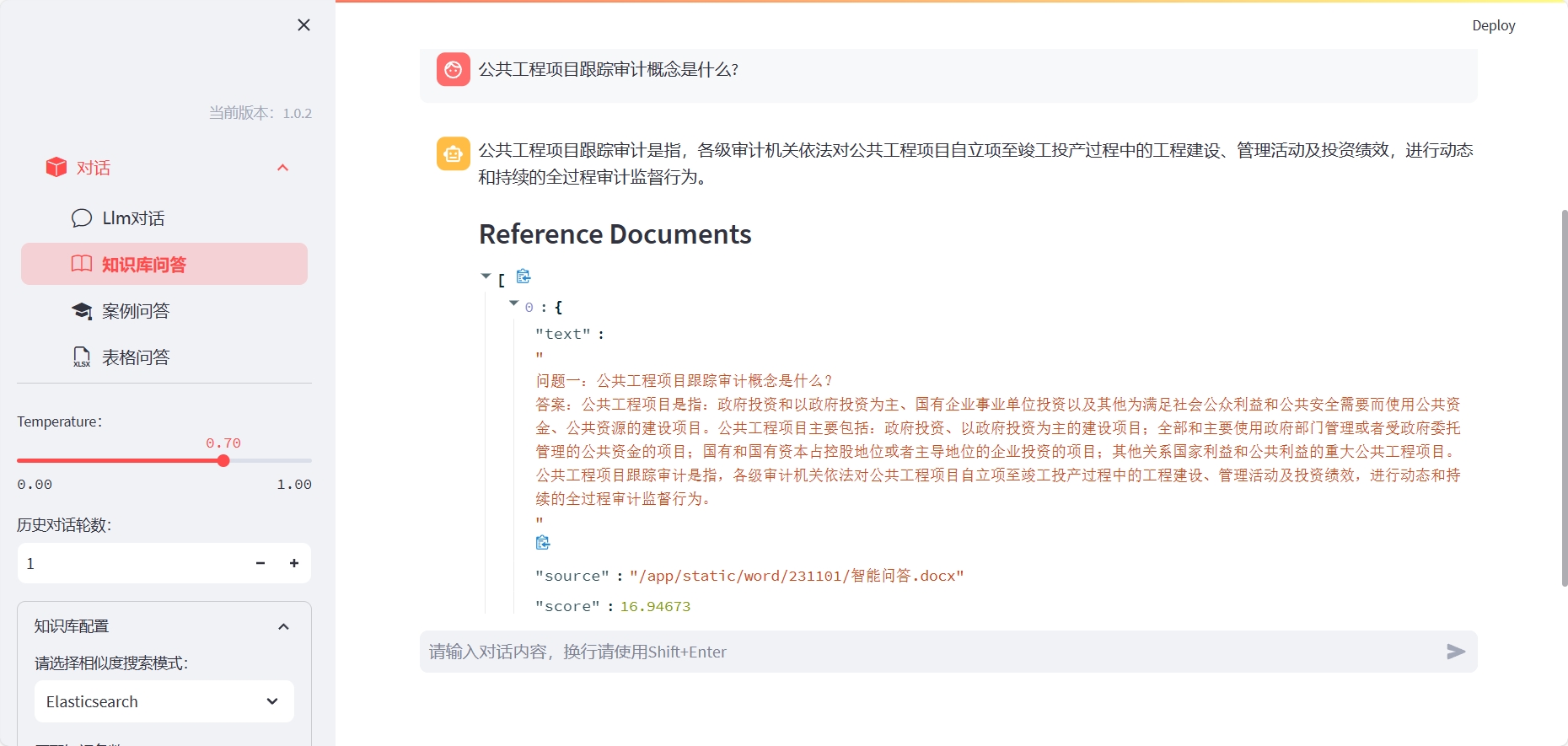

LLM-Workbench es un conjunto de herramientas para capacitar, ajustar y visualizar modelos de lenguaje utilizando Streamlit. Es muy adecuado para investigadores y entusiastas de la IA.

Instale ElasticSearch (abra el puerto del servidor correspondiente de acuerdo con el archivo Docker-compuesto o lo personalice):

cd docker/es

docker-compose up -d

Para usar las preguntas y respuestas de la base de conocimiento, debe construir el índice correspondiente:

Método uno: puede instalar LLM-Workbench con el siguiente comando:

cd LLM-Workbench

docker-compose up -d

Para el caso de usar preguntas y respuestas de la tabla de Excel, debe ingresar el contenedor y especificar el intérprete del núcleo:

ipython kernel install --name llm --user

Donde, LLM corresponde al nombre del entorno de conda.

Método dos: después de instalar LLM-Workbench, puede iniciarlo con el siguiente comando:

pip install -r requirements.txt

streamlit run chat-box.py

Luego, puede abrir la URL mostrada en su navegador para comenzar a usar LLM-Workbench.

¡Agradecemos cualquier forma de contribución! Si tiene alguna pregunta o sugerencia, no dude en plantearlas en Github.

LLM-Workbench se publica bajo la licencia MIT. Para obtener más detalles, consulte el archivo de licencia.

Si tiene alguna pregunta o sugerencia, no dude en preguntarnos por correo electrónico o GitHub.