Anglais | 简体中文 |

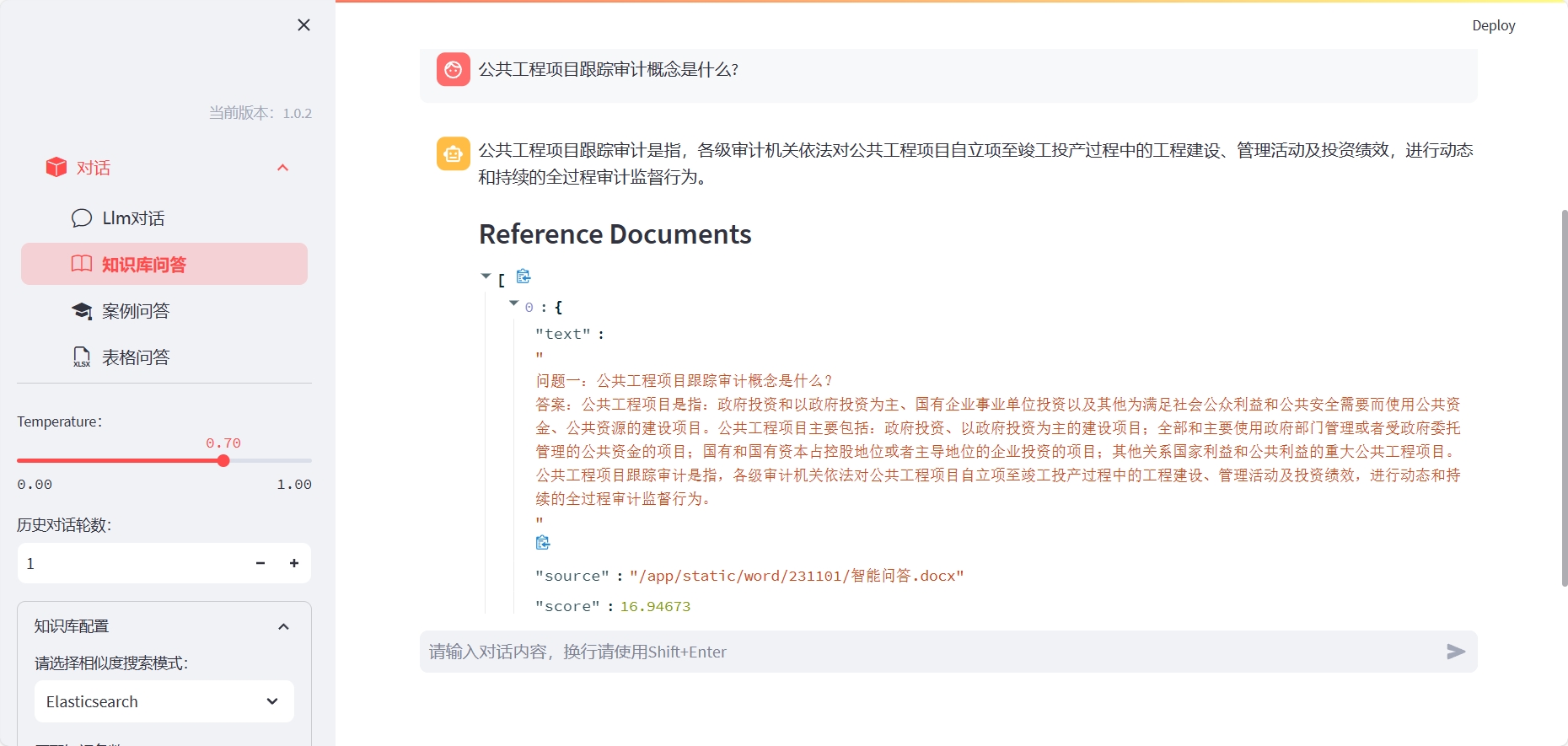

LLM-Workbench est une boîte à outils pour la formation, le réglage fin et la visualisation des modèles de langage à l'aide de rationalisation. Il est très adapté aux chercheurs et aux amateurs d'IA.

Installez ElasticSearch (veuillez ouvrir le port de serveur correspondant en fonction du fichier Docker-Compose, ou personnalisez-le):

cd docker/es

docker-compose up -d

Pour utiliser la Q&R de la base de connaissances, vous devez créer l'index correspondant:

Méthode One: Vous pouvez installer LLM-WorkBench avec la commande suivante:

cd LLM-Workbench

docker-compose up -d

Pour le cas d'utilisation de la tablette Q&R de la table Excel, vous devez saisir le conteneur et spécifier l'interprète de noyau:

ipython kernel install --name llm --user

Où, LLM correspond au nom de l'environnement conda.

Méthode deux: Après avoir installé LLM-Workbench, vous pouvez le démarrer avec la commande suivante:

pip install -r requirements.txt

streamlit run chat-box.py

Ensuite, vous pouvez ouvrir l'URL affichée dans votre navigateur pour commencer à utiliser LLM-Workbench.

Nous accueillons toute forme de contribution! Si vous avez des questions ou des suggestions, n'hésitez pas à les soulever sur Github.

LLM-Workbench est libéré sous la licence MIT. Pour plus de détails, veuillez consulter le fichier de licence.

Si vous avez des questions ou des suggestions, n'hésitez pas à nous poser par e-mail ou GitHub.