Inglês | 简体中文 |

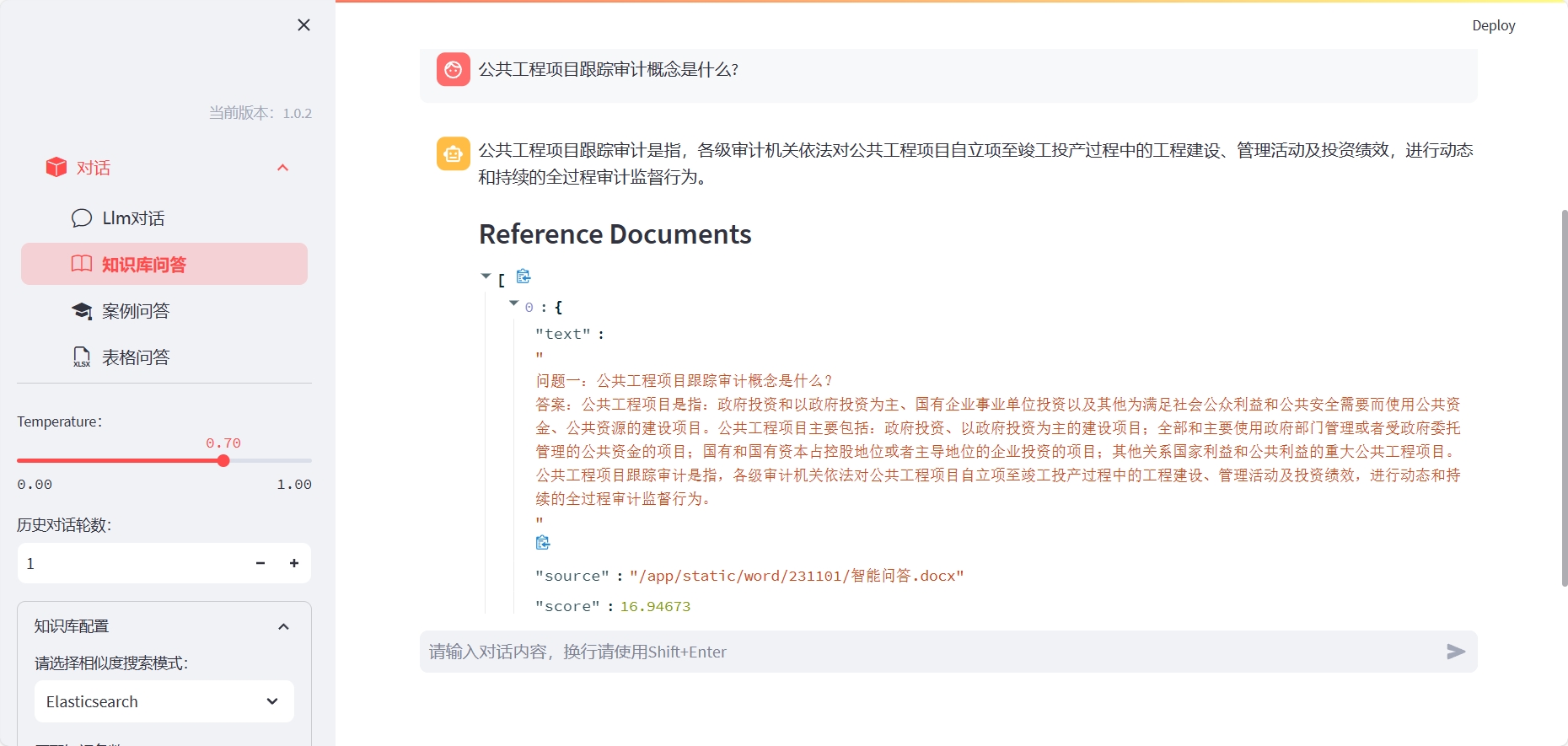

O LLM-WorkBench é um kit de ferramentas para treinamento, ajuste fino e visualizando modelos de linguagem usando o streamlit. É muito adequado para pesquisadores e entusiastas da IA.

Instale o Elasticsearch (abra a porta do servidor correspondente de acordo com o arquivo Docker-Compose ou personalize-o):

cd docker/es

docker-compose up -d

Para usar as perguntas e respostas da Base de Conhecimento, você precisa construir o índice correspondente:

Método um: você pode instalar o LLM-WorkBench com o seguinte comando:

cd LLM-Workbench

docker-compose up -d

Para o caso de usar perguntas e respostas da tabela do Excel, você precisa entrar no contêiner e especificar o intérprete do kernel:

ipython kernel install --name llm --user

Onde, LLM corresponde ao nome do ambiente do ANACA.

Método dois: depois de instalar o LLM-WorkBench, você pode iniciá-lo com o seguinte comando:

pip install -r requirements.txt

streamlit run chat-box.py

Em seguida, você pode abrir o URL exibido no seu navegador para começar a usar o LLM-WorkBench.

Congratulamo -nos com qualquer forma de contribuição! Se você tiver alguma dúvida ou sugestão, sinta -se à vontade para criá -las no Github.

O LLM-Workbench é liberado sob a licença do MIT. Para mais detalhes, consulte o arquivo de licença.

Se você tiver alguma dúvida ou sugestão, sinta -se à vontade para nos perguntar por e -mail ou github.