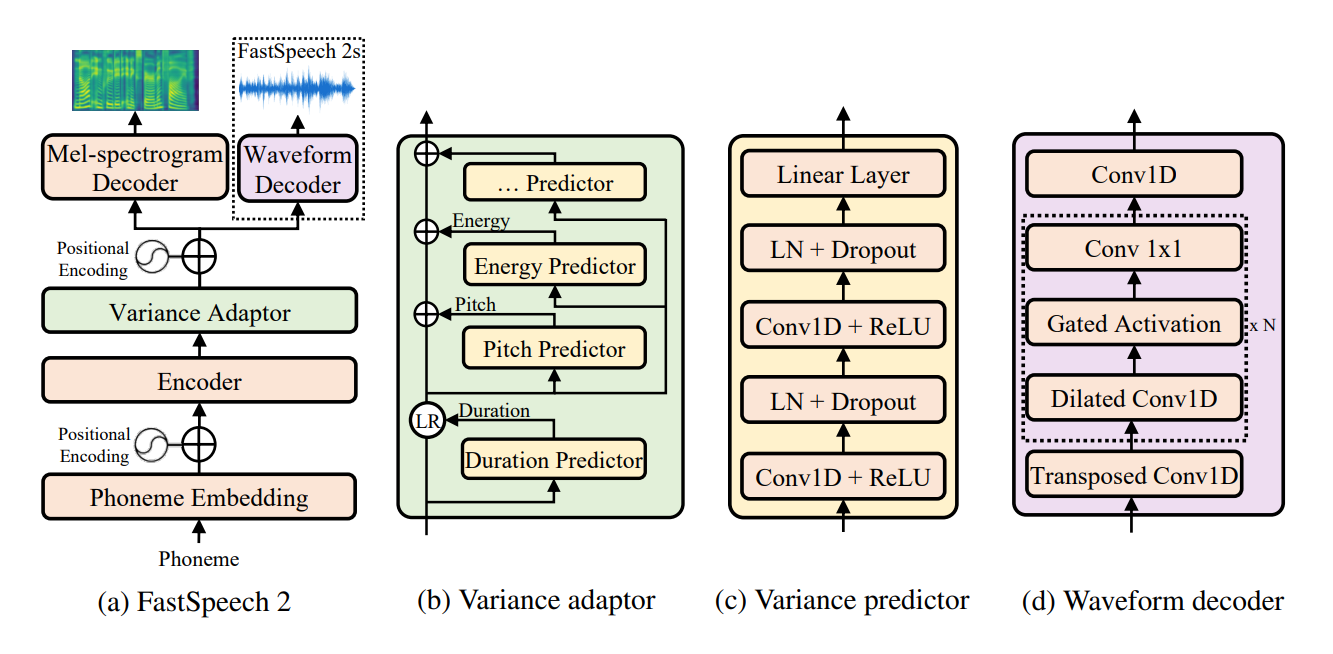

Неофициальная внедрение Pytorch of Fastspeech 2: Быстрый и высококачественный сквозной текст к речи . Этот репо использует реализацию Fastspeech ESPnet в качестве базы. В этой реализации я попытался воспроизвести точные детали бумаги, но все же некоторая модификация, необходимая для лучшей модели, это открыто для любого предложения и улучшения. В этом репо используется предварительная обработка NVIDIA Tacotron 2 для предварительной обработки аудио и Мелгана в качестве Vocoder.

Весь код, написанный в Python 3.6.2 .

Перед установкой Pytorch, пожалуйста, проверьте свою версию CUDA, выполнив следующую команду:

nvcc --version

pip install torch torchvision

В этом репо я использовал pytorch 1.6.0 для функции torch.bucketize , которая не присутствует в предыдущих версиях Pytorch.

pip install -r requirements.txt

tensorboard version 1.14.0 Seperatly с поддерживаемым tensorflow (1.14.0) Папка filelists содержит MFA (MotReal Force Aligner), обработанные файлы набора данных LJSPEECH, поэтому вам не нужно выравнивать текст с аудио (для продолжительности извлечения) для набора данных LJSPEECH. Для другого набора данных следуйте инструкции здесь. Для другого предварительного обработки выполнения следующей команды:

python .nvidia_preprocessing.py -d path_of_wavs

За поиск мин и максимума F0 и энергии

python .compute_statistics.py

Обновите следующее в hparams.py Min и Max of F0 и Energy

p_min = Min F0/pitch

p_max = Max F0

e_min = Min energy

e_max = Max energy

python train_fastspeech.py --outdir etc -c configs/default.yaml -n "name"

В настоящее время поддерживается только синтез на основе фонемы.

python .inference.py -c .configsdefault.yaml -p .checkpointsfirst_1ts_version2_fastspeech_fe9a2c7_7k_steps.pyt --out output --text "ModuleList can be indexed like a regular Python list but modules it contains are properly registered."

python export_torchscript.py -c configs/default.yaml -n fastspeech_scrip --outdir etc

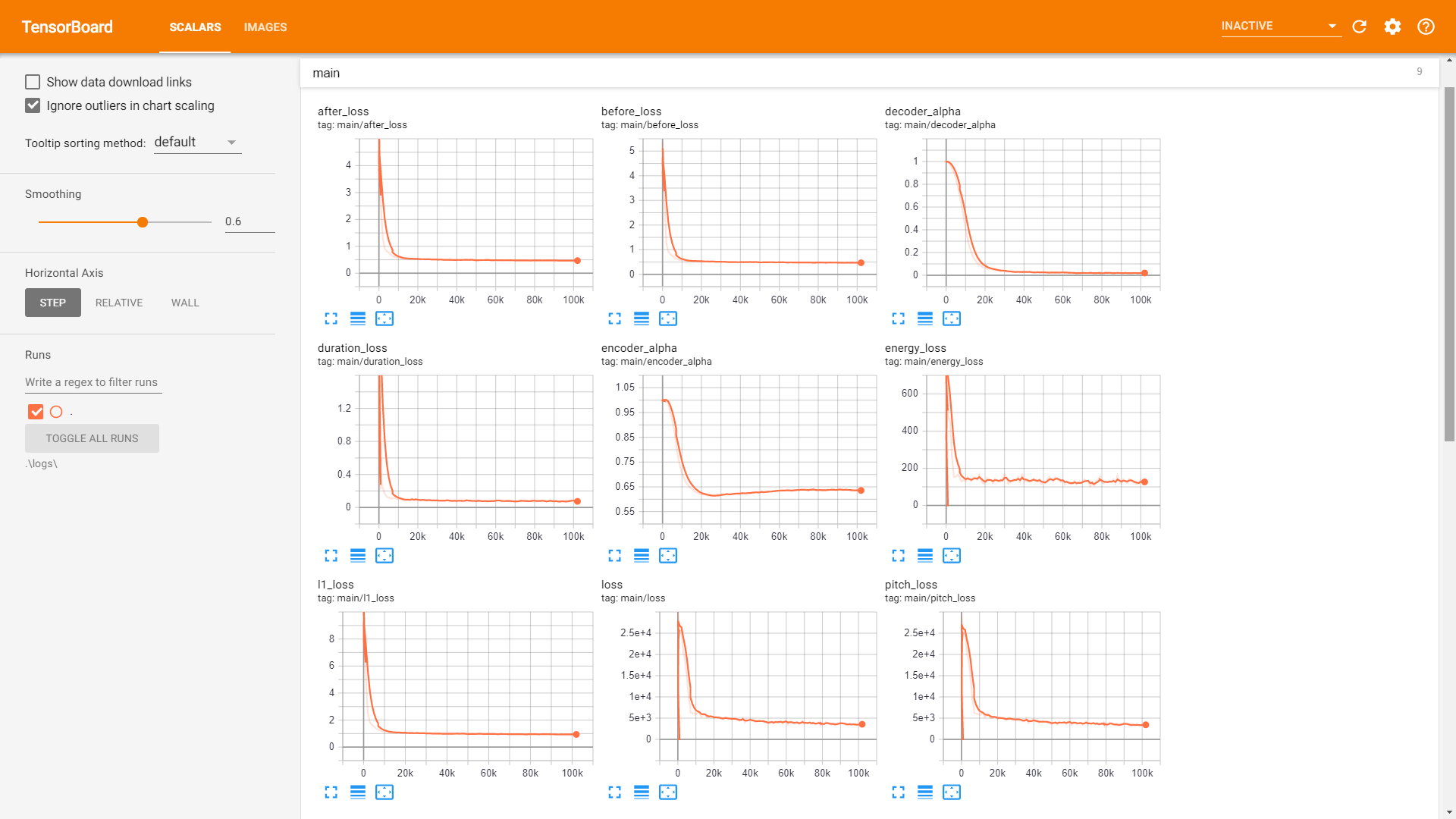

sample . Обучение :

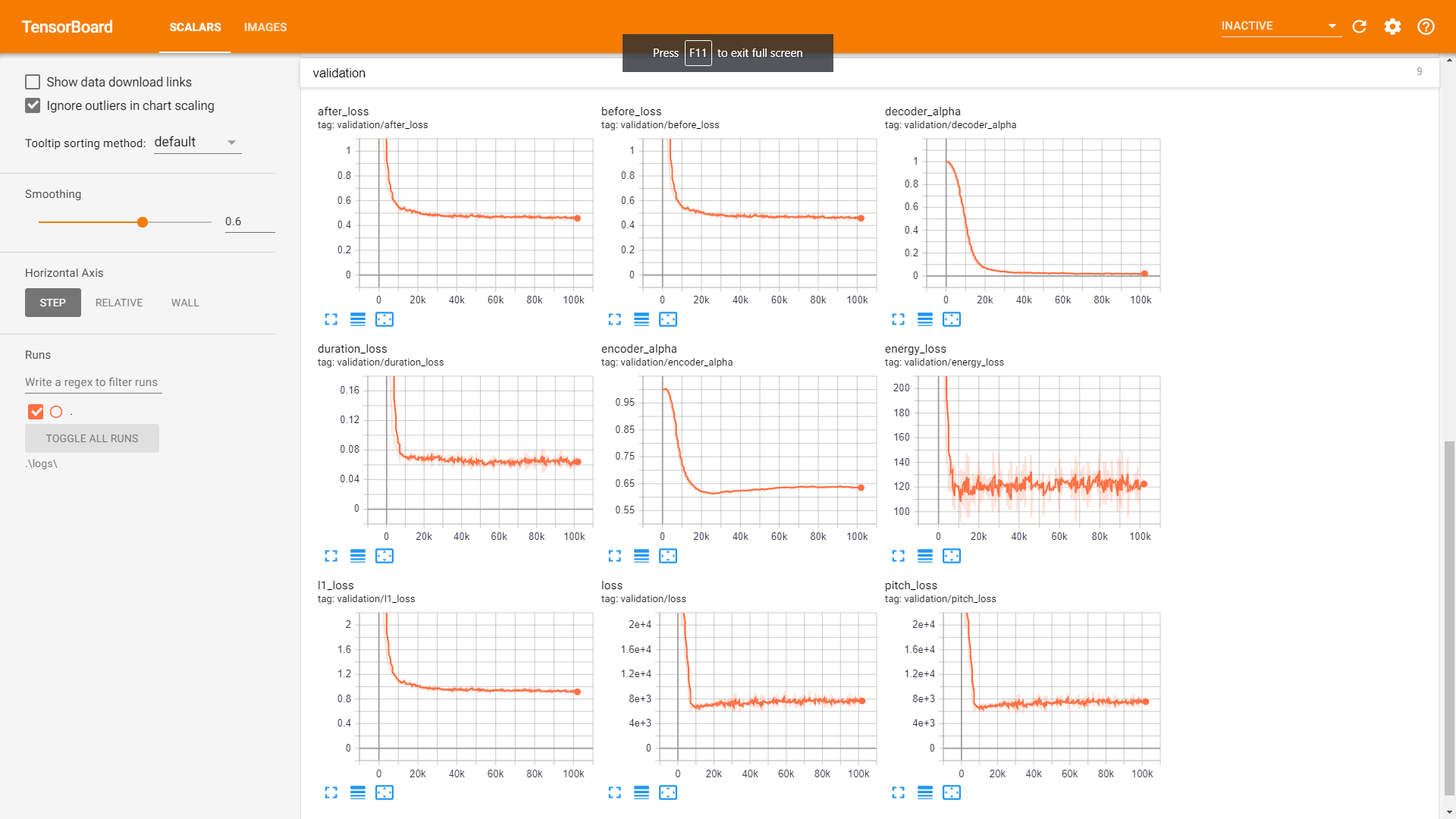

Валидация:

Postnet для лучшего качества звука.