FastSpeech2

1.0.0

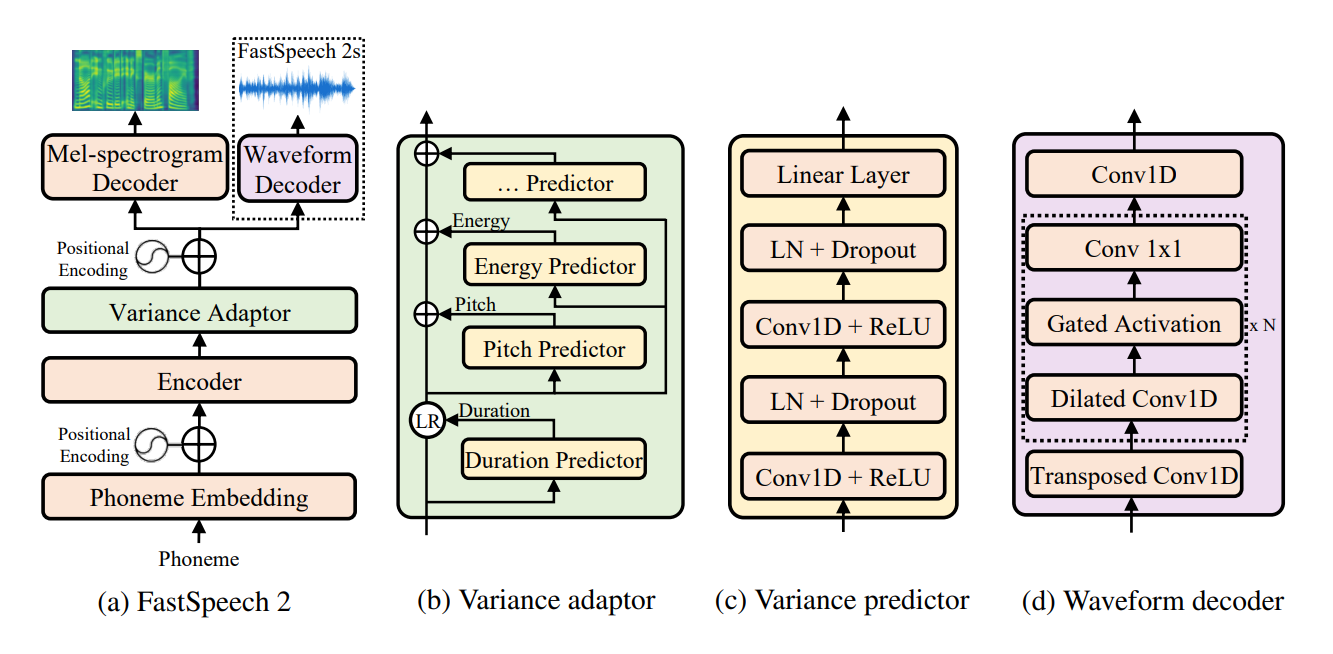

FastSpeech 2의 비공식 Pytorch 구현 : FAST 및 고품질 엔드 투 엔드-엔드-엔드-연설 . 이 repo는 ESPNET의 FastSpeech 구현을 기본으로 사용합니다. 이 구현에서 나는 정확한 용지 세부 사항을 복제하려고 시도했지만 더 나은 모델을 위해서는 여전히 수정이 필요했지만,이 repo는 제안과 개선을 위해 열립니다. 이 repo는 오디오 사전 프로세싱 및 멜간을 보코더로 사용하기 위해 NVIDIA의 Tacotron 2 Preprocessing을 사용합니다.

Python 3.6.2 로 작성된 모든 코드.

Pytorch를 설치하기 전에 다음 명령을 실행하여 Cuda 버전을 확인하십시오 :

nvcc --version

pip install torch torchvision

이 repo에서 나는 이전 버전의 Pytorch에 존재하지 않는 torch.bucketize 기능에 Pytorch 1.6.0을 사용했습니다.

pip install -r requirements.txt

tensorboard version 1.14.0 지원되는 tensorflow (1.14.0) 사용하여 Seperatly filelists 폴더에는 MFA (Motreal Force Aligner) 가공 된 LJSpeech 데이터 세트 파일이 포함되어 있으므로 LJSpeech DataSet의 오디오 (추출 기간 동안)와 텍스트를 정렬 할 필요가 없습니다. 다른 데이터 세트는 여기에서 지침을 따르십시오. 다음 명령을 따르는 다른 사전 처리 실행 :

python .nvidia_preprocessing.py -d path_of_wavs

F0의 최소와 최대 및 에너지를 찾기 위해

python .compute_statistics.py

최소 및 최대 F0 및 Energy의 hparams.py 에서 다음을 업데이트하십시오.

p_min = Min F0/pitch

p_max = Max F0

e_min = Min energy

e_max = Max energy

python train_fastspeech.py --outdir etc -c configs/default.yaml -n "name"

현재 Phonemes 기반 합성 만 지원됩니다.

python .inference.py -c .configsdefault.yaml -p .checkpointsfirst_1ts_version2_fastspeech_fe9a2c7_7k_steps.pyt --out output --text "ModuleList can be indexed like a regular Python list but modules it contains are properly registered."

python export_torchscript.py -c configs/default.yaml -n fastspeech_scrip --outdir etc

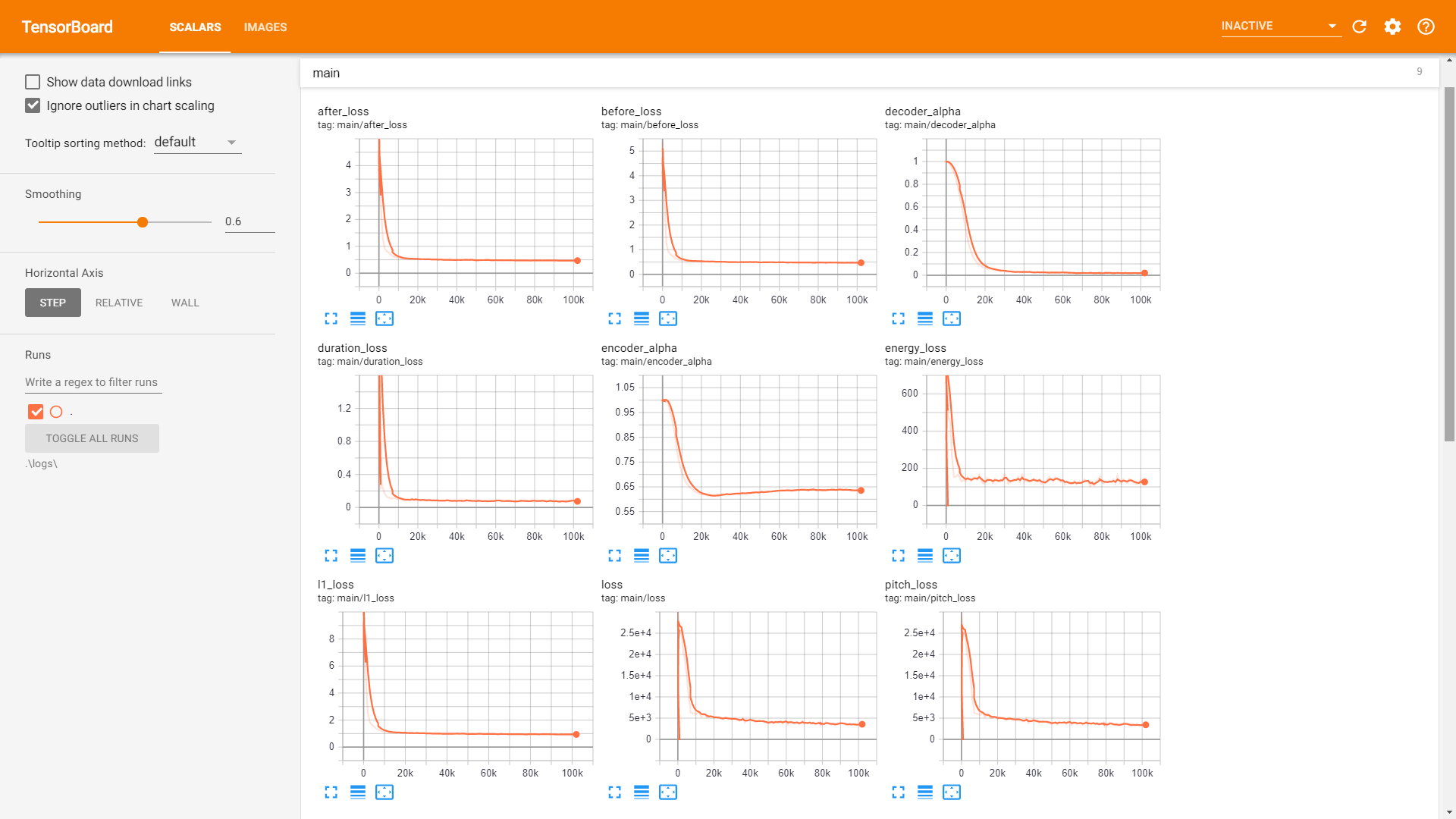

sample 폴더를 확인하십시오. 훈련 :

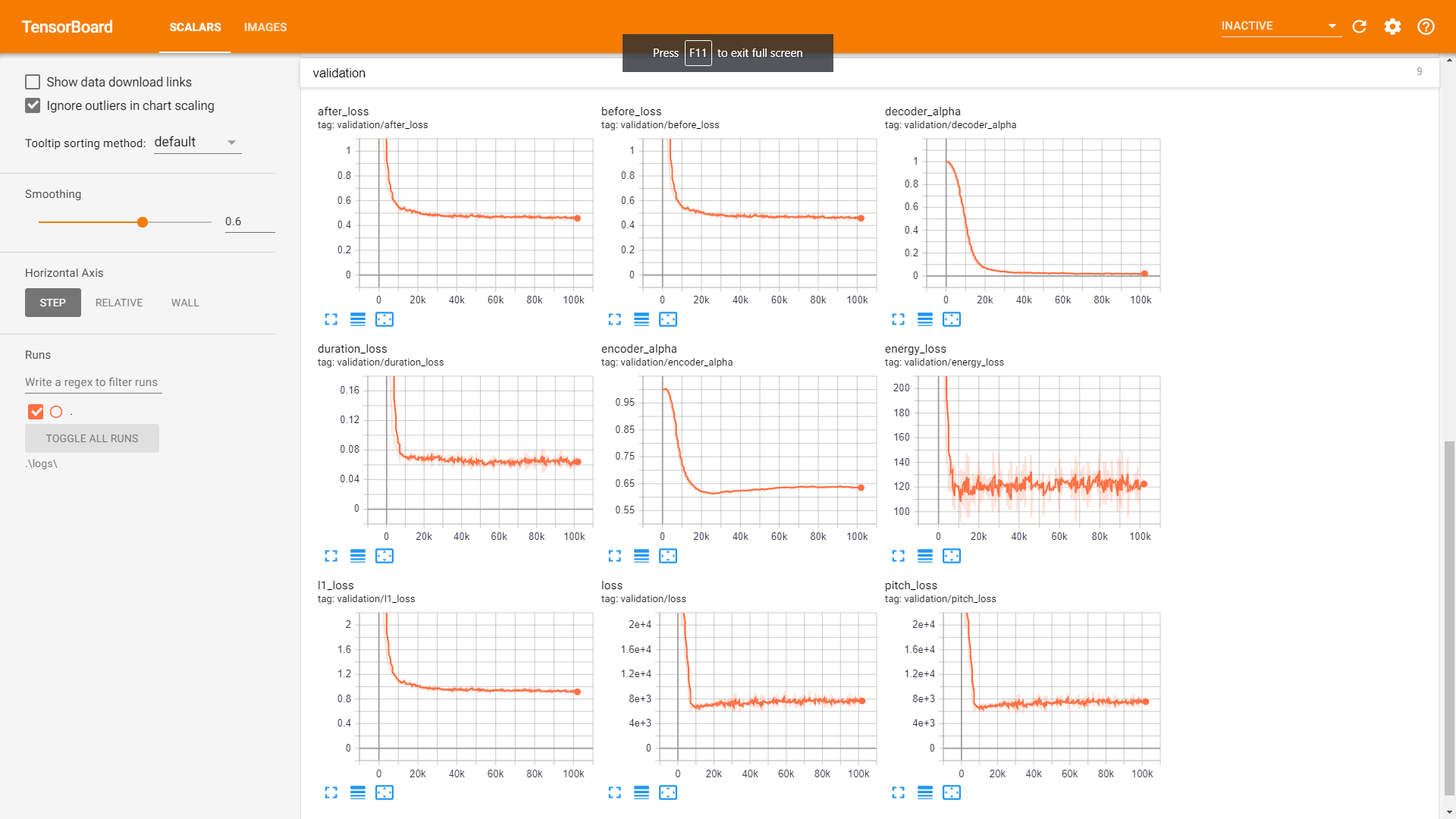

검증 :

Postnet 사용합니다.