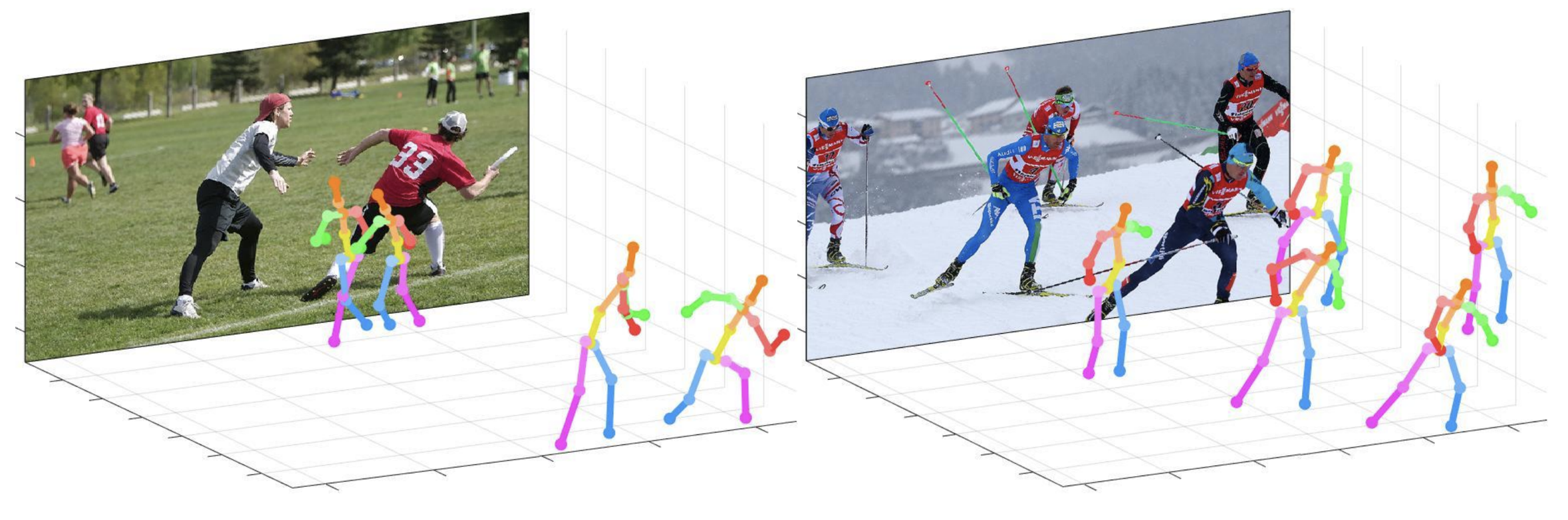

Это репо является официальной реализацией Pytorch присматривающего на расстояние камеры для 3D-оценки позы с многопользовательским человеком из одного изображения RGB (ICCV 2019) . Он содержит Posenet Part.

Что дает этот репо:

Этот код тестируется в соответствии с Ubuntu 16.04, Cuda 9.0, Cudnn 7.1 Среда с двумя графическими процессорами NVIDIA 1080TI.

Версия Python 3.6.5 с Anaconda 3 используется для разработки.

Вы можете попробовать быстрое демонстрацию в demo Polder.

input.jpg и предварительно обученный снимок в demo папке.bbox_list здесь.root_depth_list здесь.python demo.py --gpu 0 --test_epoch 24 если вы хотите запустить GPU 0.output_pose_2d.jpg и новое окно, которое показывает 3D -позу. ${POSE_ROOT} описывается, как ниже.

${POSE_ROOT}

|-- data

|-- demo

|-- common

|-- main

|-- tool

|-- vis

`-- output

data содержат коды загрузки данных и мягкие ссылки на изображения и каталоги аннотаций.demo содержит демонстрационные коды.common содержит коды ядра для трехмерной системы оценки позы.main содержит коды высокого уровня для обучения или тестирования сети.tool содержит коды предварительной обработки данных. Вам не нужно запускать этот код. Я предоставляю предварительно обработанные данные ниже.vis содержит сценарии для 3D -визуализации.output содержит журнал, обученные модели, визуализированные выходы и результаты испытаний. Вы должны следовать структуре каталогов data , как показано ниже.

${POSE_ROOT}

|-- data

| |-- Human36M

| | |-- bbox_root

| | | |-- bbox_root_human36m_output.json

| | |-- images

| | |-- annotations

| |-- MPII

| | |-- images

| | |-- annotations

| |-- MSCOCO

| | |-- bbox_root

| | | |-- bbox_root_coco_output.json

| | |-- images

| | | |-- train2017

| | | |-- val2017

| | |-- annotations

| |-- MuCo

| | |-- data

| | | |-- augmented_set

| | | |-- unaugmented_set

| | | |-- MuCo-3DHP.json

| |-- MuPoTS

| | |-- bbox_root

| | | |-- bbox_mupots_output.json

| | |-- data

| | | |-- MultiPersonTestSet

| | | |-- MuPoTS-3D.json

Чтобы загрузить несколько файлов с Google Drive, не сжав их, попробуйте это. Если у вас есть проблема с проблемой «Загрузить ограничение» при попытке загрузить набор данных по ссылке Google Drive, попробуйте этот трюк.

* Go the shared folder, which contains files you want to copy to your drive

* Select all the files you want to copy

* In the upper right corner click on three vertical dots and select “make a copy”

* Then, the file is copied to your personal google drive account. You can download it from your personal account.

Вы должны следовать структуре каталога output папки, как показано ниже.

${POSE_ROOT}

|-- output

|-- |-- log

|-- |-- model_dump

|-- |-- result

`-- |-- vis

output папки в качестве формы мягкой ссылки рекомендуется вместо формы папки, потому что она потребует большой емкости для хранения.log содержит файл журнала обучения.model_dump содержит сохраненные контрольно -пропускные пункты для каждой эпохи.result содержит окончательные файлы оценки, сгенерированные на этапе тестирования.vis содержит визуализированные результаты.$DB_NAME_img_name.py , чтобы получить имена файлов изображения в формате .txt .preds_2d_kpt_$DB_NAME.mat , preds_3d_kpt_$DB_NAME.mat ) в single или multi папку.draw_3Dpose_$DB_NAME.m main/config.py вы можете изменить настройки модели, включая набор данных, для использования, сетевой основой, размер входа и так далее. В main папке запустите

python train.py --gpu 0-1Чтобы обучить сеть на графическом процессоре 0,1.

Если вы хотите продолжить эксперимент, запустите

python train.py --gpu 0-1 --continue --gpu 0,1 может использоваться вместо --gpu 0-1 .

Поместите обученную модель на output/model_dump/ .

В main папке запустите

python test.py --gpu 0-1 --test_epoch 20 Чтобы проверить сеть на графическом процессоре 0,1 с 20 -й эпохи, обученной модели. --gpu 0,1 может использоваться вместо --gpu 0-1 .

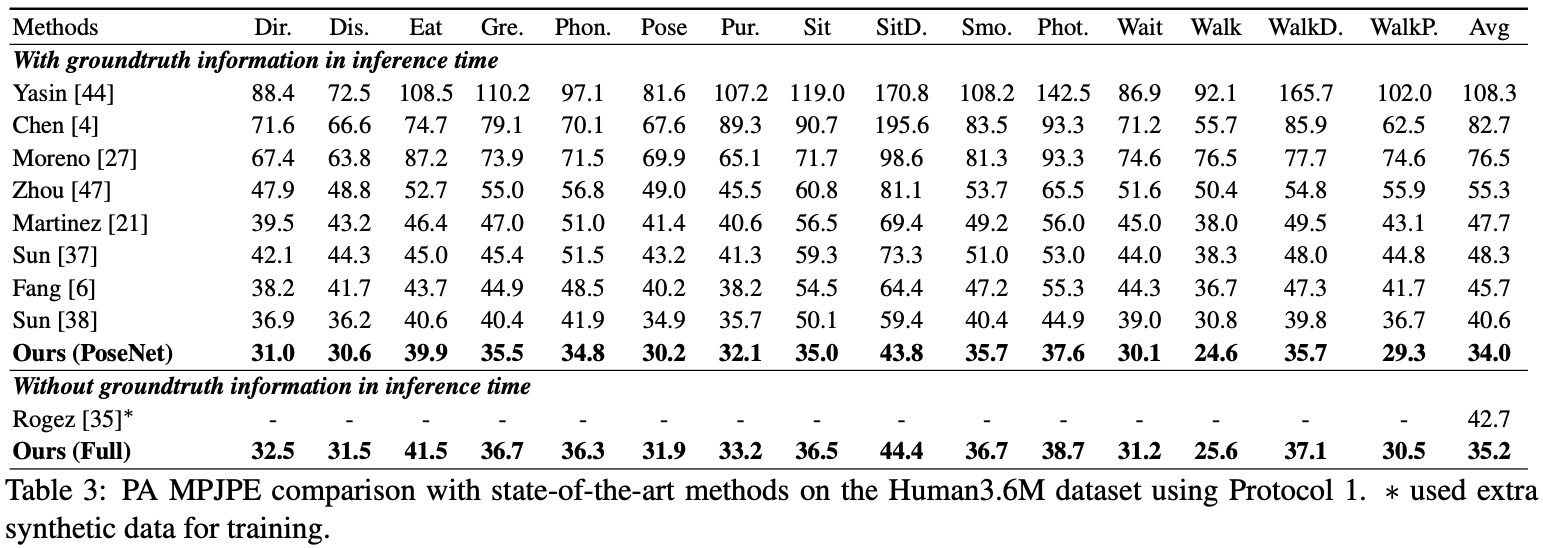

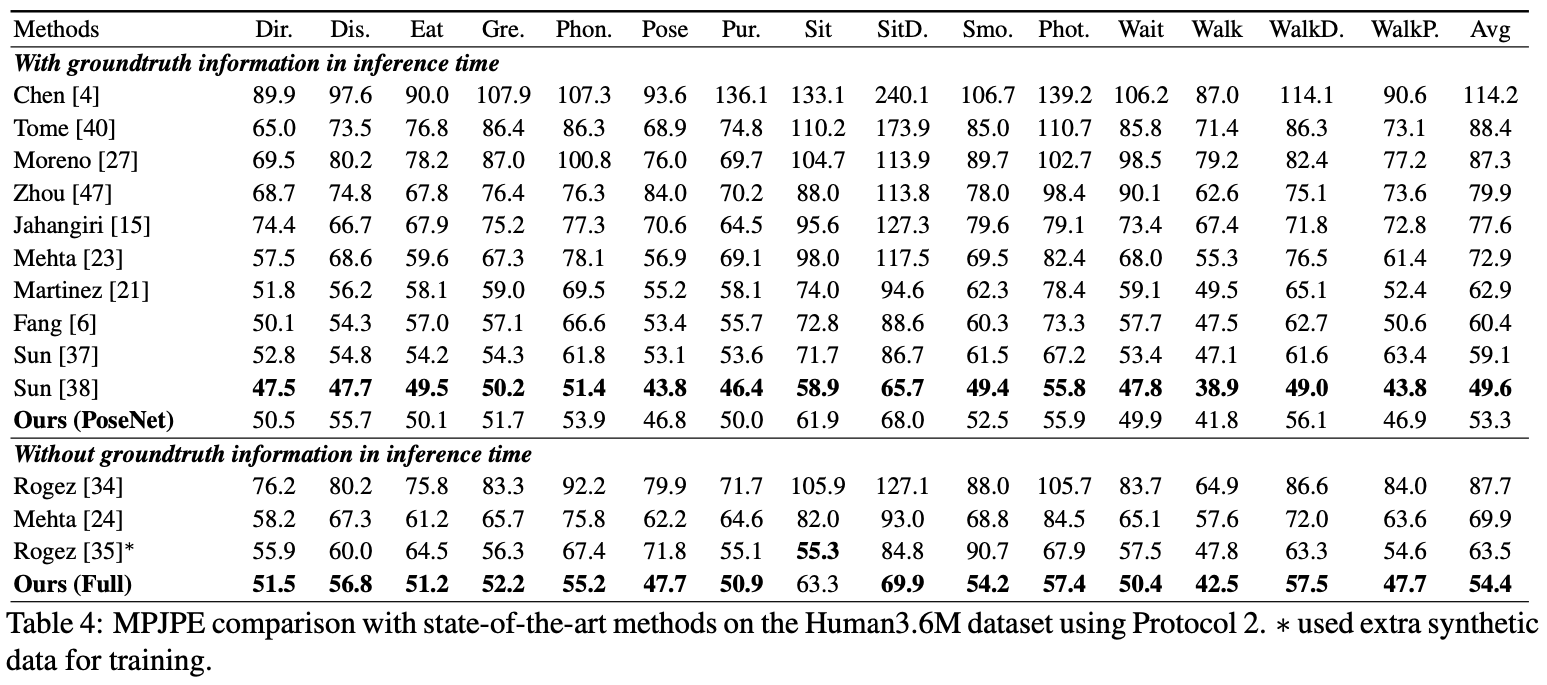

Здесь я сообщаю о производительности Posenet.

Для оценки вы можете запустить test.py или есть коды оценки в Human36M .

Для оценки вы можете запустить test.py или есть коды оценки в Human36M .

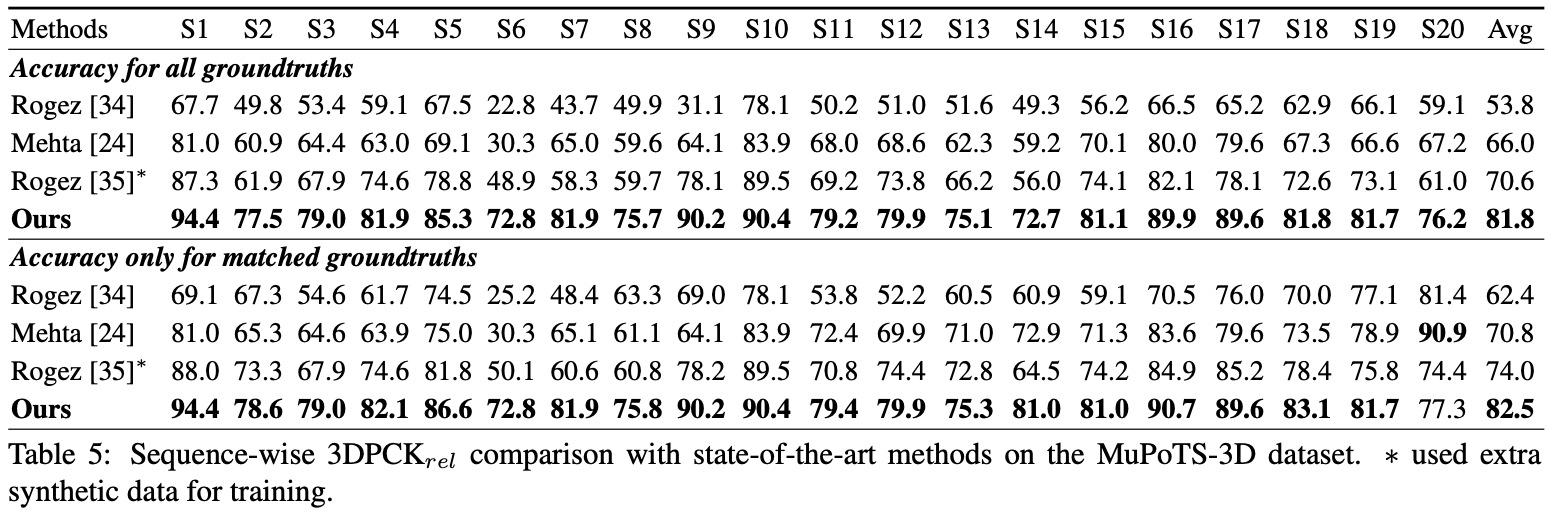

Для оценки запустите test.py После этого переместите data/MuPoTS/mpii_mupots_multiperson_eval.m в data/MuPoTS/data . Кроме того, переместите файлы результатов теста ( preds_2d_kpt_mupots.mat и preds_3d_kpt_mupots.mat ) в data/MuPoTS/data . Затем запустите mpii_mupots_multiperson_eval.m с вашим аргументами режима оценки.

Мы дополнительно предоставляем расчетные 3D -координаты корня человека в наборе данных MSCOCO. Координаты находятся в системе координат 3D камеры, а фокусные расстояния устанавливаются на 1500 мм как для оси x, так и для оси x. Вы можете изменить фокусное расстояние и соответствующее расстояние, используя уравнение 2 или уравнение в дополнительном материале моей бумаги.

@InProceedings{Moon_2019_ICCV_3DMPPE,

author = {Moon, Gyeongsik and Chang, Juyong and Lee, Kyoung Mu},

title = {Camera Distance-aware Top-down Approach for 3D Multi-person Pose Estimation from a Single RGB Image},

booktitle = {The IEEE Conference on International Conference on Computer Vision (ICCV)},

year = {2019}

}