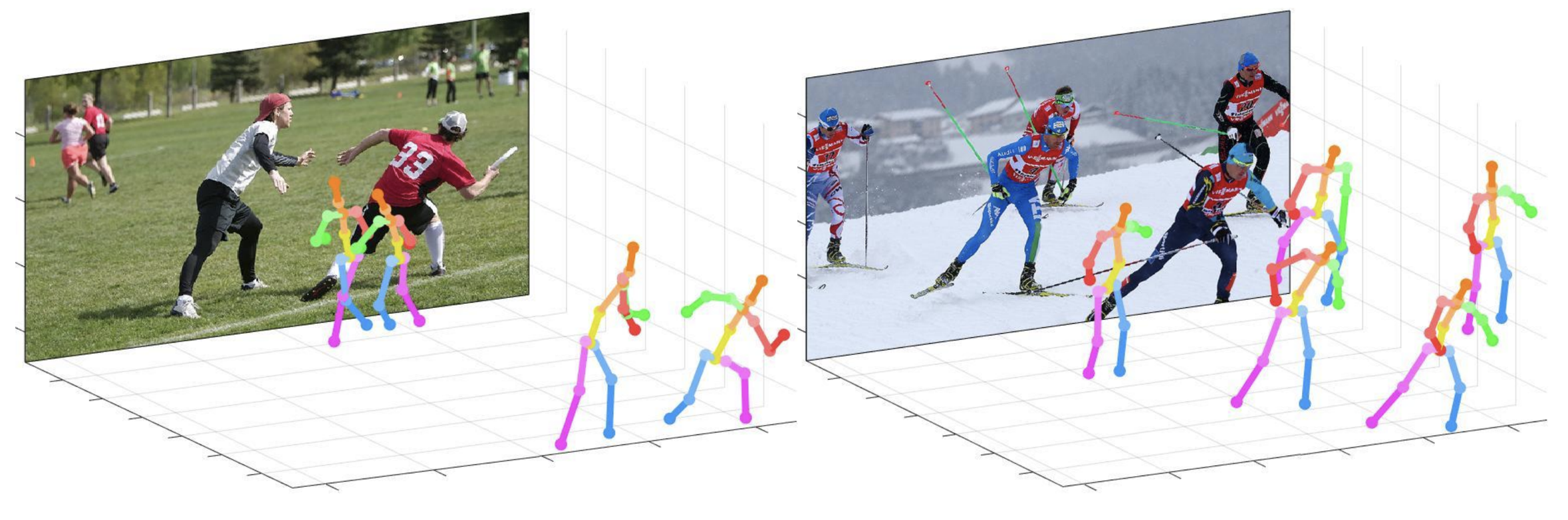

Dieses Repo ist eine offizielle Pytorch- Implementierung des Kamera-Distanz-bewussten Top-Down-Ansatzes für die 3D-Multi-Personen-Pose-Schätzung aus einem einzigen RGB-Bild (ICCV 2019) . Es enthält einen Posenet -Teil.

Was dieses Repo bietet:

Dieser Code wird unter Ubuntu 16.04, CUDA 9.0, CUDNN 7.1 -Umgebung mit zwei Nvidia 1080ti -GPUs getestet.

Die Python 3.6.5 -Version mit Anaconda 3 wird für die Entwicklung verwendet.

Sie können eine schnelle Demo im demo -Ordner ausprobieren.

input.jpg und vorgebildetem Snapshot im demo Ordner vor.bbox_list .root_depth_list .python demo.py --gpu 0 --test_epoch 24 aus, wenn Sie mit GPU 0 ausführen möchten.output_pose_2d.jpg und ein neues Fenster sehen, das 3D -Pose anzeigt. Die ${POSE_ROOT} wird wie unten beschrieben.

${POSE_ROOT}

|-- data

|-- demo

|-- common

|-- main

|-- tool

|-- vis

`-- output

data enthält Datenladencodes und Soft -Links zu Bildern und Annotationenverzeichnissen.demo enthält Demo -Codes.common enthält Kernelcodes für ein 3D-Multi-Personen-Pose-Schätzsystem.main enthält hochrangige Codes für das Training oder das Testen des Netzwerks.tool enthält Datenvorverarbeitungscodes. Sie müssen diesen Code nicht ausführen. Ich stelle nachstehend vorverarbeitete Daten an.vis enthält Skripte für die 3D -Visualisierung.output enthält Protokoll, trainierte Modelle, visualisierte Ausgänge und Testergebnisse. Sie müssen die Verzeichnisstruktur der data wie unten befolgen.

${POSE_ROOT}

|-- data

| |-- Human36M

| | |-- bbox_root

| | | |-- bbox_root_human36m_output.json

| | |-- images

| | |-- annotations

| |-- MPII

| | |-- images

| | |-- annotations

| |-- MSCOCO

| | |-- bbox_root

| | | |-- bbox_root_coco_output.json

| | |-- images

| | | |-- train2017

| | | |-- val2017

| | |-- annotations

| |-- MuCo

| | |-- data

| | | |-- augmented_set

| | | |-- unaugmented_set

| | | |-- MuCo-3DHP.json

| |-- MuPoTS

| | |-- bbox_root

| | | |-- bbox_mupots_output.json

| | |-- data

| | | |-- MultiPersonTestSet

| | | |-- MuPoTS-3D.json

Um mehrere Dateien von Google Drive herunterzuladen, ohne sie zu komprimieren, versuchen Sie dies. Wenn Sie ein Problem mit dem Problem "Download Limit" haben, wenn Sie versucht haben, den Datensatz vom Google Drive -Link herunterzuladen, versuchen Sie diesen Trick bitte.

* Go the shared folder, which contains files you want to copy to your drive

* Select all the files you want to copy

* In the upper right corner click on three vertical dots and select “make a copy”

* Then, the file is copied to your personal google drive account. You can download it from your personal account.

Sie müssen die Verzeichnisstruktur des output wie unten befolgen.

${POSE_ROOT}

|-- output

|-- |-- log

|-- |-- model_dump

|-- |-- result

`-- |-- vis

output als Soft Link -Formular wird anstelle des Ordnersformulars empfohlen, da es eine große Speicherkapazität erfolgt.log enthält eine Trainingsprotokolldatei.model_dump -Ordner enthält gespeicherte Checkpoints für jede Epoche.result enthält endgültige Schätzdateien, die in der Testphase generiert wurden.vis -Ordner enthält visualisierte Ergebnisse.$DB_NAME_img_name.py aus, um Bilddateinamen im .txt -Format zu erhalten.preds_2d_kpt_$DB_NAME.mat , preds_3d_kpt_$DB_NAME.mat ) in single oder multi -Ordner.draw_3Dpose_$DB_NAME.m main/config.py können Sie die Einstellungen des Modells einschließlich des Datensatzes, das Netzwerk -Rückgrat und die Eingabemaßnahmen usw. ändern. Laufen Sie im main

python train.py --gpu 0-1Um das Netzwerk in der GPU 0,1 zu trainieren.

Wenn Sie das Experiment fortsetzen möchten, rennen Sie

python train.py --gpu 0-1 --continue --gpu 0,1 kann anstelle von --gpu 0-1 verwendet werden.

Platzieren Sie das geschulte Modell am output/model_dump/ .

Laufen Sie im main

python test.py --gpu 0-1 --test_epoch 20 Um das Netzwerk in der GPU 0,1 mit dem 20. Epoch -geschulten Modell zu testen. --gpu 0,1 kann anstelle von --gpu 0-1 verwendet werden.

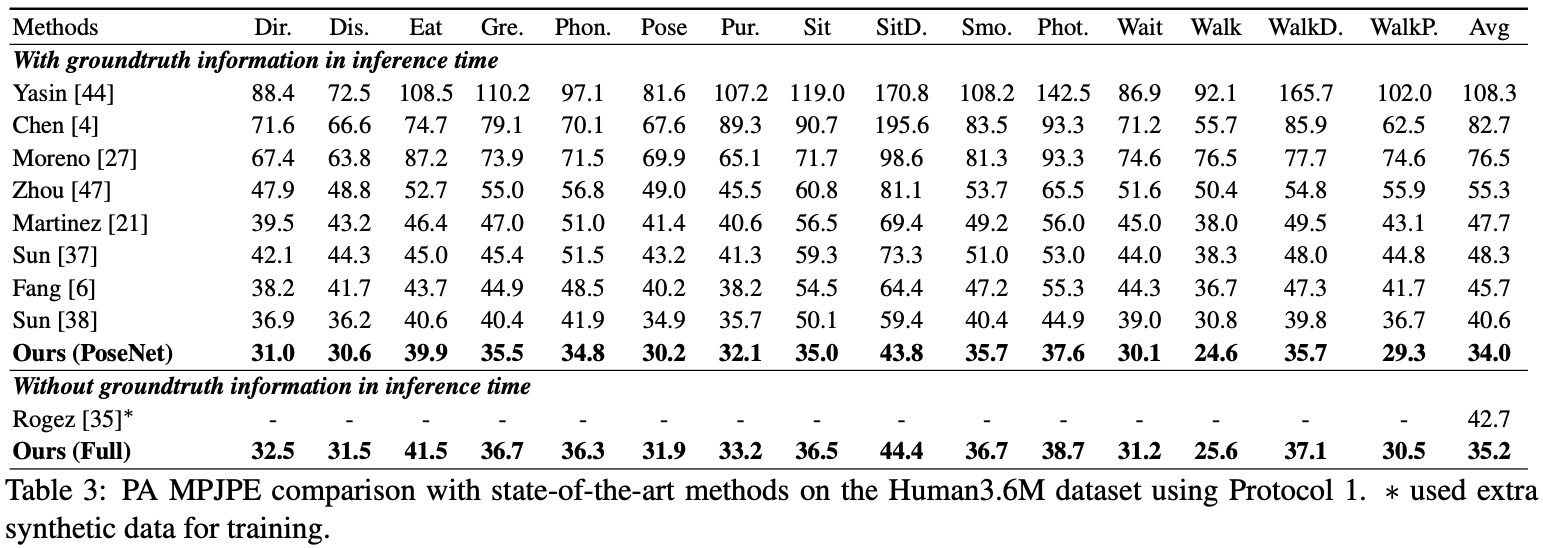

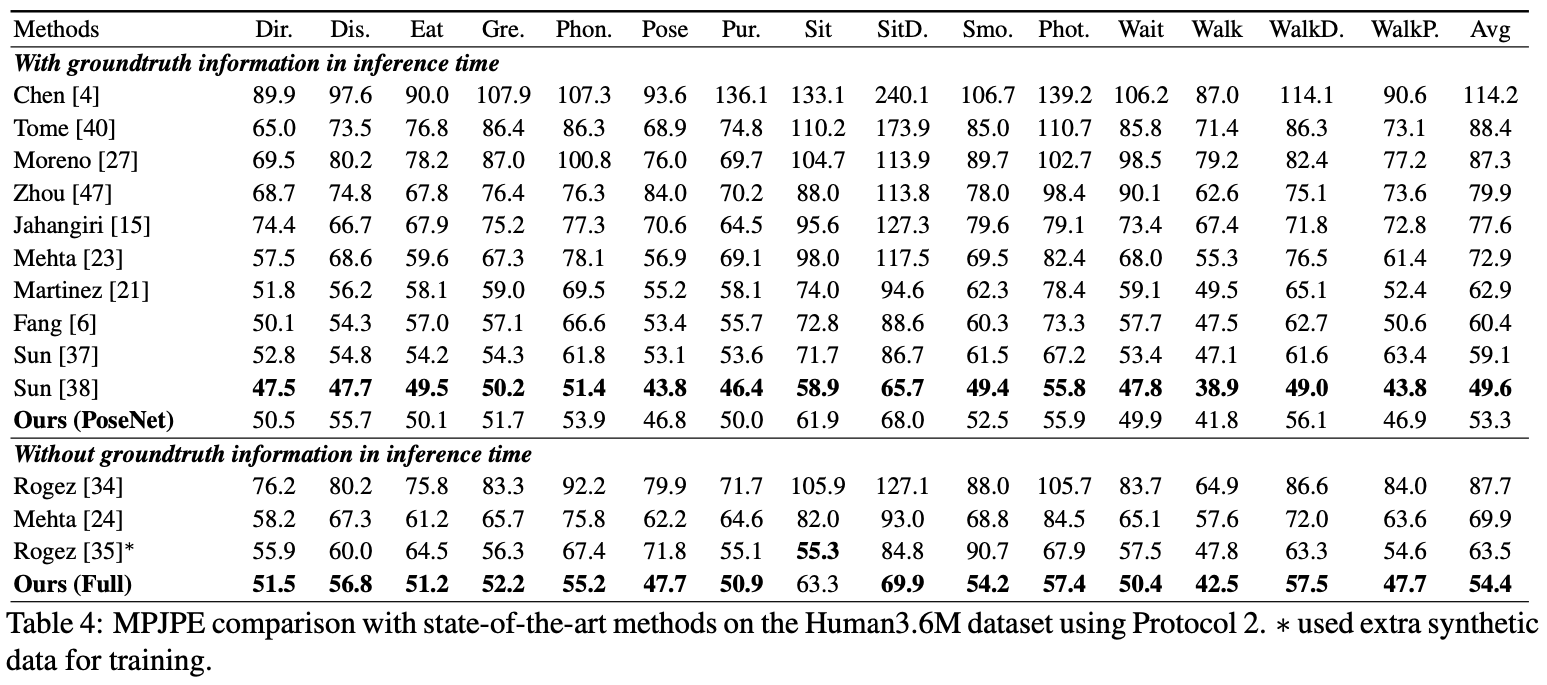

Hier melde ich die Leistung des Posenet.

Für die Human36M können Sie test.py ausführen.

Für die Human36M können Sie test.py ausführen.

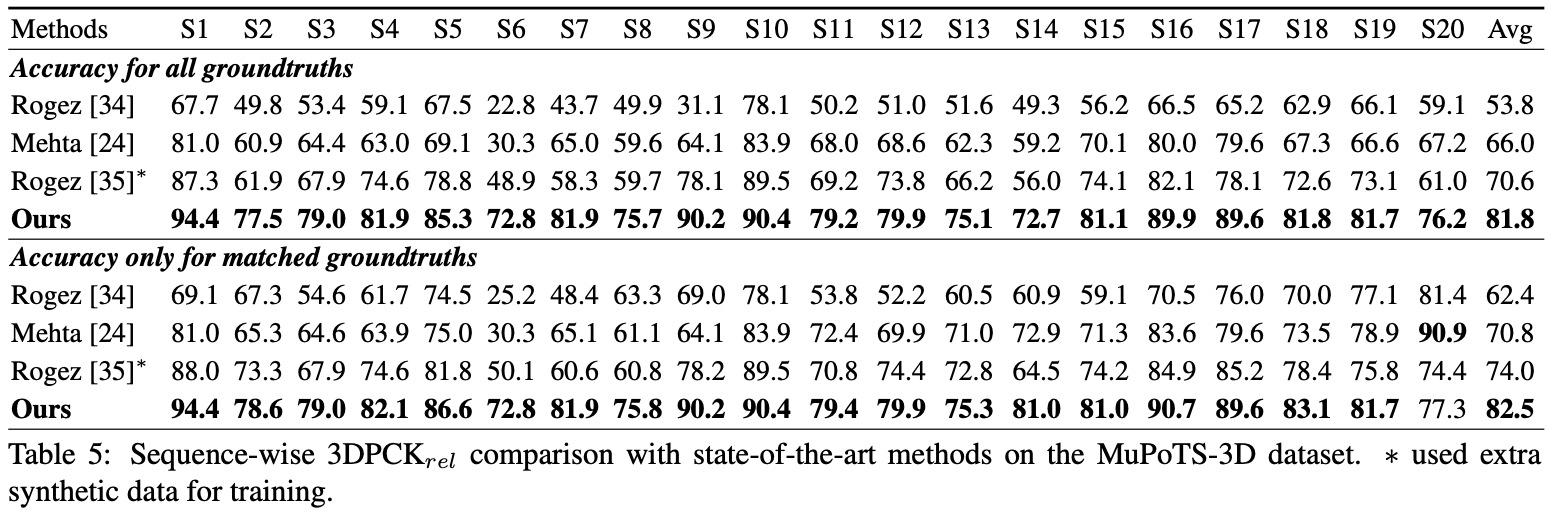

Für die Bewertung rennen Sie test.py Danach verschieben Sie data/MuPoTS/mpii_mupots_multiperson_eval.m in data/MuPoTS/data . Verschieben Sie auch die Testergebnisdateien ( preds_2d_kpt_mupots.mat und preds_3d_kpt_mupots.mat ) in data/MuPoTS/data . Führen Sie dann mpii_mupots_multiperson_eval.m mit Ihren Auswertungsmodus -Argumenten aus.

Wir bieten zusätzlich geschätzte 3D -menschliche Wurzelkoordinaten im MSCOCO -Datensatz an. Die Koordinaten befinden sich im 3D -Kamerakoordinatensystem und die Brennweiten sind sowohl für die X- als auch für die Y -Achse auf 1500 mm eingestellt. Sie können die Brennweite und den entsprechenden Abstand unter Verwendung von Gleichung 2 oder Gleichung im Supplementarialmaterial meines Papiers ändern.

@InProceedings{Moon_2019_ICCV_3DMPPE,

author = {Moon, Gyeongsik and Chang, Juyong and Lee, Kyoung Mu},

title = {Camera Distance-aware Top-down Approach for 3D Multi-person Pose Estimation from a Single RGB Image},

booktitle = {The IEEE Conference on International Conference on Computer Vision (ICCV)},

year = {2019}

}