Detext - это структура понимания текста DE EP для ранжирования, классификации и генерации языка, связанных с НЛП. Он использует семантическое соответствие с использованием глубоких нейронных сетей для понимания намерений участников в поисках и рекомендательных системах.

Как общая структура НЛП, DETEXT может применяться ко многим задачам, включая рейтинг поиска и рекомендаций, многоклассовую классификацию и задачи понимания запросов.

Более подробную информацию можно найти в сообщении в блоге LinkedIn Engineering.

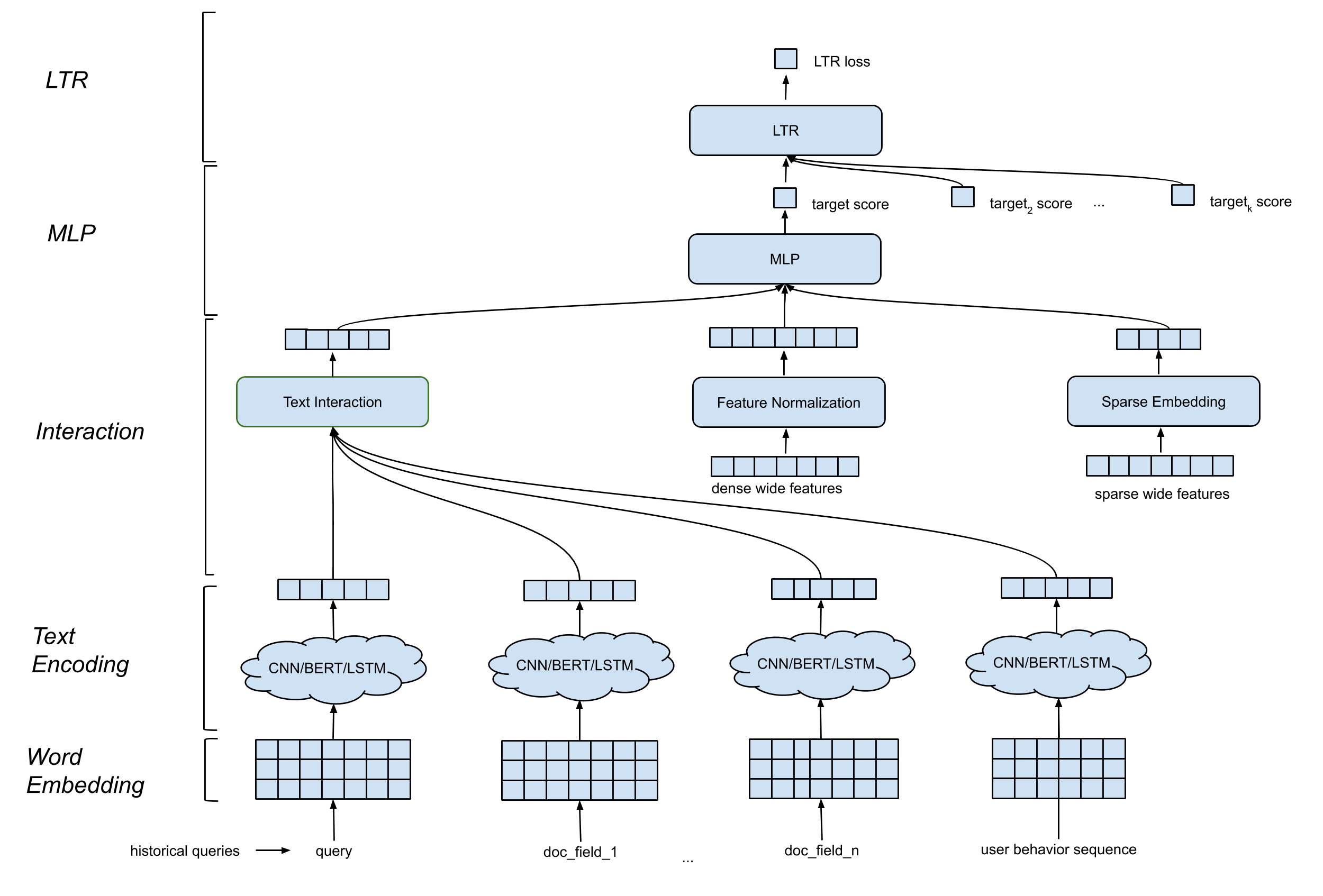

DETEXT поддерживает общую модель архитектуру, которая содержит следующие компоненты:

Слово встроенное слой . Он преобразует последовательность слов в AD с помощью n матрицы.

CNN/BERT/LSTM для кодирования текста . Он входит в слово «встраивающаяся матрица» в качестве входного и отображает текстовые данные в фиксированную длину.

Взаимодействие слой . Он генерирует глубокие функции на основе текстовых встроений. Варианты включают конкатенацию, сходство косинуса и т. Д.

Широкая и глубокая обработка функций . Мы широко и глубоко объединяем традиционные особенности с функциями взаимодействия (глубокие особенности).

MLP -слой . Слой MLP состоит в том, чтобы объединить широкие характеристики и глубокие особенности.

Все параметры совместно обновляются для оптимизации цели обучения.

Detext предлагает клиентам большую гибкость для создания индивидуальных сетей для своих собственных вариантов использования:

LTR/классификационный уровень : внутренняя реализация потерь LTR или потеря LTR TF, поддержка многоклассной классификации.

МЛП слой : настраиваемое количество слоев и количество размеров.

Слой взаимодействия : поддерживать сходство косинуса, продукт хадамарда и конкатенацию.

Текстовый встроенный слой : Поддержка CNN, BERT, LSTM с настраиваемыми параметрами на фильтрах, слоях, размерах и т. Д.

Непрерывная нормализация функций : сроки элемента, нормализация значений.

Категориальная обработка функций : моделируется как встраивание сущности.

Все это можно настроить с помощью гиперпараметров в шаблоне DETEXT. Обратите внимание, что TF-Ranking поддерживается в Detext Framework, то есть пользователи могут выбрать потерю LTR и метрики, определенные в DeText.

VENV_DIR = < your venv dir >

python3 -m venv $VENV_DIR # Make sure your python version >= 3.7

source $VENV_DIR /bin/activate # Enter the virtual environmentpip3 install -U pip

pip3 install -U setuptoolspip install . -epytest Если вы хотите простую попробовать из библиотеки, вы можете обратиться к следующим ноутбукам для учебного пособия

text_classification_demo.ipynb

В этом ноутбуке показано, как использовать DETEXT для обучения многоклассной модели классификации текста в наборе данных классификации намерений публичных запросов. Подробные инструкции по подготовке данных, обучению модели, модели включены.

AutoCumpletion.ipynb

В этом ноутбуке показано, как использовать Detext для обучения модели рейтинга текста в наборе данных об автоматическом завершении публичного запроса. Подробные шаги по подготовке данных, обучению модели, примеры вывода модели включены.

Пожалуйста, процитируйте DeText в ваших публикациях, если это поможет вашему исследованию:

@manual{guo-liu20,

author = {Weiwei Guo and

Xiaowei Liu and

Sida Wang and

Huiji Gao and

Bo Long},

title = {DeText: A Deep NLP Framework for Intelligent Text Understanding},

url = {https://engineering.linkedin.com/blog/2020/open-sourcing-detext},

year = {2020}

}

@inproceedings{guo-gao19,

author = {Weiwei Guo and

Huiji Gao and

Jun Shi and

Bo Long},

title = {Deep Natural Language Processing for Search Systems},

booktitle = {ACM SIGIR 2019},

year = {2019}

}

@inproceedings{guo-gao19,

author = {Weiwei Guo and

Huiji Gao and

Jun Shi and

Bo Long and

Liang Zhang and

Bee-Chung Chen and

Deepak Agarwal},

title = {Deep Natural Language Processing for Search and Recommender Systems},

booktitle = {ACM SIGKDD 2019},

year = {2019}

}

@inproceedings{guo-liu20,

author = {Weiwei Guo and

Xiaowei Liu and

Sida Wang and

Huiji Gao and

Ananth Sankar and

Zimeng Yang and

Qi Guo and

Liang Zhang and

Bo Long and

Bee-Chung Chen and

Deepak Agarwal},

title = {DeText: A Deep Text Ranking Framework with BERT},

booktitle = {ACM CIKM 2020},

year = {2020}

}

@inproceedings{jia-long20,

author = {Jun Jia and

Bo Long and

Huiji Gao and

Weiwei Guo and

Jun Shi and

Xiaowei Liu and

Mingzhou Zhou and

Zhoutong Fu and

Sida Wang and

Sandeep Kumar Jha},

title = {Deep Learning for Search and Recommender Systems in Practice},

booktitle = {ACM SIGKDD 2020},

year = {2020}

}

@inproceedings{wang-guo20,

author = {Sida Wang and

Weiwei Guo and

Huiji Gao and

Bo Long},

title = {Efficient Neural Query Auto Completion},

booktitle = {ACM CIKM 2020},

year = {2020}

}

@inproceedings{liu-guo20,

author = {Xiaowei Liu and

Weiwei Guo and

Huiji Gao and

Bo Long},

title = {Deep Search Query Intent Understanding},

booktitle = {arXiv:2008.06759},

year = {2020}

}