DECEXT ist ein De -e -Text -Verständnis -Framework für NLP -bezogene Ranking-, Klassifizierungs- und Sprachgenerierungsaufgaben. Es nutzt die semantische Übereinstimmung mit tiefen neuronalen Netzwerken, um die Absichten der Mitglieder bei der Suche und Empfehlungssystemen zu verstehen.

Als allgemeines NLP-Framework kann DETEXT auf viele Aufgaben angewendet werden, einschließlich Such- und Empfehlungsranking, Klassifizierung mit mehreren Klassen und Abfragen verstehen Aufgaben.

Weitere Details finden Sie im LinkedIn Engineering Blog -Beitrag.

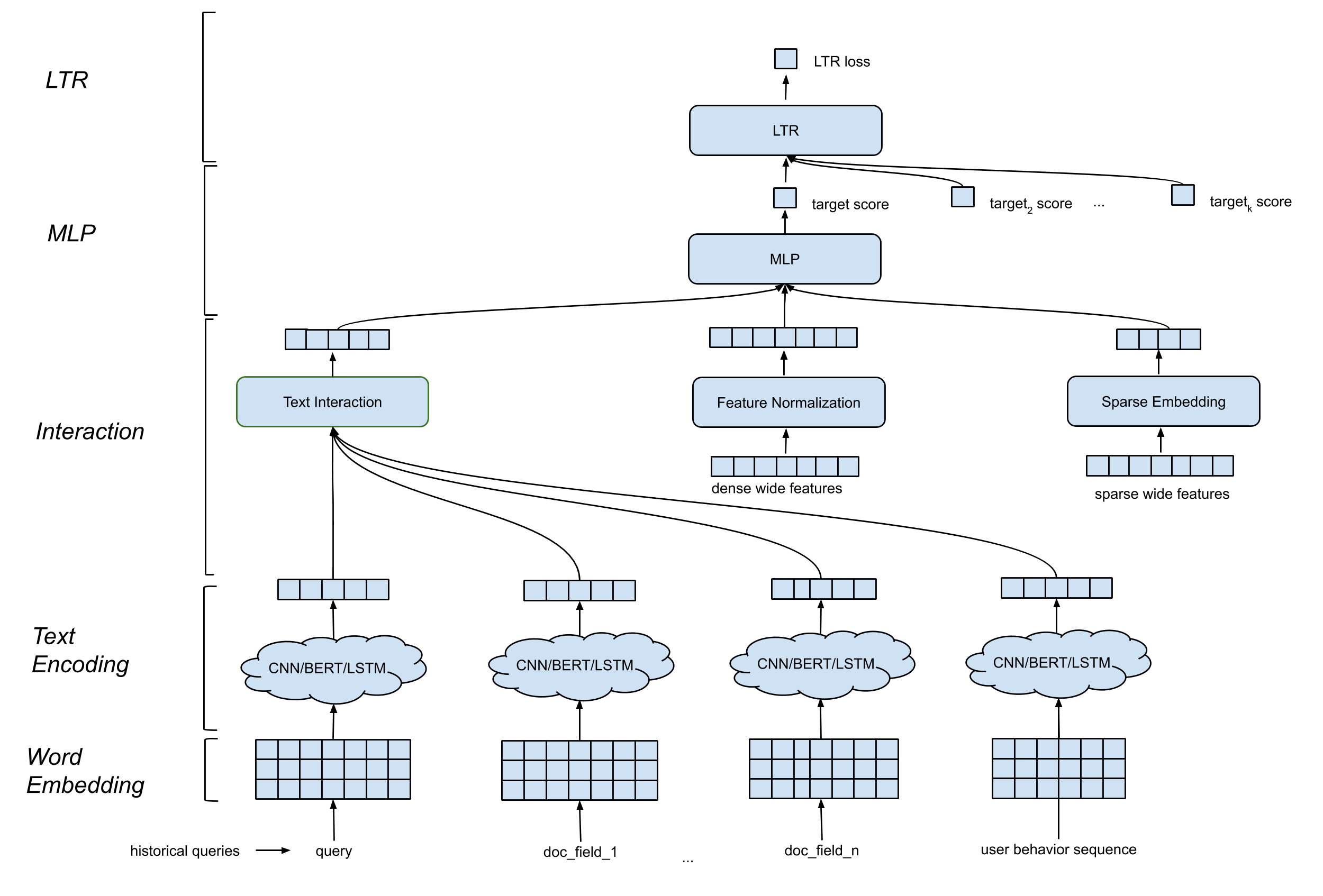

DETEXT unterstützt eine allgemeine Modellarchitektur, die folgende Komponenten enthält:

Worteinbettungsschicht . Es wandelt die Abfolge von Wörtern durch N -Matrix in AD um.

CNN/Bert/LSTM für die Textcodierungsschicht . Es nimmt das Wort eingebettete Matrix als Eingabe auf und ordnet die Textdaten in eine festgelegte Länge ein.

Interaktionsschicht . Es erzeugt tiefe Merkmale basierend auf den Texteinbettungen. Zu den Optionen gehören Verkettung, Ähnlichkeit mit Kosinus usw.

Breite und tiefe Feature -Verarbeitung . Wir kombinieren die traditionellen Merkmale mit den Interaktionsfunktionen (tiefe Funktionen) auf breite und tiefe Weise.

MLP -Schicht . Die MLP -Schicht besteht darin, breite und tiefe Merkmale zu kombinieren.

Alle Parameter werden gemeinsam aktualisiert, um das Trainingsziel zu optimieren.

DETEXT bietet Kunden eine große Flexibilität, um maßgeschneiderte Netzwerke für ihre eigenen Anwendungsfälle zu erstellen:

LTR/Klassifizierungsschicht : Inhouse LTR-Verlust-Implementierung oder TF-Ranking-LTR-Verlust, Klassifizierungsunterstützung mit mehreren Klassen.

MLP -Schicht : Anpassbare Anzahl von Schichten und Anzahl der Abmessungen.

Interaktionsschicht : Unterstützung der Kosinus, Hadamard -Produkt und Verkettung.

Texteinbettungsschicht : Unterstützen Sie CNN, Bert, LSTM mit individuellen Parametern für Filter, Schichten, Abmessungen usw.

Kontinuierliche Merkmalsnormalisation : Elementweise Neutrennung, Wertnormalisierung.

Kategorische Merkmalsverarbeitung : Modelliert als Einbettung von Entity.

All dies kann über Hyper-Parameter in der Detailvorlage angepasst werden. Beachten Sie, dass TF-Ranking im Detail Framework unterstützt wird, dh Benutzer können den LTR-Verlust und die im DEPEXT definierten Metriken auswählen.

VENV_DIR = < your venv dir >

python3 -m venv $VENV_DIR # Make sure your python version >= 3.7

source $VENV_DIR /bin/activate # Enter the virtual environmentpip3 install -U pip

pip3 install -U setuptoolspip install . -epytest Wenn Sie einen einfachen Versuch aus der Bibliothek wünschen, können Sie die folgenden Notizbücher für das Tutorial verweisen

text_classification_demo.ipynb

Dieses Notebook zeigt, wie DETEXT zum Training eines Textklassifizierungsmodells für Multi-Class-Klassifizierung in einem Klassifizierungsdatensatz für die öffentliche Abfrage verwendet wird. Detaillierte Anweisungen zur Datenvorbereitung, zum Modelltraining und zur Modellinferenz sind enthalten.

Autocompletion.ipynb

In diesem Notebook wird angezeigt, wie DETEXT zum Training eines Text -Ranking -Modells auf einem Datensatz für öffentliche Abfragen automatisch geschult wird. Detaillierte Schritte zur Datenvorbereitung, zum Modelltraining, Modellinferenzbeispielen sind enthalten.

Bitte zitieren Sie einen Detail in Ihren Veröffentlichungen, wenn dies Ihrer Forschung hilft:

@manual{guo-liu20,

author = {Weiwei Guo and

Xiaowei Liu and

Sida Wang and

Huiji Gao and

Bo Long},

title = {DeText: A Deep NLP Framework for Intelligent Text Understanding},

url = {https://engineering.linkedin.com/blog/2020/open-sourcing-detext},

year = {2020}

}

@inproceedings{guo-gao19,

author = {Weiwei Guo and

Huiji Gao and

Jun Shi and

Bo Long},

title = {Deep Natural Language Processing for Search Systems},

booktitle = {ACM SIGIR 2019},

year = {2019}

}

@inproceedings{guo-gao19,

author = {Weiwei Guo and

Huiji Gao and

Jun Shi and

Bo Long and

Liang Zhang and

Bee-Chung Chen and

Deepak Agarwal},

title = {Deep Natural Language Processing for Search and Recommender Systems},

booktitle = {ACM SIGKDD 2019},

year = {2019}

}

@inproceedings{guo-liu20,

author = {Weiwei Guo and

Xiaowei Liu and

Sida Wang and

Huiji Gao and

Ananth Sankar and

Zimeng Yang and

Qi Guo and

Liang Zhang and

Bo Long and

Bee-Chung Chen and

Deepak Agarwal},

title = {DeText: A Deep Text Ranking Framework with BERT},

booktitle = {ACM CIKM 2020},

year = {2020}

}

@inproceedings{jia-long20,

author = {Jun Jia and

Bo Long and

Huiji Gao and

Weiwei Guo and

Jun Shi and

Xiaowei Liu and

Mingzhou Zhou and

Zhoutong Fu and

Sida Wang and

Sandeep Kumar Jha},

title = {Deep Learning for Search and Recommender Systems in Practice},

booktitle = {ACM SIGKDD 2020},

year = {2020}

}

@inproceedings{wang-guo20,

author = {Sida Wang and

Weiwei Guo and

Huiji Gao and

Bo Long},

title = {Efficient Neural Query Auto Completion},

booktitle = {ACM CIKM 2020},

year = {2020}

}

@inproceedings{liu-guo20,

author = {Xiaowei Liu and

Weiwei Guo and

Huiji Gao and

Bo Long},

title = {Deep Search Query Intent Understanding},

booktitle = {arXiv:2008.06759},

year = {2020}

}