Китайский | Английский

Этот проект открывает источник большого языкового набора моделей, который была точная настройка/настройка инструкций в китайских медицинских инструкциях, включая ламу, альпака-китайз, цветение, модели подвижного типа и т. Д.

Основываясь на графике медицинских знаний и медицинской литературе, мы в сочетании с API CHATGPT для построения китайского медицинского обучения настройки данных и использовали это для точной настройки инструкций различных основных моделей, улучшая эффект вопросов и ответов в базовой модели в медицинской области.

[2023/09/24] выпустить «Технология тонкой настройки на больших языках

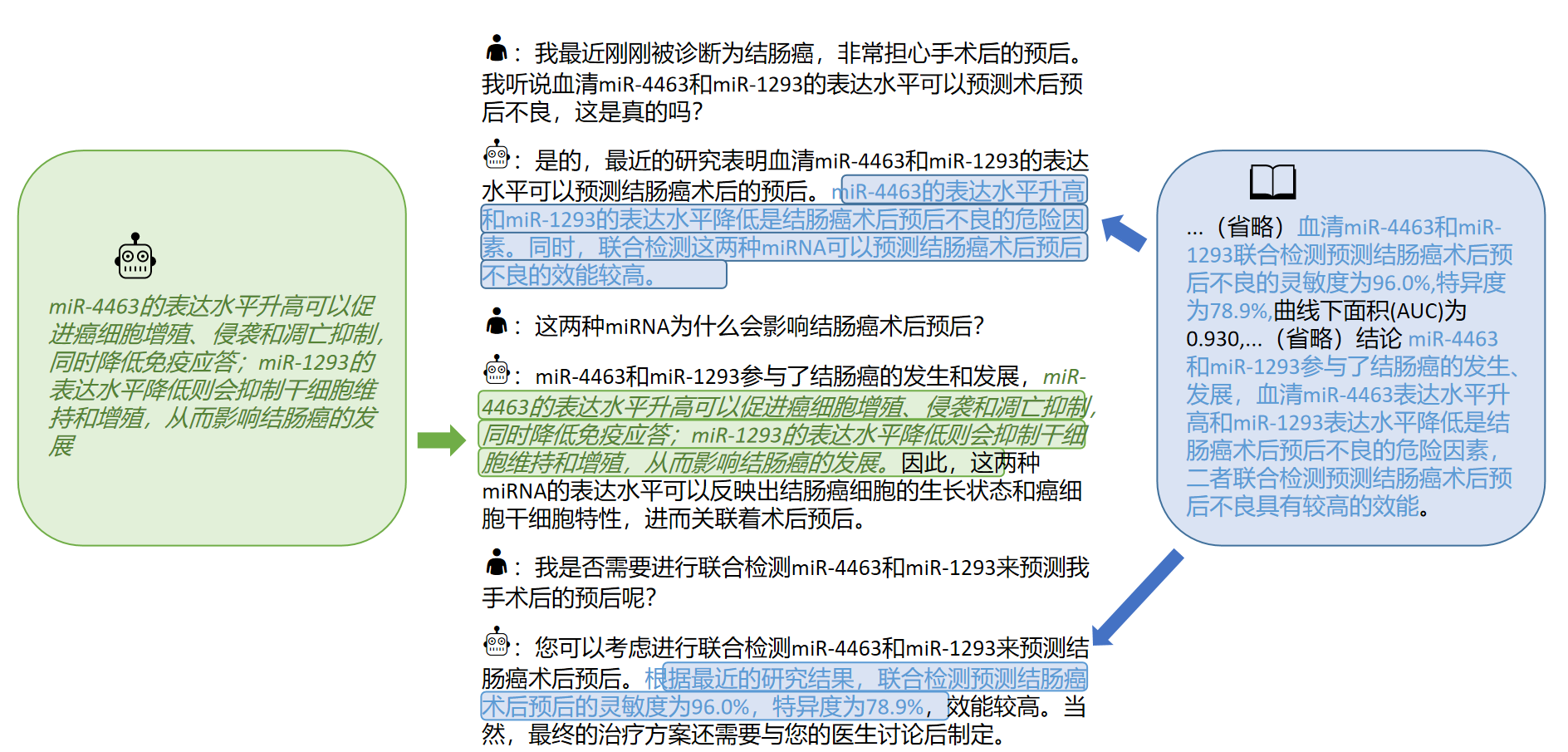

[2023/09/12] выпуск «Изучение приобретения интерактивных знаний из медицинской литературы крупными моделями» на Arxiv

[2023/09/08] выпуск «Надежный метод генерации медицинских ответов китайского медицинского ответа для больших языковых моделей на основе знаний тонкой настройки» на arxiv

[2023/08/07] добавляется выпуск модели на основе подвижного типа, и эффект модели значительно улучшается.

[2023/08/05] Травяная модель представлена на демонстрационном треке CCL 2023.

[2023/08/03] Модель подвижного типа с открытым исходным кодом Scir

[2023/07/19] добавила модель для инструкций с точной настройкой на основе Bloom.

[2023/05/12] Модель была переименована в «Bencao» из «Hua Tuo».

[2023/04/28] добавила релиз модели на основе китайской большой модели Alpaca для инструкций с точной настройкой.

[2023/04/24] добавила модель для точной настройки на основе ламы и медицинской литературы.

[2023/03/31] добавил релиз модели для инструкций с точной настройкой на основе базы знаний Llama и Medical.

Сначала установите пакет зависимости, Environment рекомендует 3,9+

pip install -r requirements.txt

Для всех базовых моделей мы принимаем модель с полуоткрытием LORA FineNuling Method для обучения обучению с тонкой настройкой для взвеси вычислительных ресурсов и производительности модели.

Lora Weights можно загрузить через Baidu NetDisk или обнять лицо:

Загрузите вес Lora и декомпресс. Декомпрессированный формат заключается в следующем:

**lora-folder-name**/

- adapter_config.json # LoRA权重配置文件

- adapter_model.bin # LoRA权重文件

Основываясь на тех же данных, мы также обучили медицинскую версию модели Chatglm: Chatglm-6b-Med

Мы предоставляем некоторые тестовые случаи в ./data/infer.json , которые можно заменить другими наборами данных. Обратите внимание, что формат согласован.

Запустите сценарий вывода

#基于医学知识库

bash ./scripts/infer.sh

#基于医学文献

#单轮

bash ./scripts/infer-literature-single.sh

#多轮

bash ./scripts/infer-literature-multi.sh

Anfer.sh код скрипта выглядит следующим образом. Пожалуйста, замените базовую модель Base_model, LORA Weew Weeht Lora_weights и тестовый путь набора данных instruct_dir в следующем коде и запустите ее после замены базовой модели Base_model, Lora Weeh -Lora_weights и тестирования пути набора набора данных instruct_dir.

python infer.py

--base_model 'BASE_MODEL_PATH'

--lora_weights 'LORA_WEIGHTS_PATH'

--use_lora True

--instruct_dir 'INFER_DATA_PATH'

--prompt_template 'TEMPLATE_PATH'

Выбор шаблонов быстрых шаблонов связан с моделью, подробности следующие:

| Подвижный тип и цветение | Llama & Alpaca |

|---|---|

templates/bloom_deploy.json | На основе templates/med_template.jsonНа основе templates/literature_template.json |

Вы также можете обратиться к ./scripts/test.sh

Основная модель имеет ограниченные эффекты в сценариях медицинских вопросов и ответов, а точная настройка обучения-это эффективный способ, чтобы базовая модель имела способность отвечать на вопросы человека.

Мы приняли открытую и само построенную китайскую базу медицинских знаний, в основном относящиеся к CMEKG.

Медицинская база знаний построена вокруг заболеваний, лекарств, индикаторов обследования и т. Д., А поля включают осложнения, факторы высокого риска, гистологические обследования, клинические симптомы, лекарственное лечение, вспомогательное лечение и т. Д. Пример базы знаний заключается в следующем:

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

Мы использовали интерфейс GPT3.5 для создания данных о вопросах и ответах, касающихся базы медицинских знаний, и настроили различные формы быстрого быстрого использования для полного использования знаний.

Примеры данных учебного набора для инструкций с точной настройкой следующие:

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"

Мы предоставляем учебный набор данных модели, в общей сложности более 8000 штук. Следует отметить, что, хотя строительство учебного набора включает в себя знания, все еще существуют ошибки и недостатки. В будущем мы будем использовать лучшие стратегии для итерации и обновления набора данных.

Качество набора данных с тонкой настройкой инструкции все еще ограничено, и итерация будет выполнена в будущем. В то же время, медицинская база знаний и код набора данных по -прежнему разбираются и будут выпущены после завершения сортировки.

Кроме того, мы собрали китайскую медицинскую литературу по заболеваниям рака печени в 2023 году и использовали границу границы GPT3.5 для построения нескольких раундов данных вопросов и ответов вокруг [вывода] медицинской литературы. В · ./data_literature/liver_cancer.json мы предоставляем 1K обучающие примеры. В настоящее время качество обучающих образцов все еще ограничено. В будущем мы будем дальнейшие перечисления данных и опубликуем их для общественности в форме公开数据集. Примеры обучающих образцов следующие:

В настоящее время мы открываем только параметры модели для отдельных заболеваний «рак гепатита». В будущем мы планируем публиковать наборы данных по медицинским диалогам, которые включают выводы литературы и будут обучать модели для 16 заболеваний, связанных с «гепатобилиарной и поджелудочной железой».

Для получения подробной информации, пожалуйста, обратитесь к нашей статье: «Изучение приобретения интерактивных знаний из медицинской литературы для крупных моделей»

Если вы хотите точно настроить большую языковую модель со своим собственным набором данных, пожалуйста, создайте свой собственный набор данных в формате в ./data/llama_data.json

Запустить сценарий Finetune

bash ./scripts/finetune.sh

Во время процесса точной настройки инструкции, основанного на модели LLAMA, мы тренировались на видеокарте A100-SXM-80GB. Общее тренировочное раунды составляли 10 раундов, что заняло около 2h17 млн. С batch_size = 128 видео память занимает около 40 г. Ожидается, что графические карты 3090/4090 (графическая память 24 ГБ) или выше могут быть лучше поддерживаются, а Batch_size корректируется в соответствии с размером графической памяти.

Для настройки гиперпараметра и экспериментальных процедур, пожалуйста, обратитесь к ссылке WANDB:

https://wandb.ai/thinksoso/llama_med/runs/a5wgcnzt/overview?workspace=user-theinksoso

Примечание. Протестировано в марте 2023 года

| Тестовый вход | Вывод лама | Вывод альпака | Bentsao Materia Medica |

|---|---|---|---|

| Сяо Чжан недавно чувствовал себя плохо и имеет такие симптомы, как сердцебиение и одышка. Физикальное обследование показало, что сердце было увеличено, а пульсация была ослаблена. | Вопрос: Сяо Чжан в последнее время чувствовал себя плохо и имеет такие симптомы, как сердцебиение и одышка. Физикальное обследование показало, что сердце было увеличено, а пульсация была ослаблена. | Недавно Сяо Чжан чувствовал себя некомфортно и имеет такие симптомы, как расстройство и одышка. Физическое обследование показывает, что сердце увеличено, а мышцы слабы. | Сяо Чжан может страдать от миокардита, поэтому рекомендуется как можно скорее отправиться в больницу для обследования и лечения. Варианты лечения включают лекарства и хирургическое лечение. |

| Являются ли причины проказы и детской астмы? | Причины астмы и проказы у детей последовательны, но причины астмы и проказы у детей не являются последовательными | Да, у астмы и детей есть похожие причины. | Несовместимость, причиной проказы является проказа инфекция, в то время как причиной астмы у детей является такие факторы, как плохое кормление и курение. |

| У пациента развился постоянный отек и желтуха. После обследования визуализации болезнь камня гепатобилиарного протока. Какие планы лечения следует принимать? | Какие планы лечения должны принимать пациенты с гепатобилиарным протоком? | Пациенты должны пройти комбинацию хирургии и химиотерапии. | Для заболевания камня гепатобилиарного протока планы лечения включают хирургическое лечение, лекарственное лечение и вспомогательное лечение. Специальный план лечения должен быть определен в соответствии с конкретными обстоятельствами пациента. |

В: Почему это было переименовано в "Bencao"?

A: Согласованность названия лаборатории SCIR Laboratory Laboratory Laboratory, и название китайской медицинской модели приспосабливается к «материальной травяной медицине».

В: Почему это "hua tuo" вместо "hua tuo"?

A: Это называется «верблюжьим», потому что наша основная модель Llama - это лама, а альпака - альпака. Вдохновленный их именами и гомофоническим фоном Хуа Туо, мы назвали нашу модель Хуа Туо.

В: Используются ли какая -либо традиционная теория китайской медицины или традиционная китайская медицина?

A: Нет

В: Результаты прогона модели различны, а эффекты ограничены

A: Из -за рассмотрения генеративного разнообразия в генеративных моделях результаты нескольких прогонов могут варьироваться. Текущая модель с открытым исходным кодом ограничена в китайском корпусе ламы и альпаки, и способ сочетания знаний является относительно грубым, пожалуйста, попробуйте модели на основе цветущих и подвижных типов.

В: Модель не может запустить/содержание вывода совершенно неприемлемо

A: Пожалуйста, определите зависимости в установленных требованиях, настройте среду CUDA и добавьте переменные среды, правильно введите загруженную модель и местоположение хранилища LORA; Если содержание вывода дублируется или какой-то неправильный контент принадлежит случайному явлению модели на основе ламы, он имеет определенную связь с китайской способностью модели LLAMA, шкалы учебных данных и настройки гиперпараметра. Пожалуйста, попробуйте новую модель на основе подвижного типа. Если есть серьезные проблемы, пожалуйста, опишите имя работает подробно. Спасибо.

В: Какие из нескольких выпущенных моделей являются лучшими?

A: Согласно нашему опыту, эффект, основанный на модели подвижного типа, относительно лучше.

Этот проект был завершен Wang Haochun, Du Yanrui, Liu Chi, Bai Rui, Cinuwa, Chen Yuhan, Qiang Zewen, Chen Jianyu и Li Zijian, группой разведки здравоохранения Центра социальных вычислений и поиска информации Института технологии Харбина. Преподаватели - доцент профессора Чжао Сенганга, профессора Цинь Бина и профессора Лю Тин.

Этот проект относится к следующим проектам с открытым исходным кодом, и мы хотели бы выразить нашу благодарность соответствующим проектам и исследованиям и разработчикам.

Ресурсы, связанные с этим проектом, предназначены только для академических исследований и строго запрещены для коммерческих целей. При использовании деталей, включающих сторонний код, пожалуйста, строго следуйте соответствующему протоколу с открытым исходным кодом. На содержание, генерируемое моделью, влияет такие факторы, как расчет модели, случайность и количественная потери точности, и этот проект не может гарантировать ее точность. Большинство наборов данных этого проекта генерируются моделями и не могут быть использованы в качестве основы для фактического медицинского диагноза, даже если они соответствуют определенным медицинским фактам. Этот проект не несет никакой юридической ответственности за любые выводы контента по модели, а также не несет ответственности за какие -либо убытки, которые могут возникнуть в результате использования соответствующих ресурсов и результатов выходных данных.

Если вы использовали данные или код этого проекта, или наша работа полезна для вас, пожалуйста, объявите цитату

Технический отчет первого издания: Huatuo: настройка модели Llama с китайскими медицинскими знаниями

@misc{wang2023huatuo,

title={HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge},

author={Haochun Wang and Chi Liu and Nuwa Xi and Zewen Qiang and Sendong Zhao and Bing Qin and Ting Liu},

year={2023},

eprint={2304.06975},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Настройка знаний крупных языковых моделей со структурированными базами медицинских знаний для надежного генерации ответов на китайском языке

@misc{wang2023knowledgetuning,

title={Knowledge-tuning Large Language Models with Structured Medical Knowledge Bases for Reliable Response Generation in Chinese},

author={Haochun Wang and Sendong Zhao and Zewen Qiang and Zijian Li and Nuwa Xi and Yanrui Du and MuZhen Cai and Haoqiang Guo and Yuhan Chen and Haoming Xu and Bing Qin and Ting Liu},

year={2023},

eprint={2309.04175},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Набор данных Calla: Interactive Interactive LLMS в китайской медицинской литературе из китайской медицинской литературы

@misc{du2023calla,

title={The CALLA Dataset: Probing LLMs' Interactive Knowledge Acquisition from Chinese Medical Literature},

author={Yanrui Du and Sendong Zhao and Muzhen Cai and Jianyu Chen and Haochun Wang and Yuhan Chen and Haoqiang Guo and Bing Qin},

year={2023},

eprint={2309.04198},

archivePrefix={arXiv},

primaryClass={cs.CL}

}