الصينية | إنجليزي

يفتح هذا المشروع مصدر مجموعة نموذج لغوية كبيرة تم ضبطه/صقل التعليمات في التعليمات الطبية الصينية ، بما في ذلك LAMA و Alpaca-Chinese و Bloom و Movable Type Models ، إلخ.

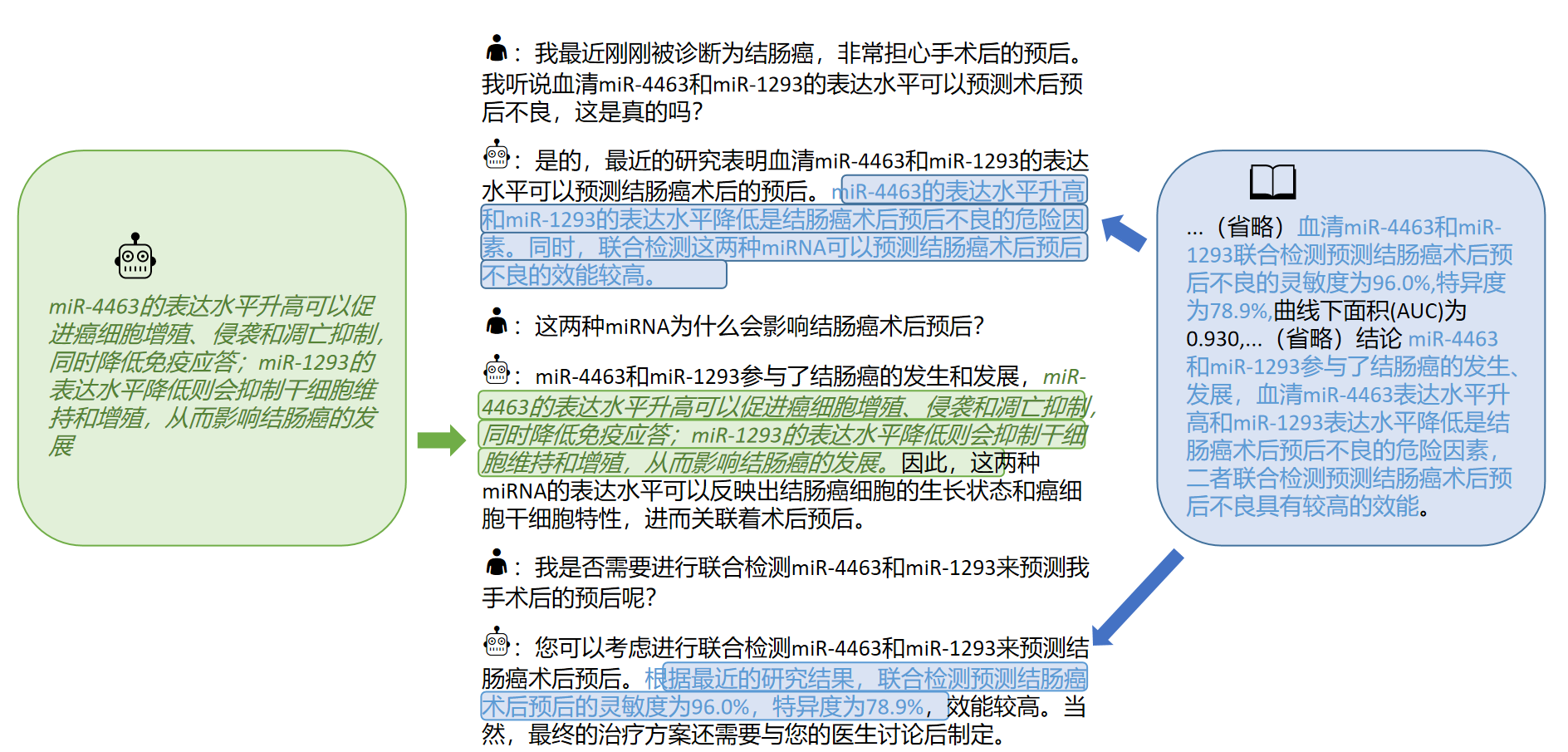

استنادًا إلى الرسم البياني للمعرفة الطبية والأدب الطبي ، قمنا بالاندماج مع API ChatGPT لإنشاء مجموعة بيانات صينية صينية لتصنيع التعليمات الطبية ، واستخدمنا هذا لضبط تعليمات النماذج الأساسية المختلفة ، وتحسين تأثير السؤال والإجابات للنموذج الأساسي في المجال الطبي.

[2023/09/24] إصدار "تقنية صقل نموذج اللغة الكبيرة للرعاية الصحية الذكية"

[2023/09/12] إطلاق "استكشاف الاستحواذ على المعرفة التفاعلية من الأدبيات الطبية من قبل نماذج كبيرة" على Arxiv

[2023/09/08] إطلاق "طريقة توليد الاستجابة الطبية الصينية الموثوقة لنماذج اللغة الكبيرة القائمة على ضبط المعرفة" على Arxiv

[2023/08/07] تتم إضافة إصدار نموذج يعتمد على النوع المنقول ، ويتم تحسين تأثير النموذج بشكل كبير.

[2023/08/05] يتم تقديم نموذج العشبية على مسار التجريبي CCL 2023.

[2023/08/03] مختبر SCIR المفتوح المصدر المنقولة النوع العام ونموذج الإجابة ، مرحبًا بك في متابعة ؟؟

[2023/07/19] أضاف نموذجًا للتعليمات التي تعتمد على الإزهار.

[2023/05/12] تم إعادة تسمية النموذج "Bencao" من "Hua Tuo".

[2023/04/28] أضاف إصدار نموذج يعتمد على نموذج الألبكة الصيني الكبير للحصول على تعليمات صياغة.

[2023/04/24] أضاف نموذجًا لتعليم الضبط القائم على LLAMA والأدب الطبي.

[2023/03/31] أضاف إصدارًا نموذجًا للتعليمات التي تم صياغتها على أساس LLAMA وقاعدة المعرفة الطبية.

قم بتثبيت حزمة التبعية أولاً ، توصي بيئة Python 3.9+

pip install -r requirements.txt

بالنسبة لجميع النماذج الأساسية ، فإننا نعتمد طريقة صقل LORA الدقيقة نصف الدقة للتدريب على صقل التعليمات لوزن موارد الحوسبة وأداء النموذج.

يمكن تنزيل أوزان Lora من خلال Baidu NetDisk أو وجه المعانقة:

قم بتنزيل وزن Lora وإلغاء الضغط. التنسيق المضغوط هو كما يلي:

**lora-folder-name**/

- adapter_config.json # LoRA权重配置文件

- adapter_model.bin # LoRA权重文件

استنادًا إلى نفس البيانات ، قمنا أيضًا بتدريب الإصدار الطبي من طراز ChatGlm: ChatGlm-6B-Med

نحن نقدم بعض حالات الاختبار في ./data/infer.json ، والتي يمكن استبدالها بمجموعات بيانات أخرى. يرجى ملاحظة أن التنسيق متسق.

قم بتشغيل البرنامج النصي الاستنتاج

#基于医学知识库

bash ./scripts/infer.sh

#基于医学文献

#单轮

bash ./scripts/infer-literature-single.sh

#多轮

bash ./scripts/infer-literature-multi.sh

رمز البرنامج النصي. يرجى استبدال نموذج الأساس base_model و lora weight lora_weights واختبار مسار مجموعة البيانات instruct_dir في الكود التالي وقم بتشغيله بعد استبدال قاعدة النموذج الأساسية base_model و lora lora_weights واختبار مسار DataSet instruct_dir.

python infer.py

--base_model 'BASE_MODEL_PATH'

--lora_weights 'LORA_WEIGHTS_PATH'

--use_lora True

--instruct_dir 'INFER_DATA_PATH'

--prompt_template 'TEMPLATE_PATH'

يرتبط اختيار القوالب المذهلة بالنموذج ، والتفاصيل هي كما يلي:

| نوع متحرك وتفتح | لاما وألباكا |

|---|---|

templates/bloom_deploy.json | بناءً على templates/med_template.jsonبناءً على templates/literature_template.json |

يمكنك أيضًا الرجوع إلى ./scripts/test.sh

النموذج الأساسي له آثار محدودة في سيناريوهات الأسئلة والأجوبة الطبية ، والتعليمات التي يتم صقلها هي وسيلة فعالة لجعل النموذج الأساسي لديه القدرة على الإجابة على الأسئلة الإنسانية.

لقد اعتمدنا قاعدة المعرفة الطبية الصينية المفتوحة والمصممة ذاتيا ، والتي تشير بشكل أساسي إلى CMEKG.

تم تصميم قاعدة المعرفة الطبية حول الأمراض ، والأدوية ، ومؤشرات الفحص ، وما إلى ذلك ، وتشمل الحقول المضاعفات ، العوامل عالية الخطورة ، الفحوصات النسيجية ، الأعراض السريرية ، علاج الدواء ، العلاج الإضافي ، إلخ. مثال قاعدة المعرفة على النحو التالي:

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

استخدمنا واجهة GPT3.5 لبناء بيانات سؤال وجواب حول قاعدة المعرفة الطبية وإعداد مجموعة متنوعة من النماذج السريعة للاستفادة الكاملة من المعرفة.

أمثلة بيانات مجموعة التدريب للحصول على تعليمات صقلها هي كما يلي:

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"

نحن نقدم مجموعة بيانات تدريب للنموذج ، مع ما مجموعه أكثر من 8000 قطعة. تجدر الإشارة إلى أنه على الرغم من أن بناء مجموعة التدريب يتضمن المعرفة ، إلا أنه لا تزال هناك أخطاء وعيوب. في المستقبل ، سوف نستخدم استراتيجيات أفضل للتكرار وتحديث مجموعة البيانات.

لا تزال جودة مجموعة بيانات صقل التعليمات المحدودة ، وسيتم تنفيذ التكرار في المستقبل. في الوقت نفسه ، لا يزال يتم فرز قاعدة المعرفة الطبية ورمز بناء مجموعة البيانات ، وسيتم إصدارها بعد اكتمال الفرز.

بالإضافة إلى ذلك ، قمنا بجمع الأدبيات الطبية الصينية حول أمراض سرطان الكبد في عام 2023 واستخدمنا واجهة GPT3.5 لإنشاء جولات متعددة من بيانات الأسئلة والأجوبة حول [الخلاصة] من الأدبيات الطبية. في ./data_literature/liver_cancer.json نحن نقدم أمثلة تدريب 1K. في الوقت الحاضر ، لا تزال جودة عينات التدريب محدودة. في المستقبل ، سنقوم بتكرار البيانات ونشرها إلى الجمهور في شكل公开数据集. أمثلة على عينات التدريب هي كما يلي:

حاليا ، نحن نفتح فقط المعلمات النموذجية للتدريب على المرض الفردي من "سرطان التهاب الكبد". في المستقبل ، نخطط لنشر مجموعات بيانات الحوار الطبي التي تتضمن استنتاجات الأدب وستدرب النماذج على 16 مرضًا يتعلق بـ "الكبد والبنكرياس".

للحصول على تفاصيل ، يرجى الرجوع إلى مقالتنا: "استكشاف الاستحواذ على المعرفة التفاعلية من الأدبيات الطبية للنماذج الكبيرة"

إذا كنت ترغب في ضبط نموذج اللغة الكبير باستخدام مجموعة البيانات الخاصة بك ، فيرجى إنشاء مجموعة البيانات الخاصة بك بالتنسيق في ./data/llama_data.json

قم بتشغيل البرنامج النصي Finetune

bash ./scripts/finetune.sh

أثناء عملية صقل التعليمات بناءً على نموذج LLAMA ، تدربنا على بطاقة رسومات A100-SXM-80GB. كانت جولات التدريب الكلية 10 جولات ، والتي استغرقت حوالي 2H17M. مع Batch_size = 128 ، تحتل ذاكرة الفيديو حوالي 40 جم. من المتوقع أن يتم دعم بطاقات الرسومات 3090/4090 (ذاكرة رسومات 24 جيجابايت) أو أعلى بشكل أفضل ، ويتم ضبط Batch_size وفقًا لحجم ذاكرة الرسومات.

بالنسبة لإعدادات مقياس الفائقة والإجراءات التجريبية ، يرجى الرجوع إلى رابط Wandb:

https://wandb.ai/thinksoso/llama_med/runs/a5wgcnzt/overview؟orkspace=user-thinkso

ملاحظة: تم اختباره في مارس 2023

| اختبار المدخلات | إخراج لاما | إخراج الألبكة | Bentsao Materia Medica |

|---|---|---|---|

| كان شياو تشانغ يشعر بالتوعك مؤخرًا ولديه أعراض مثل الخفقان وضيق التنفس. وجد الفحص البدني أن القلب قد تم توسيعه وأن النبض قد أضعف. | سؤال: كان شياو تشانغ يشعر بالتوعك مؤخرًا ولديه أعراض مثل الخفقان وضيق التنفس. وجد الفحص البدني أن القلب قد تم توسيعه وأن النبض قد أضعف. | في الآونة الأخيرة ، كان شياو تشانغ يشعر بعدم الارتياح وله أعراض مثل الانزعاج وضيق التنفس. يظهر الفحص البدني أن القلب موسع وأن العضلات ضعيفة. | قد يعاني Xiao Zhang من التهاب عضلة القلب ، لذلك يوصى بالذهاب إلى المستشفى للفحص والعلاج في أقرب وقت ممكن. تشمل خيارات العلاج الأدوية والعلاج الجراحي. |

| هل أسباب الجذام والربو الطفولة متسقة؟ | أسباب الربو والجذام عند الأطفال متسقة ، لكن أسباب الربو والجذام في الأطفال ليست متسقة | نعم ، الربو والأطفال لديهم أسباب مماثلة. | غير متناسق ، سبب الجذام هو عدوى الجذام ، في حين أن سبب الربو في الأطفال هو عوامل مثل الضعف في التغذية والتدخين. |

| طور مريض تورم مستمر ويرقان. بعد فحص التصوير ، مرض حجر القناة الكبدي. ما هي خطط العلاج التي يجب اتخاذها؟ | ما هي خطط العلاج التي يجب على المرضى الذين يعانون من مرض الحجر القناة الكبدي التي يعانون من ذلك؟ | يجب أن يخضع المرضى لمجموعة من الجراحة والعلاج الكيميائي. | بالنسبة لمرض حجر القناة الكبدي ، تشمل خطط العلاج العلاج الجراحي ، والعلاج الدوائي والعلاج المساعد. يجب تحديد خطة العلاج المحددة وفقًا للظروف المحددة للمريض. |

س: لماذا تم إعادة تسمية "Bencao"؟

ج: يتم تعديل اسم نموذج لغة مختبر SCIR ، واسم النموذج الطبي الصيني إلى "الطب العشبي المادي".

س: لماذا "هوا تو" بدلاً من "هوا تو"؟

ج: يطلق عليه "Camel" لأن نموذجنا الأساسي Llama هو Llama و Alpaca هو الألبكة. مستوحاة من أسمائهم وفون Homophonic Hua Tuo ، أطلقنا على طرازنا Hua Tuo.

س: هل هناك أي نظرية للطب الصيني التقليدي أو بيانات الطب الصيني التقليدي المستخدمة؟

ج: لا

س: نتائج تشغيل النموذج مختلفة وتكون التأثيرات محدودة

ج: نظرًا للنظر في التنوع التوليدي في النماذج التوليدية ، قد تختلف نتائج المسارات المتعددة. يقتصر نموذج المصدر المفتوح الحالي في مجموعة Llama و Alpaca الصينية وطريقة الجمع بين المعرفة قاسية نسبيًا ، يرجى تجربة النماذج القائمة على النوع القائم على الإزهار.

س: لا يمكن تشغيل النموذج/محتوى الاستدلال غير مقبول تمامًا

ج: يرجى تحديد التبعيات في المتطلبات المثبتة ، وتكوين بيئة CUDA وإضافة متغيرات البيئة ، وإدخال النموذج الذي تم تنزيله بشكل صحيح وموقع تخزين Lora ؛ إذا تم تكرار محتوى الاستدلال أو ينتمي بعض المحتوى الخاطئ إلى الظاهرة العرضية للنموذج المستند إلى LLAMA ، فسيكون له علاقة معينة مع القدرة الصينية لنموذج LLAMA ، ومقياس بيانات التدريب وإعدادات الفائقة. يرجى تجربة نموذج جديد يعتمد على النوع المنقول. إذا كانت هناك مشاكل خطيرة ، فيرجى وصف اسم ملف التشغيل واسم النموذج و Lora ومعلومات التكوين الأخرى في المشكلة بالتفصيل. شكرًا لك.

س: أي من النماذج العديدة التي تم إصدارها هي الأفضل؟

ج: وفقًا لتجربتنا ، يكون التأثير القائم على نموذج النوع المنقذ أفضل نسبيًا.

تم الانتهاء من هذا المشروع من قبل وانغ هاوشون ، دو يانروي ، ليو تشي ، باي روي ، سينوا ، تشن يوهان ، تشيانغ زوين ، تشن جيانيو ولي زيجيان ، مجموعة المخابرات الصحية في مركز الحوسبة الاجتماعية وإعادة المعلومات إلى معهد هاربين للتكنولوجيا. المدربون هم الأستاذ المشارك تشاو سينج ، البروفيسور تشين بينج والأستاذ ليو تينغ.

يشير هذا المشروع إلى مشاريع المصادر المفتوحة التالية ، ونود أن نعرب عن امتناننا للمشاريع ذات الصلة وموظفي البحث والتطوير.

الموارد المتعلقة بهذا المشروع مخصصة للبحث الأكاديمي فقط وهي محظورة بشكل صارم لأغراض تجارية. عند استخدام أجزاء تتضمن رمز الطرف الثالث ، يرجى متابعة بروتوكول المصدر المفتوح المقابل. يتأثر المحتوى الناتج عن النموذج بعوامل مثل حساب النماذج والعشوائية وخسائر الدقة الكمية ، ولا يمكن أن يضمن هذا المشروع دقته. يتم إنشاء معظم مجموعات البيانات في هذا المشروع بواسطة النماذج ولا يمكن استخدامها كأساس للتشخيص الطبي الفعلي حتى لو كانت تتوافق مع بعض الحقائق الطبية. لا يتحمل هذا المشروع أي مسؤولية قانونية عن أي إخراج للمحتوى حسب النموذج ، كما أنه لا يتحمل أي خسائر قد تنشأ عن استخدام الموارد ذات الصلة ونتائج الإخراج.

إذا كنت قد استخدمت البيانات أو رمز هذا المشروع ، أو أن عملنا مفيد لك ، فيرجى إعلان عرض أسعار

التقرير الفني للطبعة الأولى: Huatuo: ضبط نموذج Llama مع المعرفة الطبية الصينية

@misc{wang2023huatuo,

title={HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge},

author={Haochun Wang and Chi Liu and Nuwa Xi and Zewen Qiang and Sendong Zhao and Bing Qin and Ting Liu},

year={2023},

eprint={2304.06975},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

نماذج لغة كبيرة لضبط المعرفة مع قواعد المعرفة الطبية المنظمة لتوليد استجابة موثوقة باللغة الصينية

@misc{wang2023knowledgetuning,

title={Knowledge-tuning Large Language Models with Structured Medical Knowledge Bases for Reliable Response Generation in Chinese},

author={Haochun Wang and Sendong Zhao and Zewen Qiang and Zijian Li and Nuwa Xi and Yanrui Du and MuZhen Cai and Haoqiang Guo and Yuhan Chen and Haoming Xu and Bing Qin and Ting Liu},

year={2023},

eprint={2309.04175},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

مجموعة بيانات Calla: استحواذ المعرفة التفاعلية لـ LLMS من الأدب الطبي الصيني

@misc{du2023calla,

title={The CALLA Dataset: Probing LLMs' Interactive Knowledge Acquisition from Chinese Medical Literature},

author={Yanrui Du and Sendong Zhao and Muzhen Cai and Jianyu Chen and Haochun Wang and Yuhan Chen and Haoqiang Guo and Bing Qin},

year={2023},

eprint={2309.04198},

archivePrefix={arXiv},

primaryClass={cs.CL}

}