중국어 | 영어

이 프로젝트는 LLAMA, Alpaca-Chinese, Bloom, Movable Type Models 등을 포함한 중국 의료 지침에서 미세 조정/지시 조정 된 대형 언어 모델 세트의 출처를 열어줍니다.

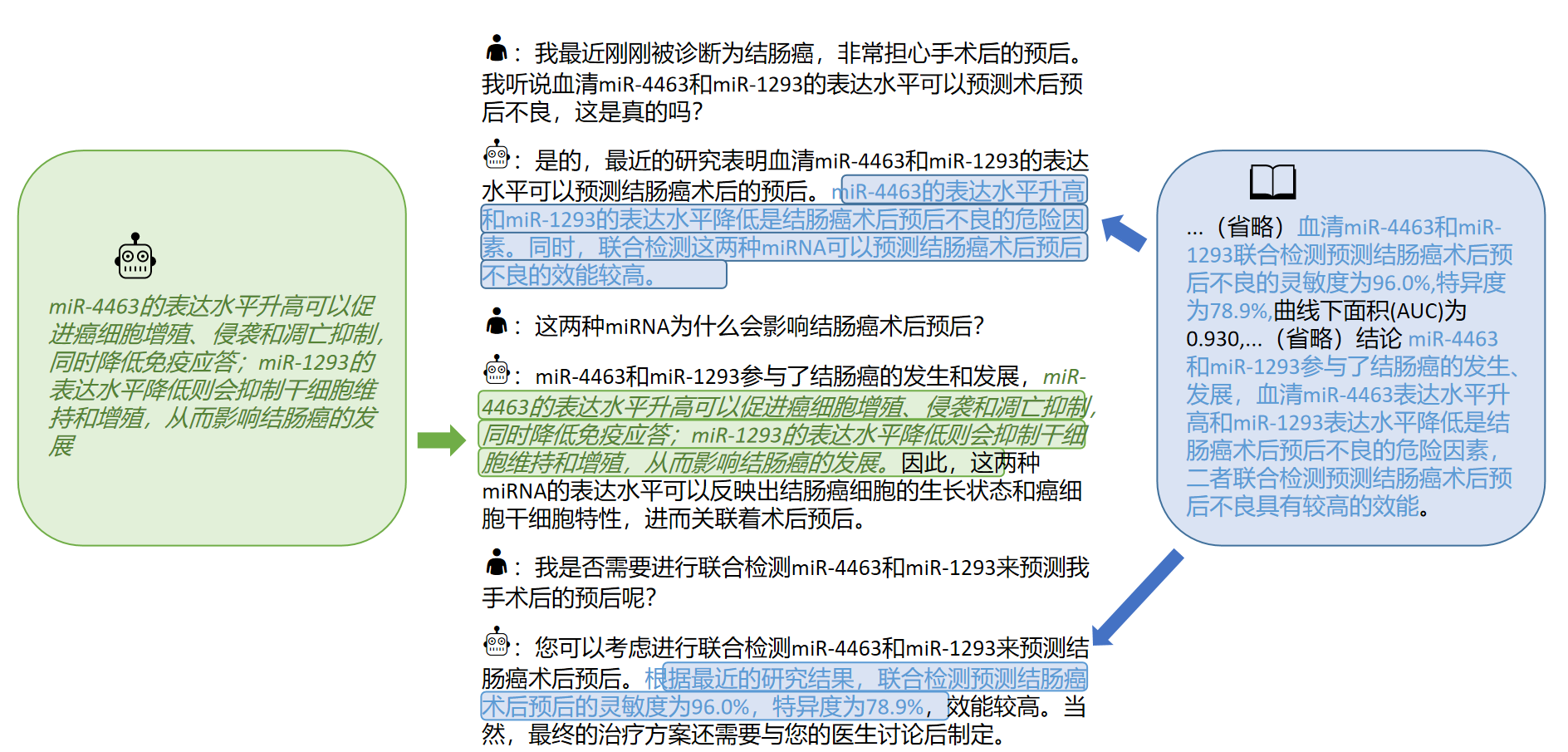

의료 지식 그래프 및 의학 문헌을 기반으로 ChatGpt API와 결합하여 중국 의료 지침 미세 조정 데이터 세트를 구성하고 다양한 기본 모델의 지침을 미세 조정하여 의료 분야에서 기본 모델의 질문 및 대답 효과를 개선했습니다.

[2023/09/24] 릴리스 "스마트 헬스 케어를위한 빅 언어 모델 미세 조정 기술"

[2023/09/12] 릴리스 "ARXIV에서"의학 문학으로부터의 대화식 지식의 획득 "

[2023/09/08] 릴리스 "지식을 기반으로 한 대형 언어 모델에 대한 신뢰할 수있는 중국 의료 답변 세대 방법"ARXIV에서

[2023/08/07] 이동식 유형을 기반으로 한 모델 릴리스가 추가되고 모델 효과가 크게 향상됩니다.

[2023/08/05] 허브 모델은 CCL 2023 데모 트랙에 나와 있습니다.

[2023/08/03] SCIR Laboratory의 오픈 소스 이동식 유형 일반 질문 및 답변 모델, 팔로우하는 데 오신 것을 환영합니다.

[2023/07/19]는 Bloom을 기반으로 미세 조정 지침 모델을 추가했습니다.

[2023/05/12]이 모델은 "Hua Tuo"에서 "Bencao"로 바뀌었다.

[2023/04/28]는 미세 조정 지침을위한 중국 알파카 대형 모델을 기반으로 한 모델 릴리스를 추가했습니다.

[2023/04/24]는 LLAMA 및 의학 문헌을 기반으로 미세 조정 지침 모델을 추가했습니다.

[2023/03/31]는 LLAMA 및 의료 지식 기반을 기반으로 미세 조정 지침에 대한 모델 릴리스를 추가했습니다.

먼저 종속성 패키지를 설치하십시오. Python Environment는 3.9+를 권장합니다

pip install -r requirements.txt

모든 기본 모델의 경우 컴퓨팅 리소스 및 모델 성능을 평가하기위한 미세 조정 교육을위한 하프 프리렉션 기본 모델 LORA 미세 조정 방법을 채택합니다.

Lora 웨이트는 Baidu Netdisk 또는 Hugging Face를 통해 다운로드 할 수 있습니다.

로라 무게를 다운로드하고 압축 압축을 다운로드하십시오. 압축 압축 형식은 다음과 같습니다.

**lora-folder-name**/

- adapter_config.json # LoRA权重配置文件

- adapter_model.bin # LoRA权重文件

동일한 데이터를 기반으로 Chatglm 모델의 의료 버전을 교육했습니다 : Chatglm-6b-Med

우리는 다른 데이터 세트로 대체 할 수있는 ./data/infer.json 의 일부 테스트 사례를 제공합니다. 형식은 일관성이 있습니다.

LELS 스크립트를 실행하십시오

#基于医学知识库

bash ./scripts/infer.sh

#基于医学文献

#单轮

bash ./scripts/infer-literature-single.sh

#多轮

bash ./scripts/infer-literature-multi.sh

ult.sh 스크립트 코드는 다음과 같습니다. 기본 모델 Base_Model, LORA Weight LORA_WEAGET 및 TEST DATASET PATH ORSTRUCT_DIR을 다음 코드로 교체하고 기본 모델 BASE_MODEL, LORA 가중치 LORA_WEAGHTS 및 테스트 데이터 세트 PATH instruct_dir를 교체 한 후 실행하십시오.

python infer.py

--base_model 'BASE_MODEL_PATH'

--lora_weights 'LORA_WEIGHTS_PATH'

--use_lora True

--instruct_dir 'INFER_DATA_PATH'

--prompt_template 'TEMPLATE_PATH'

프롬프트 템플릿의 선택은 모델과 관련이 있으며 세부 사항은 다음과 같습니다.

| 이동식 유형 및 꽃 | 라마 & 알파카 |

|---|---|

templates/bloom_deploy.json | 의료 지식 기반 templates/med_template.json 기반으로합니다의학 문헌 templates/literature_template.json |

./scripts/test.sh 를 참조 할 수도 있습니다

기본 모델은 의료 Q & A 시나리오에 제한된 영향을 미치며, 교육용 미세 조정은 기본 모델이 인간의 질문에 대답 할 수있는 효율적인 방법입니다.

우리는 주로 CMEKG를 언급하는 개방적이고 자체적으로 구축 된 중국 의료 지식 기반을 채택했습니다.

의료 지식 기반은 질병, 약물, 검사 지표 등을 중심으로 구축되며,이 분야에는 합병증, 고위험 요인, 조직 학적 검사, 임상 증상, 약물 치료, 보조 치료 등이 포함됩니다. 지식 기반 예는 다음과 같습니다.

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

우리는 GPT3.5 인터페이스를 사용하여 의료 지식 기반 주위에 Q & A 데이터를 구축하고 지식을 최대한 활용하기 위해 다양한 프롬프트 양식을 설정했습니다.

미세 조정 지침에 대한 교육 세트 데이터 예제는 다음과 같습니다.

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"

우리는 총 8,000 개 이상의 모델의 교육 데이터 세트를 제공합니다. 훈련 세트의 구성에는 지식이 포함되어 있지만 여전히 오류와 불완전 성이 있습니다. 앞으로 더 나은 전략을 사용하여 데이터 세트를 반복하고 업데이트 할 것입니다.

지침 미세 조정 데이터 세트의 품질은 여전히 제한되어 있으며 반복은 향후에 수행 될 것입니다. 동시에 의료 지식 기반 및 데이터 세트 구성 코드는 여전히 정렬되고 있으며 정렬이 완료된 후에 출시됩니다.

또한, 우리는 2023 년 간암 질환에 대한 중국 의학 문헌을 수집하고 GPT3.5 인터페이스를 사용하여 의학 문헌의 [결론]에 대한 여러 라운드의 질문 및 답변 데이터를 구성했습니다. · ./data_literature/liver_cancer.json 에서 1K 교육 예제를 제공합니다. 현재, 훈련 샘플의 품질은 여전히 제한되어있다. 앞으로 우리는 데이터를 더욱 반복하여公开数据集의 형태로 대중에게 게시 할 것입니다. 훈련 샘플의 예는 다음과 같습니다.

현재, 우리는 "간염 암"의 단일 질병 훈련을위한 모델 매개 변수 만 열립니다. 앞으로, 우리는 문헌 결론을 포함하는 의료 대화 데이터 세트를 출판 할 계획이며 "간장 및 췌장"과 관련된 16 개의 질병에 대한 모델을 훈련시킬 계획입니다.

자세한 내용은 다음과 같은 기사를 참조하십시오.

자신의 데이터 세트로 대형 언어 모델을 미세 조정하려면 ./data/llama_data.json 의 형식으로 자신의 데이터 세트를 작성하십시오.

Finetune 스크립트를 실행하십시오

bash ./scripts/finetune.sh

LLAMA 모델을 기반으로 한 지침 미세 조정 프로세스 동안 A100-SXM-80GB 그래픽 카드를 교육했습니다. 총 훈련 라운드는 10 라운드로 약 2H17m가 걸렸습니다. batch_size = 128을 사용하면 비디오 메모리가 약 40g을 차지합니다. 3090/4090 그래픽 카드 (24GB 그래픽 메모리) 이상을 더 잘 지원할 수 있으며 Batch_Size는 그래픽 메모리의 크기에 따라 조정됩니다.

초 파라미터 설정 및 실험 절차는 Wandb의 링크를 참조하십시오.

https://wandb.ai/thinksoso/llama_med/runs/a5wgcnzt/overview?workspace=user-thinksoso

참고 : 2023 년 3 월에 테스트

| 테스트 입력 | 라마 출력 | 알파카 출력 | Bentsao Materia Medica |

|---|---|---|---|

| Xiao Zhang은 최근에 기분이 좋지 않으며 두근 두근 및 호흡 곤란과 같은 증상이 있습니다. 신체 검사에 따르면 심장이 커지고 맥동이 약화 된 것으로 나타났습니다. | 질문 : Xiao Zhang은 최근에 기분이 좋지 않으며 촉진 및 호흡 곤란과 같은 증상이 있습니다. 신체 검사에 따르면 심장이 커지고 맥동이 약화 된 것으로 나타났습니다. | 최근 Xiao Zhang은 불편한 느낌을 받았으며 화가 나 호흡 곤란과 같은 증상이 있습니다. 신체 검사에 따르면 심장이 커지고 근육이 약한 것으로 나타났습니다. | Xiao Zhang은 심근염으로 고통받을 수 있으므로 가능한 빨리 검사 및 치료를 위해 병원에 가야합니다. 치료 옵션에는 약물 및 외과 치료가 포함됩니다. |

| 나병과 어린 시절 천식의 원인이 일관되게됩니까? | 어린이의 천식과 나병의 원인은 일관되지만 어린이의 천식과 나병의 원인은 일관성이 없습니다. | 예, 천식과 아이들은 비슷한 원인을 가지고 있습니다. | 일관되지 않은 나병의 원인은 나병 감염이며, 어린이의 천식의 원인은 먹이와 흡연과 같은 요인입니다. |

| 환자는 지속적인 붓기와 황달이 발생했습니다. 영상 검사 후, 간장 덕트 석재 질환. 어떤 치료 계획을 세워야합니까? | 간장 덕트 스톤 병 환자는 어떤 치료 계획을 취해야합니까? | 환자는 수술과 화학 요법의 조합을 받아야합니다. | 간장 덕트 석재 질환의 경우, 치료 계획에는 외과 적 치료, 약물 치료 및 보조 치료가 포함됩니다. 특정 치료 계획은 환자의 특정 상황에 따라 결정되어야합니다. |

Q : 왜 "Bencao"라는 이름이 바뀌 었습니까?

A : SCIR 실험실의 큰 언어 모델의 이름 일관성과 중국 의료 모델의 이름은 "물질 허브 의학"에 맞게 조정됩니다.

Q : 왜 "hua tuo"대신 "hua tuo"입니까?

A : 기본 모델 라마는 라마이고 알파카는 알파카이기 때문에 "낙타"라고합니다. 그들의 이름과 Hua Tuo의 Homophonic Phon에서 영감을 얻은 우리는 모델 Hua Tuo를 지명했습니다.

Q : 전통 중국 의약 이론이나 전통 중국 의약 데이터가 사용 되었습니까?

A : 아니요

Q : 모델 실행 결과는 다르고 효과가 제한됩니다.

A : 생성 모델의 생성 다양성을 고려하기 때문에 여러 실행 결과가 다를 수 있습니다. 현재 오픈 소스 모델은 Llama와 Alpaca의 중국 코퍼스에서 제한되며 지식을 결합하는 방법은 비교적 거칠으며 Bloom 기반 및 이동식 유형 기반 모델을 사용해보십시오.

Q : 모델은 실행할 수 없습니다/추론 내용은 완전히 용납 할 수 없습니다.

A : 설치된 요구 사항의 종속성을 결정하고 CUDA 환경을 구성하며 환경 변수를 추가하고 다운로드 된 모델 및 LORA 스토리지 위치를 올바르게 입력하십시오. 추론 내용이 복제되거나 일부 잘못된 내용이 LLAMA 기반 모델의 가끔 현상에 속하는 경우 LLAMA 모델의 중국 능력, 교육 데이터 척도 및 하이퍼 파라미터 설정과 특정 관계가 있습니다. 이동식 유형을 기반으로 새 모델을 사용해보십시오. 심각한 문제가있는 경우 문제의 실행중인 파일 이름, 모델 이름, LORA 및 기타 구성 정보를 자세히 설명하십시오. 감사합니다.

Q : 출시 된 몇 가지 모델 중 최고는 무엇입니까?

A : 우리의 경험에 따르면, 이동식 유형 모델을 기반으로 한 효과는 비교적 우수합니다.

이 프로젝트는 Wang Haochun, du Yanrui, Liu Chi, Bai Rui, Cinuwa, Chen Yuhan, Qiang Zewen, Chen Jianyu 및 Li Zijian에 의해 완료되었습니다. 강사는 Zhao Sendong 부교수, Qin Bing 교수 및 Liu Ting 교수입니다.

이 프로젝트는 다음과 같은 오픈 소스 프로젝트를 말하며 관련 프로젝트 및 연구 개발 직원에게 감사를 표하고 싶습니다.

이 프로젝트와 관련된 자료는 학업 연구를위한 것이며 상업적 목적으로 엄격하게 금지되어 있습니다. 타사 코드와 관련된 부품을 사용하는 경우 해당 오픈 소스 프로토콜을 엄격히 따르십시오. 모델에 의해 생성 된 내용은 모델 계산, 임의성 및 정량적 정확도 손실과 같은 요소에 의해 영향을 받으며이 프로젝트는 정확도를 보장 할 수 없습니다. 이 프로젝트의 대부분의 데이터 세트는 모델에 의해 생성되며 특정 의료 사실을 준수하더라도 실제 의료 진단의 기초로 사용할 수 없습니다. 이 프로젝트는 모델의 컨텐츠 출력에 대한 법적 책임을지지 않으며 관련 리소스 및 출력 결과를 사용하여 발생할 수있는 손실에 대해 책임을지지 않습니다.

이 프로젝트의 데이터 또는 코드를 사용했거나 당사의 작업이 도움이된다면 견적을 선언하십시오.

초판 기술 보고서 : Huatuo : 중국의 의료 지식으로 라마 모델을 튜닝

@misc{wang2023huatuo,

title={HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge},

author={Haochun Wang and Chi Liu and Nuwa Xi and Zewen Qiang and Sendong Zhao and Bing Qin and Ting Liu},

year={2023},

eprint={2304.06975},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

중국어의 신뢰할 수있는 응답 생성을위한 구조화 된 의료 지식 기반을 가진 지식 조정 대형 언어 모델

@misc{wang2023knowledgetuning,

title={Knowledge-tuning Large Language Models with Structured Medical Knowledge Bases for Reliable Response Generation in Chinese},

author={Haochun Wang and Sendong Zhao and Zewen Qiang and Zijian Li and Nuwa Xi and Yanrui Du and MuZhen Cai and Haoqiang Guo and Yuhan Chen and Haoming Xu and Bing Qin and Ting Liu},

year={2023},

eprint={2309.04175},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Calla 데이터 세트 : 중국 의학 문헌에서 LLMS의 대화식 지식 습득 조사

@misc{du2023calla,

title={The CALLA Dataset: Probing LLMs' Interactive Knowledge Acquisition from Chinese Medical Literature},

author={Yanrui Du and Sendong Zhao and Muzhen Cai and Jianyu Chen and Haochun Wang and Yuhan Chen and Haoqiang Guo and Bing Qin},

year={2023},

eprint={2309.04198},

archivePrefix={arXiv},

primaryClass={cs.CL}

}