Cina | Bahasa inggris

Proyek ini membuka sumber set model bahasa besar yang telah disempurnakan/penyetelan instruksi dalam instruksi medis Tiongkok, termasuk Llama, alpaca-Cina, mekar, model tipe bergerak, dll.

Berdasarkan grafik pengetahuan medis dan literatur medis, kami dikombinasikan dengan chatgpt API untuk membangun set data penyempurnaan instruksi medis Tiongkok, dan menggunakan ini untuk menyempurnakan instruksi dari berbagai model dasar, meningkatkan efek tanya jawab dari model dasar di bidang medis.

[2023/09/24] Rilis "Teknologi Fine-Tuning Model Bahasa Besar untuk Perawatan Kesehatan Cerdas"

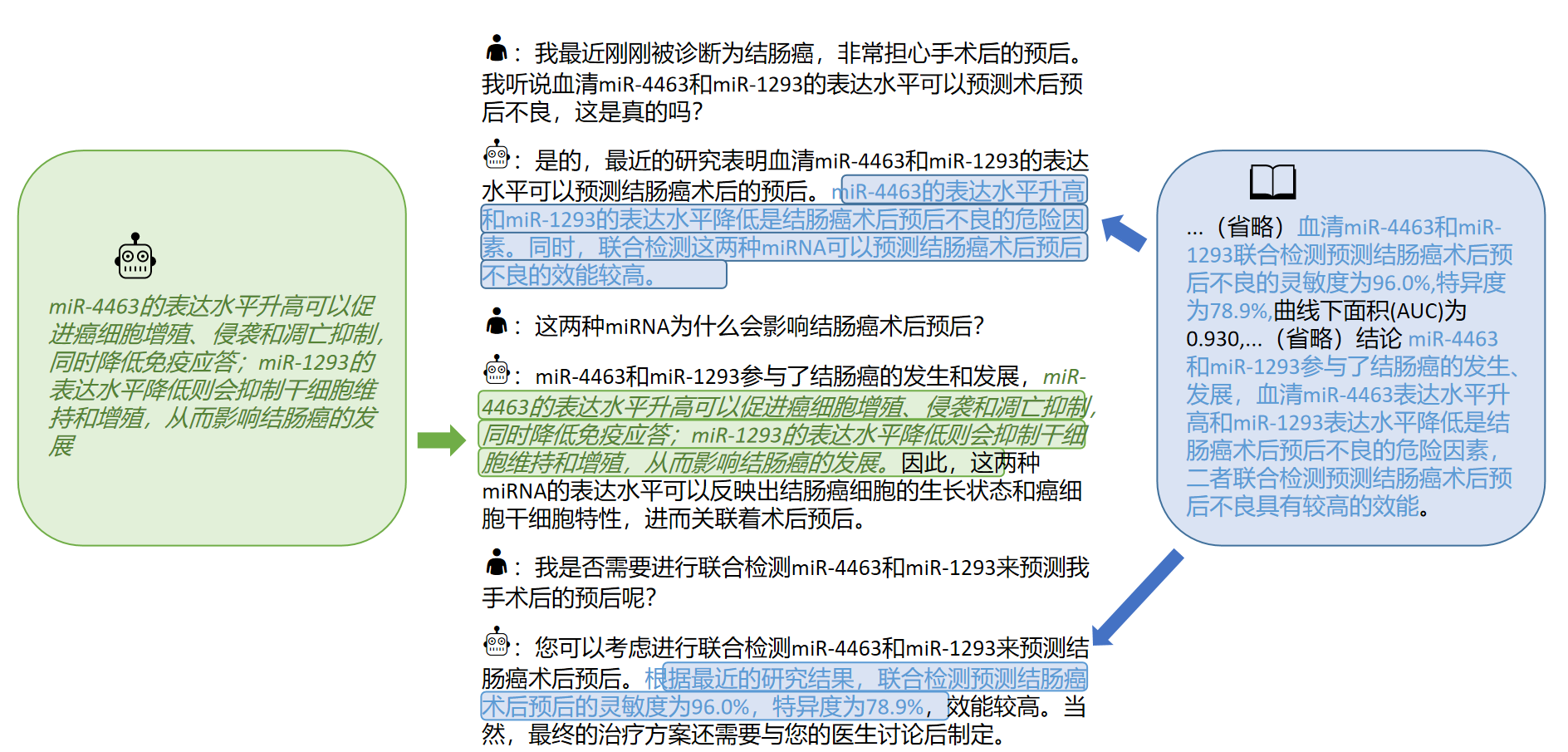

[2023/09/12] Rilis "Menjelajahi akuisisi pengetahuan interaktif dari literatur medis oleh model besar" di arxiv

[2023/09/08] Rilis "Metode Pembalasan Medis Medis Tiongkok yang andal untuk Model Bahasa Besar Berdasarkan Kesempurnaan Pengetahuan" di ARXIV

[2023/08/07] Rilis model yang didasarkan pada tipe bergerak ditambahkan, dan efek model meningkat secara signifikan.

[2023/08/05] Model herbal disajikan pada trek demo CCL 2023.

[2023/08/03] SCIR Open Source Open Source Type Umum Laboratorium Jawaban dan Jawaban Model, selamat datang untuk mengikuti ??

[2023/07/19] menambahkan model untuk instruksi penyempurnaan berdasarkan mekar.

[2023/05/12] Model ini berganti nama menjadi "Bencao" dari "Hua Tuo".

[2023/04/28] menambahkan rilis model berdasarkan model besar Alpaca Cina untuk instruksi penyesuaian.

[2023/04/24] menambahkan model untuk instruksi penyempurnaan berdasarkan llama dan literatur medis.

[2023/03/31] menambahkan rilis model untuk instruksi penyempurnaan berdasarkan Llama dan basis pengetahuan medis.

Pertama -tama instal paket ketergantungan, Python Environment merekomendasikan 3.9+

pip install -r requirements.txt

Untuk semua model dasar, kami mengadopsi model fine-tuning model setengah presisi untuk pelatihan penyempurnaan instruksi untuk menimbang sumber daya komputasi dan model kinerja.

Lora Weights dapat diunduh melalui Baidu Netdisk atau Face Hugging:

Unduh Lora Weight dan Decompress. Format dekompresi adalah sebagai berikut:

**lora-folder-name**/

- adapter_config.json # LoRA权重配置文件

- adapter_model.bin # LoRA权重文件

Berdasarkan data yang sama, kami juga melatih versi medis model chatglm: chatglm-6b-med

Kami menyediakan beberapa kasus uji di ./data/infer.json , yang dapat diganti dengan set data lainnya. Harap dicatat bahwa formatnya konsisten.

Jalankan skrip infer

#基于医学知识库

bash ./scripts/infer.sh

#基于医学文献

#单轮

bash ./scripts/infer-literature-single.sh

#多轮

bash ./scripts/infer-literature-multi.sh

Kode skrip infer.sh adalah sebagai berikut. Harap ganti model base base_model, lora weight lora_weights dan uji jalur dataset Instruktur_dir dalam kode berikut dan jalankan setelah mengganti model base base_model, lora weight lora_weights, dan uji jalur dataset Instruktur_dir.

python infer.py

--base_model 'BASE_MODEL_PATH'

--lora_weights 'LORA_WEIGHTS_PATH'

--use_lora True

--instruct_dir 'INFER_DATA_PATH'

--prompt_template 'TEMPLATE_PATH'

Pilihan templat prompt terkait dengan model, detailnya adalah sebagai berikut:

| Tipe & Mekar Bergerak | Llama & Alpaca |

|---|---|

templates/bloom_deploy.json | Berdasarkan templates/med_template.jsonBerdasarkan templates/literature_template.json |

Anda juga dapat merujuk ke ./scripts/test.sh

Model dasar memiliki efek terbatas dalam skenario T&J medis, dan penyempurnaan instruksi adalah cara yang efisien untuk membuat model dasar memiliki kemampuan untuk menjawab pertanyaan manusia.

Kami telah mengadopsi basis pengetahuan medis Tiongkok yang terbuka dan dibangun sendiri, terutama merujuk pada CMEKG.

Basis pengetahuan medis dibangun di sekitar penyakit, obat-obatan, indikator pemeriksaan, dll., Dan bidang termasuk komplikasi, faktor risiko tinggi, pemeriksaan histologis, gejala klinis, perawatan obat, perawatan tambahan, dll. Contoh basis pengetahuan adalah sebagai berikut:

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

Kami menggunakan antarmuka GPT3.5 untuk membangun data tanya jawab di sekitar basis pengetahuan medis dan mengatur berbagai bentuk cepat untuk memanfaatkan pengetahuan penuh.

Contoh data yang ditetapkan pelatihan untuk instruksi penyesuaian adalah sebagai berikut:

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"

Kami memberikan dataset pelatihan model, dengan total lebih dari 8.000 buah. Perlu dicatat bahwa meskipun konstruksi set pelatihan menggabungkan pengetahuan, masih ada kesalahan dan ketidaksempurnaan. Di masa depan, kami akan menggunakan strategi yang lebih baik untuk mengulangi dan memperbarui dataset.

Kualitas set data penyempurnaan instruksi masih terbatas, dan iterasi akan dilakukan di masa depan. Pada saat yang sama, basis pengetahuan medis dan kode konstruksi set data masih diselesaikan, dan akan dirilis setelah penyortiran selesai.

Selain itu, kami mengumpulkan literatur medis Tiongkok tentang penyakit kanker hati pada tahun 2023 dan menggunakan antarmuka GPT3.5 untuk membangun beberapa putaran data tanya jawab di sekitar [kesimpulan] literatur medis. Dalam · ./data_literature/liver_cancer.json kami memberikan contoh pelatihan 1K. Saat ini, kualitas sampel pelatihan masih terbatas. Di masa depan, kami akan lebih lanjut mengulang data dan mempublikasikannya kepada publik dalam bentuk公开数据集. Contoh sampel pelatihan adalah sebagai berikut:

Saat ini, kami hanya membuka parameter model untuk pelatihan penyakit tunggal "kanker hepatitis". Di masa depan, kami berencana untuk menerbitkan kumpulan data dialog medis yang menggabungkan kesimpulan literatur dan akan melatih model untuk 16 penyakit yang terkait dengan "hepatobilier dan pankreas".

Untuk detailnya, silakan merujuk ke artikel kami: "Menjelajahi akuisisi pengetahuan interaktif dari literatur medis untuk model besar"

Jika Anda ingin menyempurnakan model bahasa besar dengan dataset Anda sendiri, silakan bangun dataset Anda sendiri dalam format di ./data/llama_data.json

Jalankan skrip finetune

bash ./scripts/finetune.sh

Selama proses penyempurnaan instruksi berdasarkan model LLAMA, kami berlatih pada kartu grafis A100-SXM-80GB. Total putaran pelatihan adalah 10 putaran, yang memakan waktu sekitar 2h17m. Dengan Batch_Size = 128, memori video menempati sekitar 40g. Diharapkan bahwa kartu grafis 3090/4090 (memori grafis 24GB) atau di atasnya dapat didukung lebih baik, dan Batch_Size disesuaikan sesuai dengan ukuran memori grafis.

Untuk pengaturan hiperparameter dan prosedur eksperimental, silakan merujuk ke tautan Wandb:

https://wandb.ai/thinksoso/llama_med/runs/a5wgcnzt/overview?workspace=user-thinksoso

Catatan: Diuji pada bulan Maret 2023

| Input tes | Output llama | Output alpaca | Bentsao Materia Medica |

|---|---|---|---|

| Xiao Zhang merasa tidak sehat baru -baru ini dan memiliki gejala seperti jantung berdebar dan sesak napas. Pemeriksaan fisik menemukan bahwa jantung diperbesar dan denyutnya melemah. | Pertanyaan: Xiao Zhang merasa tidak sehat baru -baru ini dan memiliki gejala seperti jantung berdebar dan sesak napas. Pemeriksaan fisik menemukan bahwa jantung diperbesar dan denyutnya melemah. | Baru -baru ini, Xiao Zhang merasa tidak nyaman dan memiliki gejala seperti kesal dan sesak napas. Pemeriksaan fisik menunjukkan bahwa jantung membesar dan otot -ototnya lemah. | Xiao Zhang mungkin menderita miokarditis, jadi disarankan untuk pergi ke rumah sakit untuk pemeriksaan dan perawatan sesegera mungkin. Pilihan pengobatan termasuk pengobatan dan perawatan bedah. |

| Apakah penyebab kusta dan asma masa kanak -kanak konsisten? | Penyebab asma dan kusta pada anak -anak konsisten, tetapi penyebab asma dan kusta pada anak -anak tidak konsisten | Ya, asma dan anak -anak memiliki penyebab serupa. | Tidak konsisten, penyebab kusta adalah infeksi kusta, sedangkan penyebab asma pada anak -anak adalah faktor seperti pemberian makan yang buruk dan merokok. |

| Seorang pasien mengalami pembengkakan dan penyakit kuning persisten. Setelah pemeriksaan pencitraan, penyakit batu saluran hepatobiliary. Rencana perawatan apa yang harus diambil? | Apa rencana perawatan yang harus diambil pasien dengan penyakit batu saluran hepatobilier? | Pasien harus menjalani kombinasi operasi dan kemoterapi. | Untuk penyakit batu saluran hepatobiliary, rencana pengobatan termasuk perawatan bedah, perawatan obat dan perawatan tambahan. Rencana perawatan spesifik perlu ditentukan sesuai dengan keadaan spesifik pasien. |

T: Mengapa itu berganti nama menjadi "Bencao"?

A: Nama konsistensi model bahasa besar Laboratorium SCIR, dan nama model medis Tiongkok disesuaikan dengan "obat -obatan herbal material".

T: Mengapa itu "hua tuo" bukan "hua tuo"?

A: Ini disebut "unta" karena model dasar kami adalah llama dan alpaca adalah alpaca. Terinspirasi oleh nama mereka dan phon homofonik Hua Tuo, kami menamai model kami Hua Tuo.

T: Apakah ada teori obat tradisional Tiongkok atau data obat tradisional Tiongkok yang digunakan?

A: Tidak

T: Hasil model berjalan berbeda dan efeknya terbatas

A: Karena pertimbangan keanekaragaman generatif dalam model generatif, hasil beberapa kali berjalan dapat bervariasi. Model open source saat ini terbatas dalam korpus Cina dari Llama dan Alpaca dan cara menggabungkan pengetahuan relatif kasar, silakan coba model berbasis tipe berbasis mekar dan bergerak.

T: Model tidak dapat berjalan/konten inferensi sama sekali tidak dapat diterima

A: Harap tentukan dependensi dalam persyaratan yang diinstal, konfigurasikan lingkungan CUDA dan tambahkan variabel lingkungan, masukkan model yang diunduh dan lokasi penyimpanan LORA dengan benar; Jika konten inferensi digandakan atau beberapa konten yang salah termasuk dalam fenomena sesekali dari model berbasis Llama, ia memiliki hubungan tertentu dengan kemampuan Cina dari model LLAMA, skala data pelatihan dan pengaturan hyperparameter. Silakan coba model baru berdasarkan jenis bergerak. Jika ada masalah serius, jelaskan nama file yang sedang berjalan, nama model, LORA dan informasi konfigurasi lainnya dalam masalah ini secara rinci. Terima kasih.

T: Manakah dari beberapa model yang dirilis yang terbaik?

A: Menurut pengalaman kami, efek berdasarkan model tipe bergerak relatif lebih baik.

Proyek ini diselesaikan oleh Wang Haochun, Du Yanrui, Liu Chi, Bai Rui, Cinuwa, Chen Yuhan, Qiang Zewen, Chen Jianyu dan Li Zijian, kelompok intelijen kesehatan dari Pusat Komputasi Sosial dan Pengambilan Informasi dari Harbin Institute of Technology. Instrukturnya adalah Associate Professor Zhao Sendong, Profesor Qin Bing dan Profesor Liu Ting.

Proyek ini mengacu pada proyek sumber terbuka berikut, dan kami ingin mengucapkan terima kasih kepada proyek yang relevan dan staf penelitian dan pengembangan.

Sumber daya yang terkait dengan proyek ini hanya untuk penelitian akademik dan dilarang ketat untuk tujuan komersial. Saat menggunakan bagian yang melibatkan kode pihak ketiga, silakan ikuti protokol open source yang sesuai. Konten yang dihasilkan oleh model dipengaruhi oleh faktor -faktor seperti perhitungan model, keacakan dan kerugian akurasi kuantitatif, dan proyek ini tidak dapat menjamin keakuratannya. Sebagian besar set data dari proyek ini dihasilkan oleh model dan tidak dapat digunakan sebagai dasar untuk diagnosis medis yang sebenarnya bahkan jika mereka mematuhi fakta medis tertentu. Proyek ini mengasumsikan tidak ada kewajiban hukum untuk setiap output konten oleh model, juga tidak bertanggung jawab atas kerugian yang mungkin timbul dari penggunaan sumber daya yang relevan dan hasil output.

Jika Anda telah menggunakan data atau kode proyek ini, atau pekerjaan kami bermanfaat bagi Anda, silakan nyatakan penawaran

Laporan Teknis Edisi Pertama: Huatuo: Tuning Llama Model dengan Pengetahuan Medis Tiongkok

@misc{wang2023huatuo,

title={HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge},

author={Haochun Wang and Chi Liu and Nuwa Xi and Zewen Qiang and Sendong Zhao and Bing Qin and Ting Liu},

year={2023},

eprint={2304.06975},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Tuning Pengetahuan Model Bahasa Besar dengan Basis Pengetahuan Medis Terstruktur untuk Generasi Respons yang Dapat Diandalkan dalam bahasa Cina

@misc{wang2023knowledgetuning,

title={Knowledge-tuning Large Language Models with Structured Medical Knowledge Bases for Reliable Response Generation in Chinese},

author={Haochun Wang and Sendong Zhao and Zewen Qiang and Zijian Li and Nuwa Xi and Yanrui Du and MuZhen Cai and Haoqiang Guo and Yuhan Chen and Haoming Xu and Bing Qin and Ting Liu},

year={2023},

eprint={2309.04175},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Dataset Calla: Probing LLMS 'Akuisisi Pengetahuan Interaktif dari Literatur Medis Tiongkok

@misc{du2023calla,

title={The CALLA Dataset: Probing LLMs' Interactive Knowledge Acquisition from Chinese Medical Literature},

author={Yanrui Du and Sendong Zhao and Muzhen Cai and Jianyu Chen and Haochun Wang and Yuhan Chen and Haoqiang Guo and Bing Qin},

year={2023},

eprint={2309.04198},

archivePrefix={arXiv},

primaryClass={cs.CL}

}