中国語|英語

このプロジェクトは、Llama、Alpaca-Chinese、Bloom、Movable Type Modelsなど、中国の医療指示で微調整/命令調整された大規模な言語モデルセットのソースを開きます。

医療知識のグラフと医学文献に基づいて、CHATGPT APIと組み合わせて中国の医療指導の微調整データセットを構築し、これを使用してさまざまな基本モデルの指示を微調整し、医療分野の基本モデルの質と回答効果を改善しました。

[2023/09/24]「スマートヘルスケア向けのビッグ言語モデル微調整技術」をリリースする

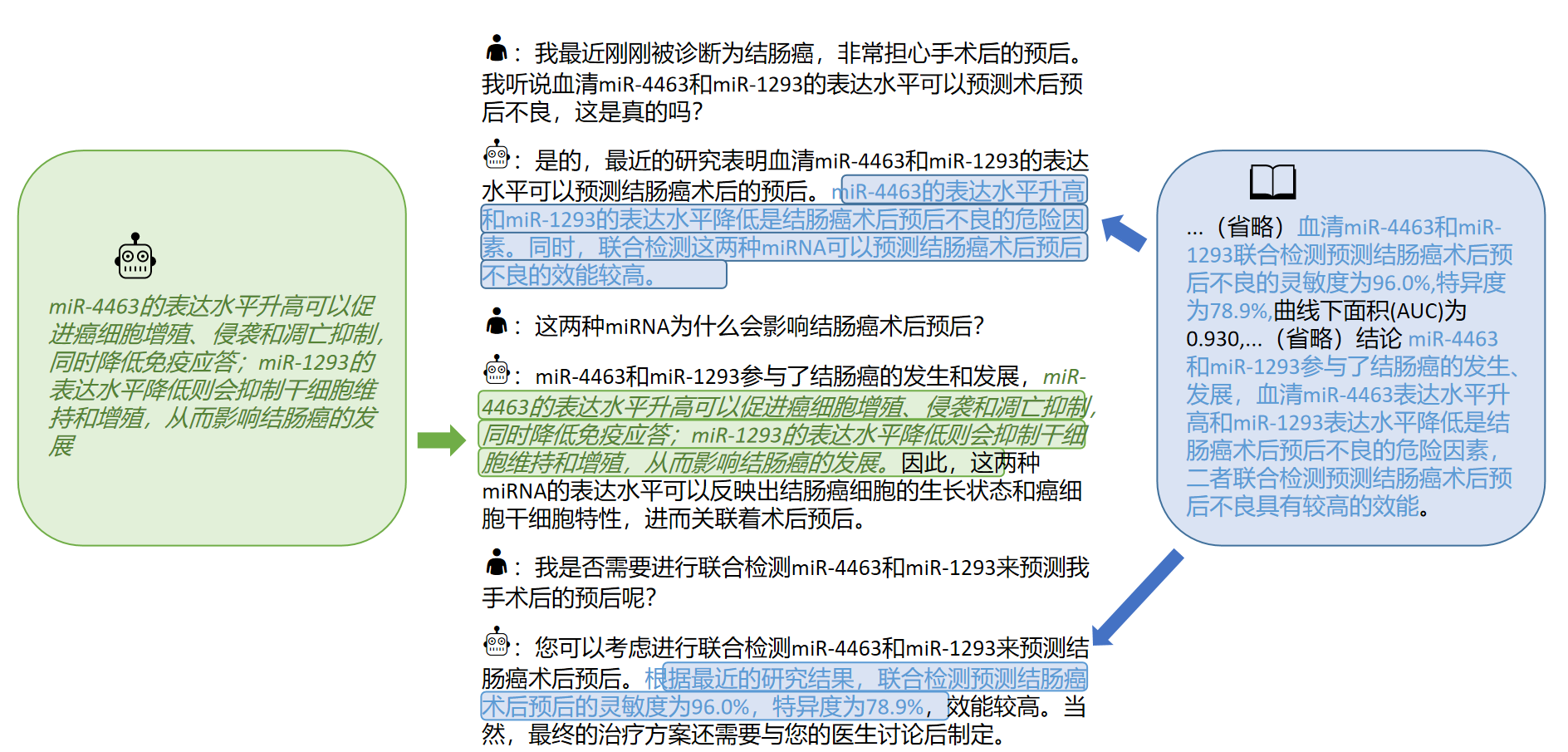

[2023/09/12] ARXIVに関する「大きなモデルによる医学文献からのインタラクティブな知識の獲得の探求」リリース

[2023/09/08] ARXIVで「知識に基づく大規模な言語モデルの信頼できる中国の医療応答生成方法」をリリースする

[2023/08/07]可動型に基づくモデルリリースが追加され、モデル効果が大幅に改善されます。

[2023/08/05]ハーブモデルは、CCL 2023デモトラックで提示されています。

[2023/08/03] Scir Laboratoryのオープンソース移動可能なタイプの一般的な質問と回答モデル、Welcome To Follow ??

[2023/07/19]は、Bloomに基づいた微調整指示のモデルを追加しました。

[2023/05/12]モデルは「Hua Tuo」から「Bencao」と改名されました。

[2023/04/28]は、微調整指示のために中国のアルパカビッグモデルに基づいたモデルリリースを追加しました。

[2023/04/24]は、ラマと医学文献に基づいた微調整指導のモデルを追加しました。

[2023/03/31]は、LlamaとMedical Knowledge Baseに基づいた微調整指示のモデルリリースを追加しました。

最初に依存関係パッケージをインストールすると、Python Environmentは3.9+をお勧めします

pip install -r requirements.txt

すべてのベースモデルについて、コンピューティングリソースとモデルパフォーマンスを比較検討するための指導微調整トレーニングのために、ハーフエシジョンベースモデルLORA微調整方法を採用します。

Loraのウェイトは、Baidu Netdiskまたは抱きしめる顔からダウンロードできます。

Lora Weightをダウンロードして減圧します。減圧形式は次のとおりです。

**lora-folder-name**/

- adapter_config.json # LoRA权重配置文件

- adapter_model.bin # LoRA权重文件

同じデータに基づいて、Chatglmモデルの医療バージョン:chatglm-6b-medもトレーニングしました

./data/infer.jsonでいくつかのテストケースを提供し、他のデータセットに置き換えることができます。形式は一貫していることに注意してください。

推測スクリプトを実行します

#基于医学知识库

bash ./scripts/infer.sh

#基于医学文献

#单轮

bash ./scripts/infer-literature-single.sh

#多轮

bash ./scripts/infer-literature-multi.sh

Imper.shスクリプトコードは次のとおりです。ベースモデルBase_Model、Lora Weight Lora_Weights、およびTest Dataset Path instruce_Dirを次のコードで交換し、ベースモデルBase_Model、LORA Weight Lora_Weights、およびテストデータセットパスInstand_dirを置き換えた後に実行してください。

python infer.py

--base_model 'BASE_MODEL_PATH'

--lora_weights 'LORA_WEIGHTS_PATH'

--use_lora True

--instruct_dir 'INFER_DATA_PATH'

--prompt_template 'TEMPLATE_PATH'

プロンプトテンプレートの選択はモデルに関連しており、詳細は次のとおりです。

| 可動型タイプとブルーム | ラマ&アルパカ |

|---|---|

templates/bloom_deploy.json | Medical Knowledge Base templates/med_template.jsonに基づいています医学文献 templates/literature_template.jsonに基づいています |

./scripts/test.shを参照することもできます

基本モデルは、医療Q&Aシナリオで制限された効果があり、指導の微調整は、基本モデルに人間の質問に答える能力を持たせるための効率的な方法です。

私たちは、主にCMEKGを指す、オープンで自立した中国の医療知識ベースを採用しました。

医学知識ベースは、疾患、薬物、検査指標などを中心に構築されており、フィールドには合併症、高リスク因子、組織学的検査、臨床症状、薬物治療、補助治療などが含まれます。知識ベースの例は次のとおりです。

{"中心词": "偏头痛", "相关疾病": ["妊娠合并偏头痛", "恶寒发热"], "相关症状": ["皮肤变硬", "头部及眼后部疼痛并能听到连续不断的隆隆声", "晨起头痛加重"], "所属科室": ["中西医结合科", "内科"], "发病部位": ["头部"]}

GPT3.5インターフェイスを使用して、医療知識ベースを中心にQ&Aデータを構築し、知識を最大限に活用するためにさまざまな迅速なフォームを設定しました。

微調整命令のトレーニングセットデータの例は次のとおりです。

"问题:一位年轻男性长期使用可卡因,突然出现胸痛、呕吐、出汗等症状,经检查发现心电图反映心肌急性损伤,请问可能患的是什么疾病?治疗方式是什么?"

回答: 可能患的是心肌梗塞,需要进行维拉帕米、依普利酮、硝酸甘油、ß阻滞剂、吗啡等药物治疗,并进行溶栓治疗、低分子量肝素、钙通道阻滞剂等辅助治疗。此外需要及时停用可卡因等药物,以防止病情加重。"

モデルのトレーニングデータセットを提供し、合計8,000個以上のピースを提供します。トレーニングセットの構築には知識が組み込まれていますが、まだエラーと欠陥があることに注意する必要があります。将来的には、より良い戦略を使用して、データセットを反復して更新します。

命令の微調整データセットの品質は依然として限られており、将来的には反復が実行されます。同時に、医療知識ベースとデータセットの構築コードはまだ整理されており、ソートが完了した後にリリースされます。

さらに、2023年に肝臓がん疾患に関する中国の医学文献を収集し、GPT3.5インターフェースを使用して、医学文献の[結論]の周りに複数のラウンドの質疑応答データを構築しました。・./data_literature/liver_cancer.jsonでは、1Kトレーニングの例を提供します。現在、トレーニングサンプルの品質はまだ限られています。将来的には、データをさらに反復し、公开数据集の形で一般に公開します。トレーニングサンプルの例は次のとおりです。

現在、「がん型肝炎」の単一疾患訓練のためのモデルパラメーターのみを開きます。将来的には、文献の結論を組み込んだ医学的対話データセットを公開し、「肝臓および膵臓」に関連する16の病気のモデルを訓練する予定です。

詳細については、「大きなモデルの医学文献からのインタラクティブな知識の獲得を探る」記事を参照してください。

独自のデータセットで大規模な言語モデルを微調整したい場合は、 ./data/llama_data.json llama_data.jsonの形式で独自のデータセットを作成してください

Finetuneスクリプトを実行します

bash ./scripts/finetune.sh

Llamaモデルに基づいた微調整プロセスの際に、A100-SXM-80GBグラフィックスカードのトレーニングを行いました。トレーニングラウンドの合計は10ラウンドで、約2H17mかかりました。 batch_size = 128を使用すると、ビデオメモリは約40gを占有します。 3090/4090グラフィックカード(24GBグラフィックメモリ)以上がよりよくサポートされ、batch_sizeがグラフィックメモリのサイズに応じて調整されることが予想されます。

ハイパーパラメーターの設定と実験手順については、WANDBのリンクを参照してください。

https://wandb.ai/thinksoso/llama_med/runs/a5wgcnzt/overview?workspace=user-thinksoso

注:2023年3月にテスト

| テスト入力 | ラマ出力 | アルパカ出力 | ベンツァオマテリアメディカ |

|---|---|---|---|

| シャオ・チャンは最近気分が悪く、動pitや息切れなどの症状があります。身体検査では、心臓が拡大し、脈動が弱くなっていることがわかりました。 | 質問:Xiao Zhangは最近気分が悪く、動pitや息切れなどの症状があります。身体検査では、心臓が拡大し、脈動が弱くなっていることがわかりました。 | 最近、Xiao Zhangは不快に感じており、動揺や息切れなどの症状があります。身体検査は、心臓が拡大し、筋肉が弱いことを示しています。 | Xiao Zhangは心筋炎に苦しむ可能性があるため、できるだけ早く検査と治療のために病院に行くことをお勧めします。治療の選択肢には、薬物療法と外科的治療が含まれます。 |

| ハンセン病と子供時代の喘息の原因は一貫していますか? | 子供の喘息とハンセン病の原因は一貫していますが、子供の喘息とハンセン病の原因は一貫していません | はい、喘息と子供にも同様の原因があります。 | 一貫性のない、ハンセン病の原因はハンセン病性感染症であり、子供の喘息の原因は、摂食や喫煙不良などの要因です。 |

| 患者は持続的な腫れと黄undを発症しました。イメージング検査後、肝臓ダクト石病。どのような治療計画をとるべきですか? | 肝乳管管疾患の患者はどのような治療計画を立てるべきですか? | 患者は手術と化学療法の組み合わせを受ける必要があります。 | 肝臓のダクト結石疾患の場合、治療計画には外科的治療、薬物治療、補助治療が含まれます。特定の治療計画は、患者の特定の状況に従って決定する必要があります。 |

Q:なぜ「ベンカオ」と改名されたのですか?

A:Scir Laboratoryの大規模な言語モデルの名前の一貫性と中国の医療モデルの名前は、「物質的な漢方薬」に調整されています。

Q:なぜ「hua tuo」ではなく「hua tuo」なのですか?

A:私たちの基本的なモデルラマはラマで、アルパカはアルパカであるため、「ラクダ」と呼ばれます。彼らの名前とHua Tuoの同性愛者の鳴き声に触発されて、私たちはモデルHua Tuoと名付けました。

Q:使用されている伝統的な漢方薬理論や伝統的な漢方薬のデータはありますか?

A:いいえ

Q:モデルの実行の結果は異なり、効果は限られています

A:生成モデルの生成的多様性が考慮されているため、複数の実行の結果は異なる場合があります。現在のオープンソースモデルは、ラマとアルパカの中国のコーパスで制限されており、知識を組み合わせる方法は比較的粗いです。ブルームベースの可動型ベースのモデルを試してください。

Q:モデルが実行できません/推論コンテンツは完全に受け入れられません

A:インストールされた要件の依存関係を決定し、CUDA環境を構成し、環境変数を追加し、ダウンロードされたモデルとLORAストレージの場所を正しく入力してください。推論コンテンツが複製されているか、いくつかの間違ったコンテンツがラマベースのモデルの時折の現象に属している場合、それはラマモデルの中国能力、トレーニングデータスケール、およびハイパーパラメーター設定と特定の関係を持っています。可動型に基づいて新しいモデルを試してください。深刻な問題がある場合は、実行中のファイル名、モデル名、LORA、およびその他の構成情報を詳細に説明してください。ありがとう。

Q:リリースされたいくつかのモデルのうち、最高のモデルはどれですか?

A:私たちの経験によると、可動型モデルに基づく効果は比較的優れています。

このプロジェクトは、ワン・ハオチュン、デュ・ヤンルイ、リュー・チー、バイ・ルイ、シヌワ、チェン・ユハン、Qiang Zewen、チェン・ジアニュ、リージジャンによって完了しました。インストラクターは、Zhao Sendong教授、Qin Bing教授、Li Ting教授です。

このプロジェクトは、次のオープンソースプロジェクトを参照しており、関連するプロジェクトと研究開発スタッフに感謝の気持ちを表明したいと思います。

このプロジェクトに関連するリソースは、学術研究のみであり、商業目的で厳密に禁止されています。サードパーティコードを含むパーツを使用する場合は、対応するオープンソースプロトコルに厳密に従ってください。モデルによって生成されるコンテンツは、モデルの計算、ランダム性、定量的精度損失などの要因の影響を受けます。このプロジェクトは、その精度を保証することはできません。このプロジェクトのデータセットのほとんどはモデルによって生成され、特定の医学的事実に準拠していても、実際の医療診断の基礎として使用することはできません。このプロジェクトは、モデルによるコンテンツ出力に対する法的責任を想定しておらず、関連するリソースと出力結果の使用から生じる可能性のある損失についても責任を負いません。

このプロジェクトのデータまたはコードを使用した場合、または私たちの仕事があなたに役立つ場合は、見積もりを宣言してください

初版技術レポート:Huatuo:中国の医療知識を備えたLlamaモデルのチューニング

@misc{wang2023huatuo,

title={HuaTuo: Tuning LLaMA Model with Chinese Medical Knowledge},

author={Haochun Wang and Chi Liu and Nuwa Xi and Zewen Qiang and Sendong Zhao and Bing Qin and Ting Liu},

year={2023},

eprint={2304.06975},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

中国語で信頼できる対応生成のための構造化された医療知識ベースを持つ知識調整大規模な言語モデル

@misc{wang2023knowledgetuning,

title={Knowledge-tuning Large Language Models with Structured Medical Knowledge Bases for Reliable Response Generation in Chinese},

author={Haochun Wang and Sendong Zhao and Zewen Qiang and Zijian Li and Nuwa Xi and Yanrui Du and MuZhen Cai and Haoqiang Guo and Yuhan Chen and Haoming Xu and Bing Qin and Ting Liu},

year={2023},

eprint={2309.04175},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

カラデータセット:中国の医学文献からのLLMSのインタラクティブな知識習得の調査

@misc{du2023calla,

title={The CALLA Dataset: Probing LLMs' Interactive Knowledge Acquisition from Chinese Medical Literature},

author={Yanrui Du and Sendong Zhao and Muzhen Cai and Jianyu Chen and Haochun Wang and Yuhan Chen and Haoqiang Guo and Bing Qin},

year={2023},

eprint={2309.04198},

archivePrefix={arXiv},

primaryClass={cs.CL}

}