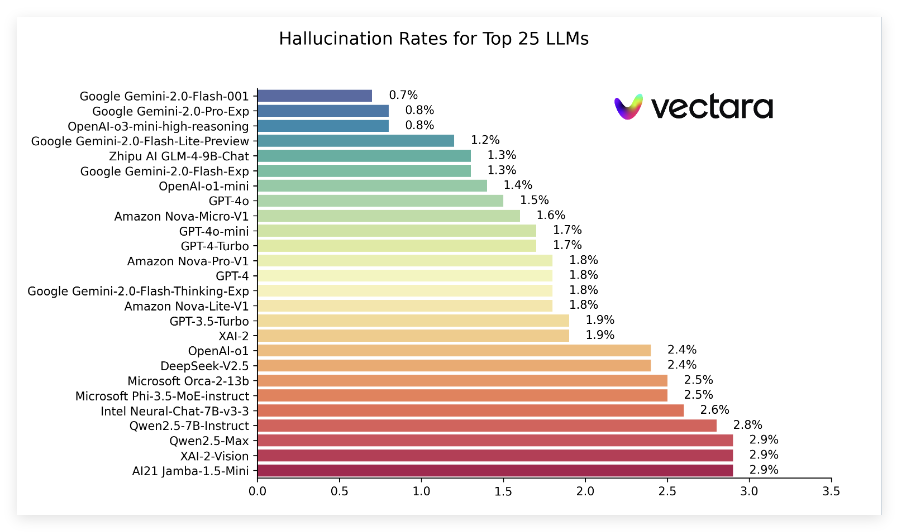

Recentemente, a Vectara divulgou um relatório chamado "Lista de alucinações", comparando o desempenho das alucinações produzidas por diferentes modelos de grandes idiomas (LLMS) ao resumir documentos curtos. Esse ranking utiliza o modelo de avaliação de Hughes Hughes Hallucination (HHEM-2.1), que é atualizado regularmente para avaliar com que frequência esses modelos introduzem informações falsas no resumo. De acordo com os dados mais recentes, o relatório aponta indicadores -chave, como taxa de alucinação, taxa de consistência factual, taxa de resposta e duração média de resumo de uma série de modelos populares.

Nas classificações mais recentes, a série Gemini2.0 do Google teve um bom desempenho, especialmente Gemini-12.0-Flash-001, liderou a lista com uma baixa taxa de alucinação de 0,7%, mostrando que introduziu poucas informações falsas ao processar documentos. Além disso, os modelos Gemini-2.0-Pro-EXP e OpenAi O3-Mini-L-Alter-L-Longeing seguiram de perto com uma taxa de alucinação de 0,8%e tiveram um bom desempenho.

O relatório também mostra que, embora as taxas de alucinação em muitos modelos tenham aumentado, a maioria permanece em um nível baixo e as taxas de consistência factual para vários modelos estão acima de 95%, indicando que são relativamente fortes para garantir que as informações sejam verdadeiras. É particularmente digno de nota que as taxas de resposta dos modelos geralmente são altas, com a grande maioria dos modelos se aproximando de 100%, o que significa que eles têm um bom desempenho na compreensão e resposta a perguntas.

Além disso, a lista de classificação também menciona os comprimentos resumidos médios de diferentes modelos, indicando as diferenças nas capacidades do modelo em termos de concentração de informações. No geral, essa classificação não apenas fornece dados de referência importantes para pesquisadores e desenvolvedores, mas também fornece conveniência para os usuários comuns entenderem o desempenho dos grandes modelos de idiomas atuais.

Entrada de classificação específica: https://github.com/vectara/hallucination-leaderboard

Pontos -chave:

Os últimos rankings de ilusão avaliam o desempenho de diferentes modelos de grandes idiomas no resumo de documentos.

Os modelos Gemini Series do Google tiveram um bom desempenho, com taxas de alucinação tão baixas quanto 0,7%.

A taxa de resposta do modelo é próxima de 100%, mostrando sua eficiência no processamento de informações.