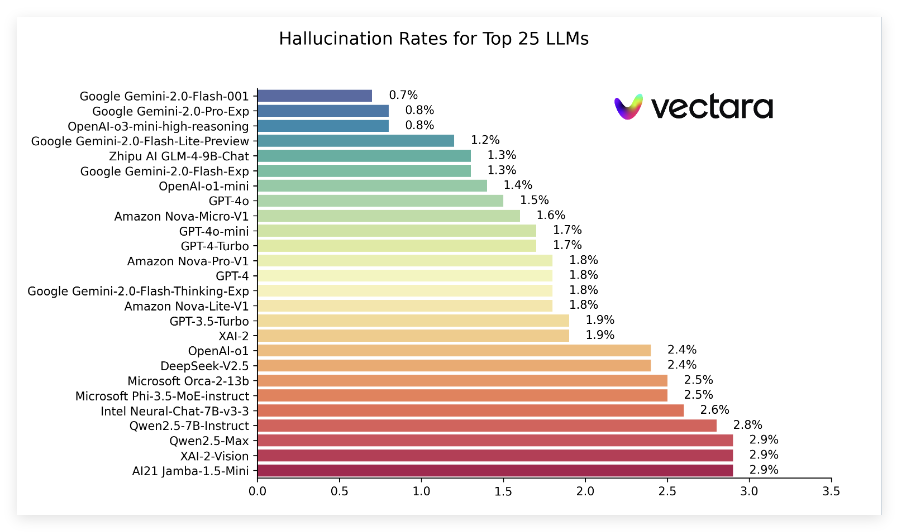

최근 Vectara는 "환각 목록"이라는 보고서를 발표하여 짧은 문서를 요약 할 때 다양한 대형 언어 모델 (LLM)에 의해 생성 된 환각의 성능을 비교했습니다. 이 순위는 Vectara의 Hughes 환각 평가 모델 (HHEM-2.1)을 사용하며, 이러한 모델이 요약에 허위 정보를 얼마나 자주 소개하는지 평가하기 위해 정기적으로 업데이트됩니다. 최신 데이터에 따르면, 보고서는 환각율, 사실 일관성 속도, 응답 속도 및 일련의 인기있는 모델의 평균 요약 길이와 같은 주요 지표를 지적합니다.

최신 순위에서 Google의 Gemini2.0 시리즈, 특히 Gemini-2.0-Flash-001은 환각율이 0.7%로 낮아서 문서를 처리 할 때 허위 정보가 거의 도입되었음을 보여주었습니다. 또한 Gemini-2.0-Pro-EXP 및 OpenAi의 O3-Mini-High-Arciseing 모델은 환각율이 0.8%와 밀접한 관련이 있으며 잘 수행되었습니다.

이 보고서는 또한 많은 모델의 환각 속도가 증가했지만 대부분은 낮은 수준으로 유지되며 여러 모델의 사실 일관성 비율은 95%이상이므로 정보가 사실인지 확인하는 데 상대적으로 강력하다는 것을 나타냅니다. 특히 모델의 응답 속도가 일반적으로 높으며 대부분의 모델이 100%에 가까워지면서 질문에 대한 이해와 응답에 잘 수행됩니다.

또한 순위 목록은 다른 모델의 평균 요약 길이를 언급하여 정보 집중 측면에서 모델의 기능의 차이를 나타냅니다. 전반적 으로이 순위는 연구원과 개발자에게 중요한 참조 데이터를 제공 할뿐만 아니라 일반 사용자가 현재 대형 언어 모델의 성능을 이해할 수있는 편의성을 제공합니다.

특정 순위 입구 : https://github.com/vectara/hallucination-leaderboard

핵심 사항 :

최신 환상 순위는 문서 요약에서 다양한 대형 언어 모델의 성능을 평가합니다.

Google의 Gemini 시리즈 모델은 환각율이 0.7%로 낮습니다.

모델의 응답 속도는 100%에 가까워 정보 처리의 효율성을 보여줍니다.