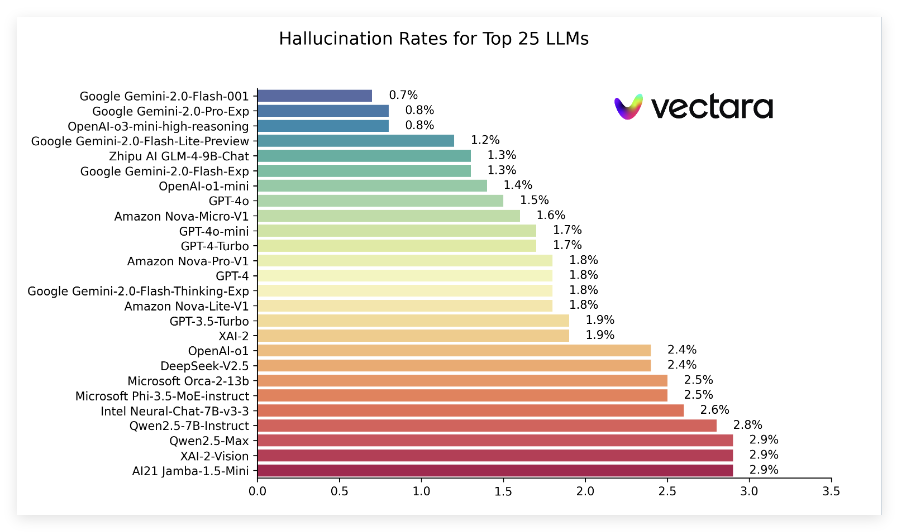

Recientemente, Vectara publicó un informe llamado "Lista de alucinaciones", comparando el rendimiento de las alucinaciones producidas por diferentes modelos de idiomas (LLM) al resumir documentos cortos. Esta clasificación utiliza el Modelo de Evaluación de Alucinación Hughes Hughes (HHEM-2.1) de Vacerara (HHEM-2.1), que se actualiza regularmente para evaluar con qué frecuencia estos modelos introducen información falsa en el resumen. Según los últimos datos, el informe señala indicadores clave como la tasa de alucinación, la tasa de consistencia objetiva, la tasa de respuesta y la longitud de resumen promedio de una serie de modelos populares.

En las últimas clasificaciones, la serie Gemini2.0 de Google funcionó bien, especialmente Gemini-2.0-Flash-001, encabezó la lista con una baja tasa de alucinación de 0.7%, lo que demuestra que introdujo poca información falsa al procesar documentos. Además, los modelos Gemini-2.0-Pro-Exc y O3-Mini de O3-Mini de OpenAI siguieron de cerca con una tasa de alucinación del 0,8%, y se desempeñaron bien.

El informe también muestra que, aunque las tasas de alucinación en muchos modelos han aumentado, la mayoría permanece en un nivel bajo y las tasas de consistencia objetiva para múltiples modelos están por encima del 95%, lo que indica que son relativamente fuertes para garantizar que la información sea cierta. Es particularmente notable que las tasas de respuesta de los modelos son generalmente altas, con la gran mayoría de los modelos que se acercan al 100%, lo que significa que funcionan bien en la comprensión y la respuesta a las preguntas.

Además, la lista de clasificación también menciona las longitudes de resumen promedio de diferentes modelos, lo que indica las diferencias en las capacidades del modelo en términos de concentración de información. En general, esta clasificación no solo proporciona datos de referencia importantes para investigadores y desarrolladores, sino que también proporciona conveniencia para que los usuarios comunes comprendan el rendimiento de los modelos de idiomas grandes actuales.

Entrada de clasificación específica: https://github.com/vectara/hallucination-leaderboard

Puntos clave:

Las últimas clasificaciones de ilusión evalúan el rendimiento de diferentes modelos de idiomas grandes en el resumen de documentos.

Los modelos de la serie Gemini de Google funcionaban bien, con tasas de alucinación tan bajas como 0.7%.

La tasa de respuesta del modelo está cerca del 100%, que muestra su eficiencia en el procesamiento de la información.