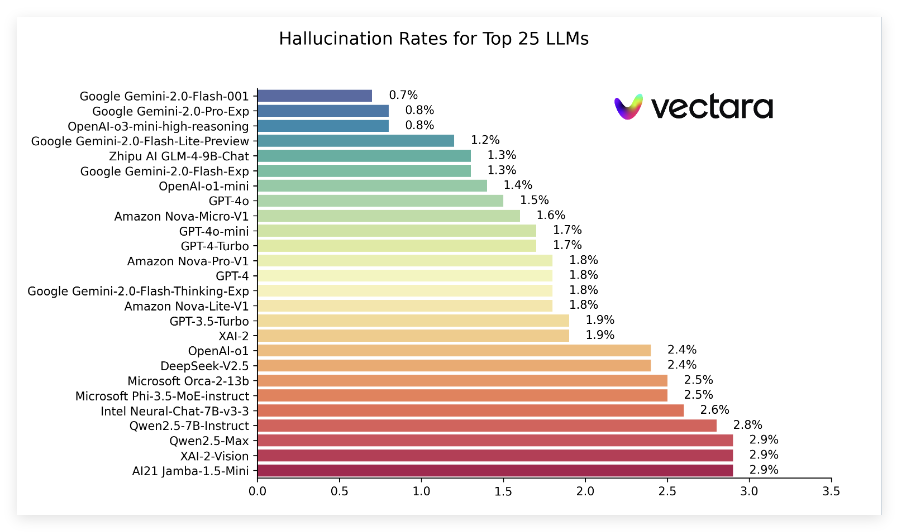

في الآونة الأخيرة ، أصدرت Vectara تقريرًا بعنوان "قائمة الهلوسة" ، مقارنة بأداء الهلوسة التي تنتجها نماذج لغة كبيرة مختلفة (LLMS) عند تلخيص المستندات القصيرة. يستخدم هذا الترتيب نموذج تقييم الهلوسة فيكتارا (HHEM-2.1) ، والذي يتم تحديثه بانتظام لتقييم عدد مرات إدخال هذه النماذج معلومات خاطئة في الملخص. وفقًا لأحدث البيانات ، يشير التقرير إلى مؤشرات رئيسية مثل معدل الهلوسة ، ومعدل الاتساق الواقعية ، ومعدل الاستجابة ، ومتوسط طول ملخص لسلسلة من النماذج الشعبية.

في أحدث التصنيفات ، تصدرت سلسلة gemini2.0 من Google بشكل جيد ، وخاصة Gemini-2.0-flash-001 ، تصدرت القائمة بمعدل الهلوسة المنخفض بنسبة 0.7 ٪ ، مما يدل على أنها قدمت معلومات خاطئة قليلة عند معالجة المستندات. بالإضافة إلى ذلك ، تبعت نماذج Gemini-2.0-Pro-EXP و Openai من O3-Mini-High-Righting عن كثب معدل الهلوسة بنسبة 0.8 ٪ ، وأداء جيد.

يوضح التقرير أيضًا أنه على الرغم من أن معدلات الهلوسة في العديد من النماذج قد زادت ، إلا أن معظمها تظل على مستوى منخفض ، وأن معدلات الاتساق الواقعية لنماذج متعددة تتجاوز 95 ٪ ، مما يشير إلى أنها قوية نسبيًا في ضمان أن المعلومات صحيحة. تجدر الإشارة بشكل خاص إلى أن معدلات الاستجابة للنماذج مرتفعة بشكل عام ، حيث تقترب الغالبية العظمى من النماذج بنسبة 100 ٪ ، مما يعني أنها تؤدي بشكل جيد في فهم الأسئلة والرد عليها.

بالإضافة إلى ذلك ، تذكر قائمة الترتيب أيضًا متوسط أطوال الملخص للنماذج المختلفة ، مما يشير إلى الاختلافات في إمكانات النموذج من حيث تركيز المعلومات. بشكل عام ، لا يوفر هذا الترتيب بيانات مرجعية مهمة للباحثين والمطورين فحسب ، بل يوفر أيضًا الراحة للمستخدمين العاديين لفهم أداء نماذج اللغة الكبيرة الحالية.

مدخل ترتيب محدد: https://github.com/vectara/hallucination-leaderboard

النقاط الرئيسية:

أحدث تصنيفات الوهم تقيّم أداء نماذج اللغة الكبيرة المختلفة في ملخص المستند.

تم أداء نماذج سلسلة Gemini من Google بشكل جيد ، حيث كانت معدلات الهلوسة منخفضة تصل إلى 0.7 ٪.

يقترب معدل استجابة النموذج من 100 ٪ ، مما يدل على كفاءته في معالجة المعلومات.