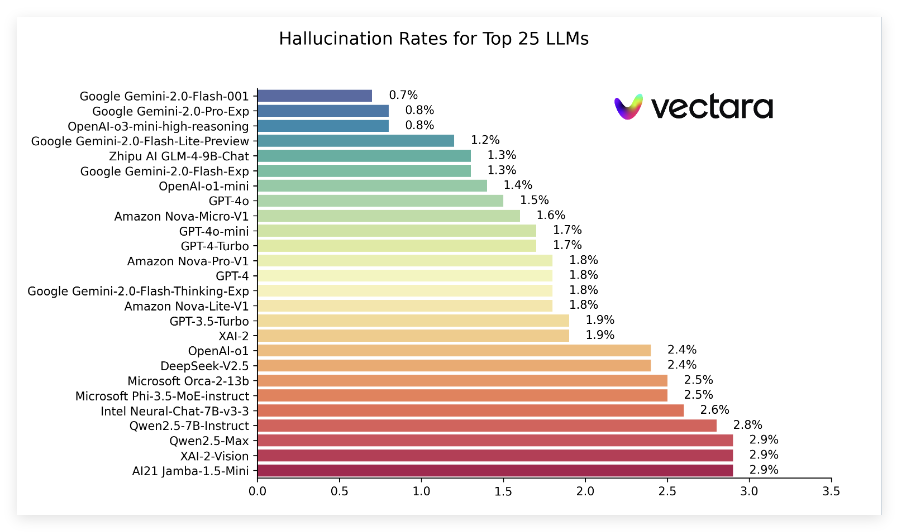

Kürzlich veröffentlichte Vectara einen Bericht mit dem Titel "Liste der Halluzinationen", in dem die Leistung von Halluzinationen verglichen wird, die durch verschiedene Großsprachenmodelle (LLMs) erzeugt werden, wenn kurze Dokumente zusammengefasst werden. In diesem Ranking wird Vectaras Hughes Halluzinationsbewertungsmodell (HHEM-2.1) verwendet, das regelmäßig aktualisiert wird, um zu bewerten, wie oft diese Modelle falsche Informationen in die Zusammenfassung einführen. Nach den neuesten Daten weist der Bericht auf wichtige Indikatoren wie die Halluzinationsrate, die sachliche Konsistenzrate, die Rücklaufquote und die durchschnittliche Zusammenfassung einer Reihe beliebter Modelle hin.

In den neuesten Ranglisten zeigte die Gemini2.0-Serie von Google gut, insbesondere Gemini-2,0-Flash-001, was die Liste mit einer niedrigen Halluzinationsrate von 0,7%anführte, was zeigt, dass bei der Bearbeitung von Dokumenten nur wenige falsche Informationen eingeführt wurden. Darüber hinaus folgten Gemini-2,0-PRO-EXP und Openai's O3-Mini-Hochsemodelle eng mit einer Halluzinationsrate von 0,8%und gut ab.

Der Bericht zeigt auch, dass die Halluzinationsraten in vielen Modellen zwar gestiegen sind, die meisten auf einem niedrigen Niveau bleiben und die sachlichen Konsistenzraten für mehrere Modelle über 95%liegen, was darauf hinweist, dass sie relativ stark sind, um sicherzustellen, dass die Informationen wahr sind. Es ist besonders bemerkenswert, dass die Antwortquoten von Modellen im Allgemeinen hoch sind, wobei die überwiegende Mehrheit der Modelle 100%nähert, was bedeutet, dass sie sich gut im Verständnis und beim Beantworten von Fragen abgeben.

Darüber hinaus erwähnt die Rangliste auch die durchschnittlichen Zusammenfassungslängen verschiedener Modelle, was auf die Unterschiede in den Fähigkeiten des Modells hinsichtlich der Informationskonzentration hinweist. Insgesamt bietet dieses Ranking nicht nur wichtige Referenzdaten für Forscher und Entwickler, sondern auch für normale Benutzer, um die Leistung aktueller Großsprachenmodelle zu verstehen.

Spezifischer Ranking-Eingang: https://github.com/vectara/hallucination-leaderboard

Schlüsselpunkte:

Die neuesten Illusion -Rankings bewerten die Leistung verschiedener Großsprachenmodelle in der Zusammenfassung der Dokumente.

Die Modelle der Gemini -Serien von Google haben sich gut mit Halluzinationsraten von nur 0,7%entwickelt.

Die Rücklaufquote des Modells liegt nahe bei 100%und zeigt die Effizienz bei der Informationsverarbeitung.