最近、Vectaraは「幻覚のリスト」というレポートをリリースしました。短い文書を要約する際に、異なる大手言語モデル(LLMS)によって生成された幻覚のパフォーマンスを比較しました。このランキングは、VectaraのHughes Hallucination Assessment Model(HHEM-2.1)を利用しています。これは、これらのモデルが誤った情報を要約に導入する頻度を評価するために定期的に更新されます。最新のデータによると、レポートは、幻覚率、事実上の一貫性率、回答率、一連の一般的なモデルの平均概要の長さなどの重要な指標を指摘しています。

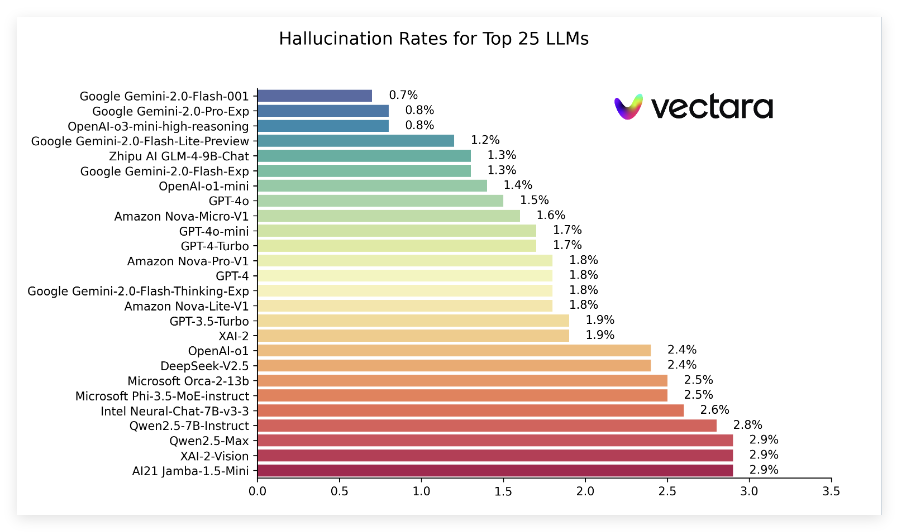

最新のランキングでは、GoogleのGemini2.0シリーズがうまく機能しました。特にGemini-2.0-Flash-001は、幻覚率が0.7%の低いリストで、ドキュメントの処理時に誤った情報がほとんど導入されていないことを示しています。さらに、Gemini-2.0-Pro-ExpおよびOpenaiのO3-Mini-High-Reasoningモデルは、幻覚速度0.8%で密接に続き、うまく機能しました。

また、レポートは、多くのモデルの幻覚率が増加しているが、ほとんどが低レベルのままであり、複数のモデルの事実上の一貫性率は95%を超えており、情報が真実であることを保証するのに比較的強いことを示していることを示しています。モデルの回答率が一般的に高く、モデルの大部分が100%に近づいていることは一般的に高くなることは特に注目に値します。

さらに、ランキングリストには、異なるモデルの平均要約長さも言及しており、情報集中の観点からモデルの機能の違いを示しています。全体として、このランキングは、研究者と開発者に重要な参照データを提供するだけでなく、通常のユーザーが現在の大規模な言語モデルのパフォーマンスを理解するための利便性を提供します。

特定のランキングの入り口:https://github.com/vectara/hallucination-leaderboard

キーポイント:

最新の錯覚ランキングは、ドキュメントの要約で異なる大規模な言語モデルのパフォーマンスを評価します。

GoogleのGeminiシリーズモデルはうまく機能し、幻覚率は0.7%です。

モデルの回答率は100%に近く、情報処理の効率を示しています。